14 prácticas para crear listas aptas para IA y LLMs (2025)

Descubre 14 prácticas clave para diseñar listas y chunks perfectos para LLMs como ChatGPT, Perplexity y AI Overviews. Actualízate en 2025 y destaca.

Si tus guías y posts siguen siendo párrafos largos con viñetas dispersas, es probable que los LLMs (ChatGPT, Perplexity) y las superficies generativas (Google AI Overview) no puedan citarlos ni reutilizarlos bien. Este artículo resume prácticas concretas para convertir un listicle tradicional en una “lista apta para IA”: estructura predecible, chunking semántico, datos estructurados, evidencias y validación cruzada.

Criterios de selección: priorizamos legibilidad por LLM (30%), consistencia semántica (25%), facilidad de implementación (20%), evidencia disponible (15%) e impacto probable en AI SERPs (10).

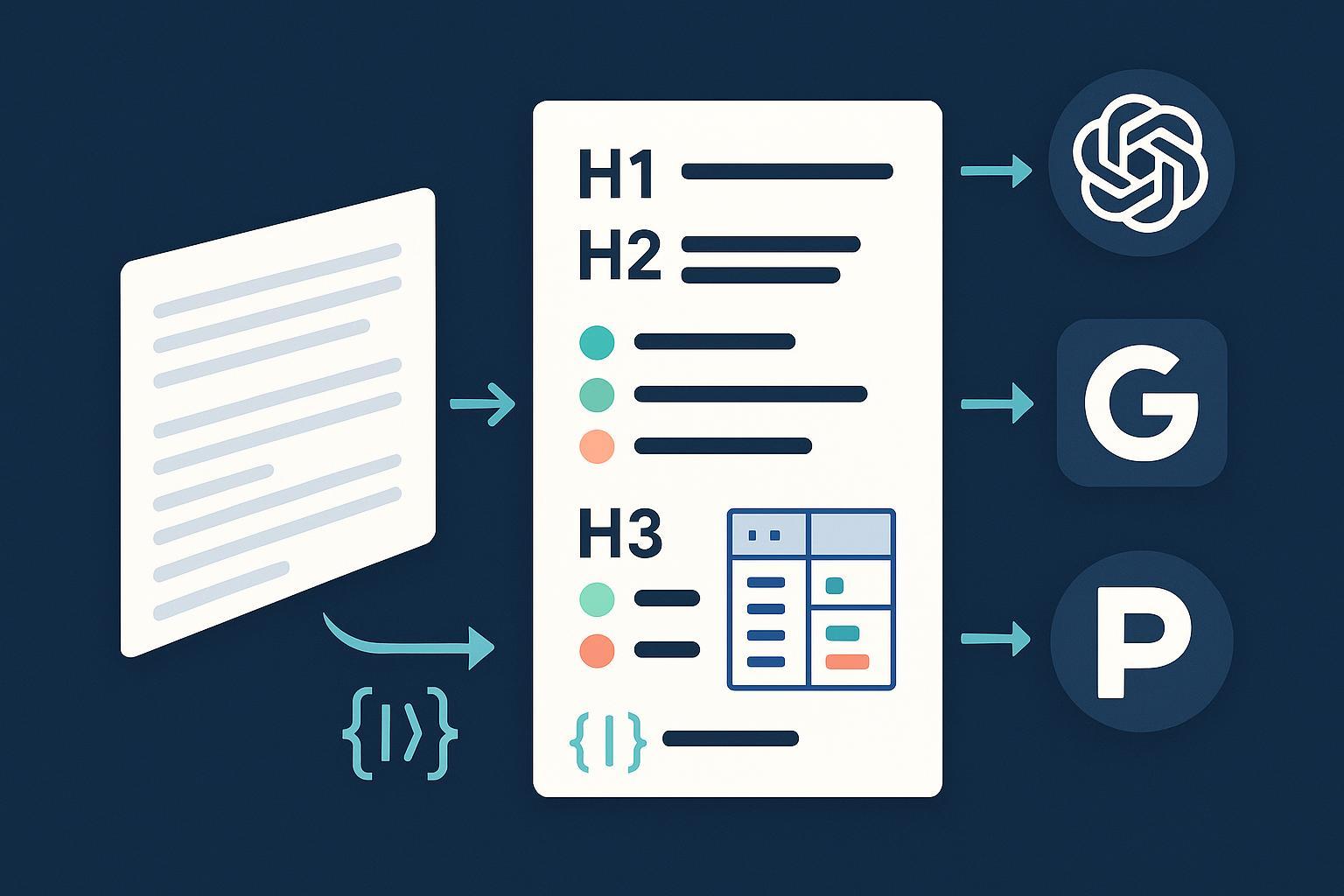

Fase 1 — Estructura base

1) Diseña una jerarquía H1–H3 estable y predecible

- Qué es: títulos que reflejan una arquitectura clara (H1 único; H2 por secciones; H3 para subtemas).

- Por qué les importa a los LLMs:

- Segmenta el contenido en bloques con propósito claro, facilitando la extracción y la citación.

- Mejora la comprensión tema→subtema, útil para respuestas resumidas.

- Cómo implementarlo (checklist):

- Un H1 descriptivo con el año si el tema es sensible al tiempo.

- H2 por fases (p. ej., estructura, formato, validación) y H3 para cada práctica.

- Evita saltos de nivel (no pases de H2 a H4).

- Pitfalls: títulos “creativos” sin semántica; múltiples H1.

- Evidencia: la optimización por “recurso” priorizado por cada LLM requiere estructura clara, como explica Cyberclick (2024–2025) sobre posicionamiento en diferentes LLM.

2) Usa listas numeradas para pasos y viñetas para agrupaciones

- Qué es: numeradas cuando hay orden; viñetas cuando no.

- Por qué les importa a los LLMs:

- Permite extraer “paso a paso” o “bullet points” con fidelidad.

- Cómo implementarlo:

- Convierte párrafos en “procedimientos” cuando corresponda.

- Mantén cada bullet en una sola idea, con verbo de acción al inicio.

- Mini‑ejemplo (antes/después):

- Antes: “Para configurar, asegúrate de X y luego prueba Y. También conviene Z…”.

- Después:

- Verifica X en ajustes.

- Ejecuta la prueba Y.

- Documenta el resultado Z.

- Evidencia: los patrones de FAQ/HowTo formalizan pasos y preguntas en Search Central; consulta HowTo en la documentación oficial.

Fase 2 — Chunking y control de contexto

3) Practica el “chunking semántico” (bloques de 300–600 palabras aprox.)

- Qué es: dividir por unidades coherentes (un objetivo por bloque).

- Por qué les importa a los LLMs:

- Reduce alucinaciones y mejora la recuperación precisa en RAG.

- Cómo implementarlo:

- Asocia cada H3 a 1 propósito, con lista/tabla si procede.

- Evita bloques sin foco (dos temas en el mismo tramo).

- Pitfalls: fragmentación excesiva (bloques de 1–2 frases sin contexto).

- Evidencia: prácticas de chunking y embeddings en la guía de Elastic para experiencias de IA generativa y recomendaciones para reducir alucinaciones en Skimai (2024) sobre grounding en LLM.

4) Controla la longitud de tokens por bloque (model‑aware)

- Qué es: diseñar pensando en la ventana de contexto y la salida por modelo.

- Cómo orientarte en 2025 (aprox., revisar docs del proveedor):

- GPT‑4o: hasta 128k tokens de contexto; GPT‑4.1 anunciado con ventanas largas y mejoras de manejo de contexto según OpenAI (2025).

- Claude 3.5 Sonnet: ventana de 200k tokens, según Anthropic Docs (2025) sobre context windows.

- Gemini 1.5 Pro: hasta 2M tokens de contexto, ver Google AI (2025) guía de long context.

- Reglas prácticas:

- Prioriza coherencia temática sobre exprimir la ventana.

- Mantén salida esperada en 150–400 palabras por respuesta parcial, salvo casos técnicos.

Fase 3 — Formatos, datos estructurados y señalización

5) Añade datos estructurados (FAQ/HowTo/Article) cuando aplique

- Qué es: marcado JSON‑LD para guiar a motores y superficies generativas.

- Cómo implementarlo:

- Article/BlogPosting con datePublished y dateModified.

- FAQPage para preguntas frecuentes reales visibles en la página.

- HowTo para “paso a paso” que realmente lo sea.

- Ejemplo breve (Article con fechas):

{ "@context": "https://schema.org", "@type": "BlogPosting", "headline": "Listas aptas para IA (2025)", "datePublished": "2025-09-11", "dateModified": "2025-09-11" } - Evidencia: consulta la introducción a datos estructurados en Search Central (JSON‑LD recomendado), y las guías de FAQPage y HowTo.

6) Define entidades clave y refuerza E‑E‑A‑T

- Qué es: biografías de autor, definición de la marca, políticas y fuentes.

- Por qué les importa a los LLMs:

- Reduce ambigüedad de entidades; mejora confianza y citabilidad.

- Cómo implementarlo:

- Página de autor con credenciales y enlaces a publicaciones.

- Sección “Metodología/criterios” (ver ítem 14) y políticas editoriales.

- Evidencia: Google ha endurecido políticas de calidad y spam (marzo 2024), reforzando señales de autoridad; revisa el anuncio del core update y políticas de spam (2024) en Search Central.

7) Construye tablas comparativas con criterios homogéneos y accesibles

-

Qué es: tablas con los mismos campos por fila y encabezados claros.

-

Cómo implementarlo (microejemplo Markdown):

Criterio Opción A Opción B Precio/mes 29 € 39 € Soporte Email Email + chat Exportación CSV CSV/JSON - En HTML, usa

y para accesibilidad. Pitfalls: mezclar métricas (€/mes vs. €/año) o definir campos diferentes por fila.

Evidencia: buenas prácticas de tablas accesibles en guías WAI; referencia una síntesis en W3C/WAI (principios de tablas con scope/caption).

8) Enlaza con anclas descriptivas y contexto antes/después

- Qué es: enlaces con texto que describe el dato o la fuente, con 1–2 frases de contexto.

- Cómo implementarlo:

- “Según la [guía de datos estructurados de Google]…”, no “aquí”.

- Evita listas de enlaces sin explicación.

- Evidencia: prácticas recomendadas de estructura semántica y enlazado están respaldadas por Search Central; revisa la introducción a datos estructurados (Google).

9) Señales de actualidad: fecha visible y versión

- Qué es: indicar “Última revisión” y versionado si procede.

- Cómo implementarlo:

- Fecha visible al comienzo o final.

- JSON‑LD con datePublished/dateModified (ver ítem 5).

- Evidencia: mantener frescura y transparencia favorece la priorización en queries sensibles al tiempo; apóyate en Article/BlogPosting y propiedades de fecha de Search Central.

10) Cita evidencia cerca de las afirmaciones clave

- Qué es: anclar fuentes originales junto a los datos importantes.

- Por qué les importa a los LLMs:

- Perplexity muestra citas clicables y valora la trazabilidad del contenido.

- Cómo implementarlo:

- Usa 1–2 fuentes primarias por dato relevante.

- Evita enlaces a resúmenes cuando exista el original.

- Evidencia: revisa el enfoque de citación y elegibilidad en el Perplexity Publishers Program (2025) y su changelog/documentación.

Fase 4 — Anti‑patrones y consistencia

11) Evita anti‑patrones que confunden a los LLMs

- Qué evitar:

- Listas infinitas sin criterios ni orden.

- Bloques duplicados o boilerplate entre páginas.

- Tablas sin encabezados o con campos heterogéneos.

- FAQs invisibles para el usuario o sin respuesta clara.

- Evidencia: el core update de 2024 y las políticas anti‑spam apuntan contra contenido poco útil; ver anuncio de Google (marzo 2024).

12) Mantén metadatos y snippets consistentes

- Qué es: títulos/meta descripciones/anchors alineados con la intención y el contenido del bloque.

- Cómo implementarlo:

- Ajusta title/description a la fase (guías, comparativas, FAQs).

- Evita keyword stuffing; prioriza claridad y utilidades.

- Evidencia: prácticas generales de Search Central sobre marcado y metadatos; ver la introducción a datos estructurados (Google).

Fase 5 — Validación, medición y toolbox

13) Valida en ChatGPT, Perplexity y Google AI Overviews (spot‑checks)

- Qué hacer (flujo rápido):

- Define 5–10 queries objetivo por pieza.

- Prueba en ChatGPT (GPT‑4o) y observa si extrae pasos/tablas tal como las diseñaste.

- Prueba en Perplexity y revisa si te cita y qué fragmentos usa.

- En Google, verifica la presencia/ausencia en AI Overviews para esas queries.

- Ajusta headings, chunks y FAQs según hallazgos.

- Evidencia: lanzamiento y soporte de AI Overviews en España documentado por Google; consulta la ayuda oficial (2025).

14) Toolbox: monitoriza visibilidad y sentimiento en superficies de IA

- Para equipos que necesitan seguimiento continuo, estas opciones pueden ayudar a auditar citas y rendimiento:

- Geneo: plataforma para monitorizar visibilidad de marca, menciones y sentimiento en superficies de IA (ChatGPT, Perplexity, AI Overviews), con histórico y recomendaciones. Divulgación: Geneo es nuestro producto.

- Suites de analítica/SEO que reportan presencia en features de SERP: útiles si ya están en tu stack y tu presupuesto es limitado.

- Flujos manuales: muestreo semanal de queries en ChatGPT/Perplexity, revisión de AI Overviews y registro en hojas de cálculo para detectar patrones.

- Plataformas de social listening/brand monitoring: captan menciones y tono en contenidos generados y redes.

- Nota: Elige según recursos y madurez del equipo; prioriza trazabilidad y capacidad de iteración.

Minichecklists por tipo de contenido

-

Para blogs B2B

- H2 por problema/solución; H3 por táctica.

- 1 tabla comparativa con criterios homogéneos.

- 2–3 FAQs reales con JSON‑LD.

-

Para documentación de producto

- HowTo/Procedure con pasos numerados y prerequisitos.

- Capturas con texto alternativo descriptivo.

- Versionado visible y dateModified en JSON‑LD.

-

Para comparativas

- Tabla accesible con unidades consistentes.

- Definición breve de criterios.

- Enlaces a fuentes primarias por métrica crítica.

Micro‑ejemplos útiles

-

FAQ mínima (visible + JSON‑LD):

Pregunta: ¿Qué es el chunking semántico?

Respuesta: Es dividir el contenido en bloques coherentes y autocontenidos, facilitando su recuperación por LLMs y reduciendo alucinaciones.

{ "@context": "https://schema.org", "@type": "FAQPage", "mainEntity": [{ "@type": "Question", "name": "¿Qué es el chunking semántico?", "acceptedAnswer": { "@type": "Answer", "text": "Es dividir el contenido en bloques coherentes y autocontenidos, facilitando su recuperación por LLMs y reduciendo alucinaciones." } }] } -

Conversión de párrafo a pasos

Antes: “Primero deberías auditar, luego ver si te citan, y si no, cambiar el formato…”

Después:

- Audita tu pieza con 5–10 queries.

- Revisa si hay citas en Perplexity y AI Overviews.

- Ajusta headings, FAQs y tablas según resultados.

Metodología y criterios (“Cómo lo elegimos”)

- Criterios de priorización: legibilidad por LLM (30%), consistencia semántica (25%), facilidad de implementación (20%), evidencia disponible (15%), impacto en AI SERPs (10).

- Fuentes principales consultadas (2024–2025):

- Estructura clara y enfoque por recursos priorizados en LLM: artículo de Cyberclick.

- Datos estructurados y señalización semántica: Search Central – introducción a datos estructurados, FAQPage, HowTo, Article/BlogPosting.

- Chunking/embeddings y reducción de alucinaciones: Elastic – generative AI experiences; Skimai – cómo reducir alucinaciones en LLM.

- Ventanas de contexto y límites (modelo‑dependiente): OpenAI – GPT‑4.1; Anthropic – context windows; Google AI – Gemini 1.5 Pro long context.

- Citabilidad en Perplexity y programa para editores: Perplexity – Publishers Program y documentación.

- Limitaciones: los límites de tokens y la exposición en AI Overviews pueden cambiar; valida en documentación oficial y con pruebas periódicas.

Próximos pasos sugeridos

- Elige una pieza con tráfico o potencial en tu funnel y aplícale 5 prácticas (jerarquía, chunking, HowTo/FAQ, tabla, evidencias).

- Programa una validación cruzada quincenal (ChatGPT, Perplexity y AI Overviews) y registra los cambios.

- Itera en función de qué bloques son citados y cuáles no; refuerza E‑E‑A‑T y consistencia de metadatos.

by Tony Yan

by Tony YanYou May Be Interested View All

- En HTML, usa