Recherche IA multi‑agents : le bouleversement du GEO en 2025

Découvrez comment l’IA multi‑agents transforme le GEO : données 2025, impacts, workflow SEO et conseils d’experts. Optimisez votre visibilité IA !

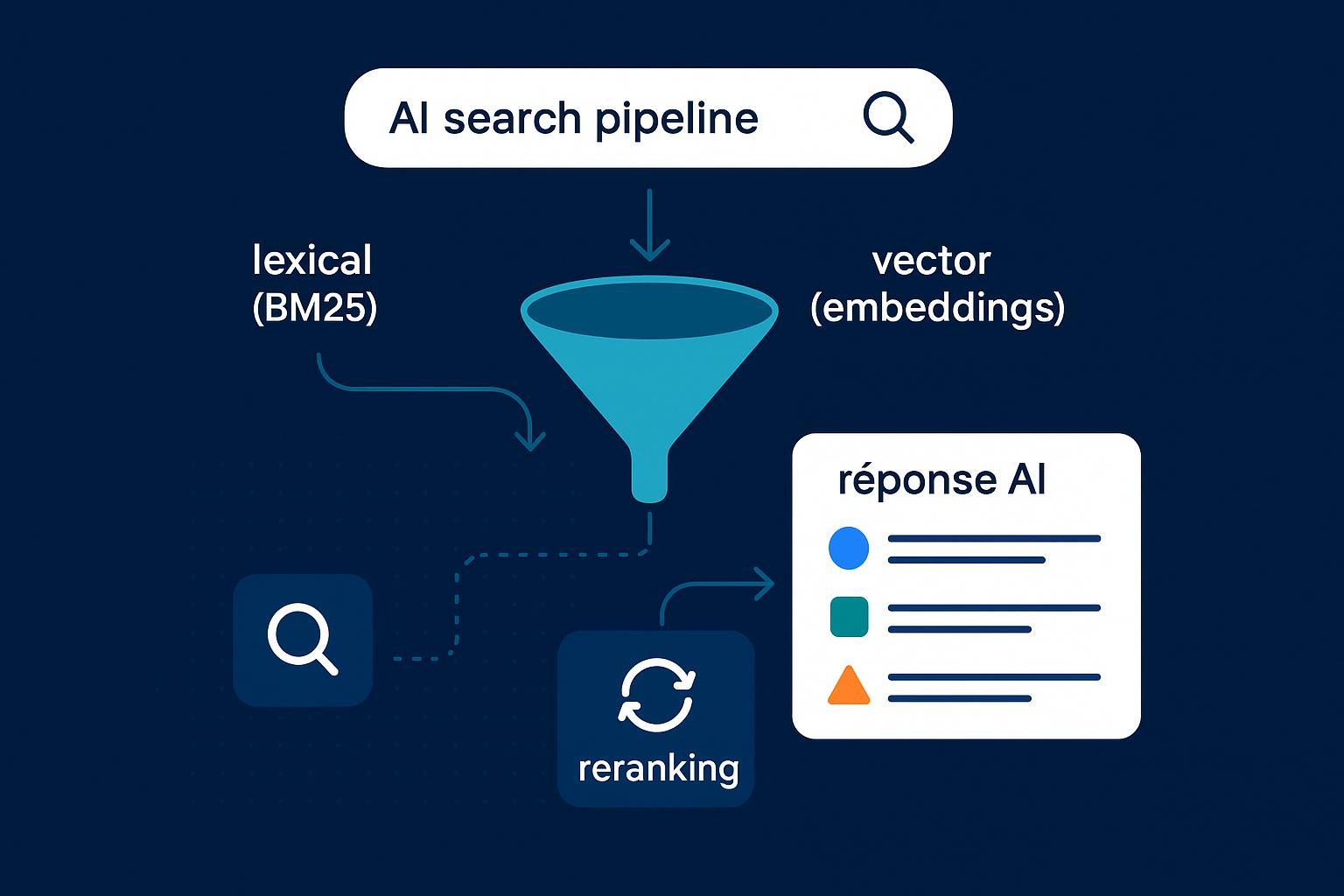

Quand la recherche n’est plus un « classement de liens » mais une réponse assemblée par des agents spécialisés, tout change pour le marketing et le SEO. Le centre de gravité se déplace du mot‑clé vers la chaîne d’évidence: trouver, vérifier, sourcer et résumer des preuves en un résultat. Pour le GEO, l’enjeu n’est plus seulement d’atteindre la première position, mais d’être cité — de manière fiable, récente et traçable — par des systèmes qui orchestrent plusieurs agents.

1) Ce que change une architecture multi‑agents côté recherche

Un système multi‑agents coordonne des rôles distincts: un planificateur découpe la question en sous‑tâches, un chercheur collecte des sources, un vérificateur contrôle la cohérence et la factualité, et un rédacteur synthétise la réponse avec références. Cette chorégraphie vise plus de fiabilité et une meilleure traçabilité qu’un modèle « monolithique » unique.

Côté entreprises, l’adoption progresse: des dirigeants décrivent des investissements rapides dans l’agentique, tout en soulignant les besoins d’observabilité (journaux, scores de confiance) et de gouvernance (marché d’agents, politiques d’usage). Voir, par exemple, les constats 2025 d’IBM sur attentes, limites et exigences d’orchestration dans « Agents IA en 2025 : attentes et réalité » et documents associés. Selon IBM (2025), l’agent orchestrateur, les capacités de function calling et l’évaluation spécifique des agents (benchmarks dédiés) deviennent des briques de base. Réf.: AI Agents in 2025: Expectations vs. Reality (IBM, 2025).

Sur le plan technique, les fournisseurs décrivent déjà des pipelines multi‑agents visibles. Anthropic a détaillé un système de recherche multi‑agents avec un « agent chef d’orchestre » coordonnant des sous‑agents en parallèle, mémoire étendue et gestion de contexte, montrant des gains par rapport à un agent seul sur leurs évaluations internes. Réf.: How we built our multi‑agent research system (Anthropic, 2025). Moralité: la recherche n’est plus un unique appel modèle, mais une suite de tâches distribuées.

2) Conséquences directes pour le GEO

Les moteurs déplacent l’attention vers des réponses synthétiques avec provenance. Google a présenté AI Mode/AI Overviews comme une couche de recherche plus « intelligente », capable d’agréger et d’expliquer des sujets en s’appuyant sur des sources variées, souvent au‑delà du top 10 classique. Réf.: Expanding AI Overviews and introducing AI Mode (Google, 2025).

Des analyses indépendantes suggèrent que les AI Overviews apparaissent sur une part non négligeable des requêtes et favorisent la citation de sources diverses, y compris des contenus communautaires quand ils apportent « expérience » et contexte. Semrush, par exemple, a publié une étude de grande ampleur sur l’occurrence et la dynamique des AI Overviews en 2025. Réf.: Semrush AI Overviews study (2025).

Conséquences pour les marques:

- La visibilité devient « citation‑centrée »: être une source citée, plutôt que seulement « bien classée ».

- Le zero‑click progresse: l’utilisateur lit la synthèse; il faut donc mesurer l’exposition par mentions et liens dans les réponses.

- Les « artefacts consommables par agents » gagnent: pages de preuve, FAQ structurées, datasets propres; bref, des contenus faciles à assembler, vérifier et citer.

3) Métriques de visibilité IA à suivre (et à expliquer en interne)

Pensez la visibilité IA comme un portefeuille de signaux. Voici un noyau de métriques actionnables pour les directions marketing/SEO et les équipes contenu/données:

- Apparitions dans AI Overviews/AI Mode (par requête stratégique): taux d’apparition, position de la mention, présence d’un lien cliquable.

- Taux de citation avec lien dans les moteurs de réponses (Perplexity, et, selon le mode, ChatGPT/Gemini quand des citations sont affichées).

- Sentiment, tonalité et exactitude des mentions (audit éditorial + outils d’analyse).

- Diversité et autorité des sources tierces qui renvoient vers vous (preuve d’évidence croisée).

- Temps‑à‑évidence: délai nécessaire à un agent (en mode « deep research ») pour retrouver et assembler une preuve solide vous concernant.

Pour poser un vocabulaire commun dans l’entreprise, vous pouvez vous appuyer sur une définition pédagogique de la « visibilité IA » et la relier aux KPIs ci‑dessus. Une ressource utile: What Is AI Visibility? Brand Exposure in AI Search Explained.

4) Workflows et gouvernance: passer du « test » à l’opérationnel

L’objectif est de rendre reproductible l’amélioration des citations et de la qualité de réponse lorsqu’un agent vous « rencontre ». Organisez une boucle hebdomadaire qui enchaîne le monitoring multi‑plateformes, la gap analysis puis le « shipping de preuves » (publication/mise à jour de pages de preuve, datasets, FAQ; consolidation de citations externes via PR technique). Programmez des campagnes de « deep research » (2–30 minutes) pour mesurer si les systèmes agentiques trouvent plus vite de meilleures preuves et vous citent plus souvent. Perplexity a, par exemple, documenté un mode qui explore des dizaines de requêtes et lit un large corpus avant de synthétiser avec sources: Introducing Perplexity Deep Research (2025). Côté gouvernance, fixez des SLAs de fraîcheur (par exemple, mises à jour critiques sous 30 jours), une politique de correction rapide en cas d’erreur dans une réponse, et une observabilité minimale (journaux d’expériences, captures, protocole d’audit).

Artefacts « agent‑consumables » prioritaires:

- Pages « source of truth »: méthodologie, chiffres audités, whitepapers; URL stables et clairement intitulées.

- Datasets/documentation RAG‑ready: JSON/CSV/Markdown propres, versionnés et citables.

- FAQ et guides orientés tâches, balisés avec données structurées. Voir la documentation officielle Google pour le balisage FAQPage (et, le cas échéant, Dataset/HowTo/Product).

5) Micro‑exemple outillé (neutre) et checklist

Déclaration: Geneo est notre produit.

Exemple pratique inspiré d’équipes marketing/SEO qui industrialisent leur suivi: l’objectif est de suivre sur huit semaines les apparitions dans AI Overviews/AI Mode sur vos 25 requêtes clés, les citations avec lien dans Perplexity et la tonalité des mentions. Côté mise en place, un journal d’expériences (tableur ou base légère) couplé à un outil de monitoring multi‑plateformes suffit. Une plateforme comme Geneo peut aider à consolider les apparitions, les mentions avec lien et la polarité des réponses, et à conserver l’historique pour analyse comparative. Chaque semaine, confrontez les écarts (requêtes sans mention; mentions sans lien; erreurs factuelles) et « shippez » de la preuve (ajout d’une page source de vérité, publication d’un dataset, clarification d’une FAQ). Pour un panorama comparatif des moteurs de réponses et de leurs comportements de citation, voir ce retour d’expérience: ChatGPT vs Perplexity vs Gemini vs Bing — comparatif monitoring IA (FR). Et si vous structurez vos chantiers GEO autour d’AI Overviews, ce guide outillage peut être utile: 10 Best Google AI Overview (AIO) Tracking Tools for China (2025).

Checklist courte pour vos équipes (copiable dans votre playbook):

- Cartographier 30–50 requêtes « tasks-to-be-done » par persona et intention.

- Créer ou renforcer 10–15 pages de preuve (méthodo, chiffres audités, cas, comparatifs) et 5–10 datasets citables.

- Balisage schema prioritaire (FAQPage, HowTo, Dataset) et liens de provenance clairs.

- Programmer des deep research mensuels et journaliser le temps‑à‑évidence.

- Établir des SLAs de mise à jour et un protocole de correction publique.

6) Points de vigilance 2025 et prochaines étapes

- Faits mouvants: les fonctionnalités d’AI Mode/AI Overviews et les politiques de citation évoluent rapidement. Évitez les conclusions définitives; conservez un journal d’hypothèses et de validations.

- Biais de plateforme: croisez plusieurs moteurs (Google, Perplexity, ChatGPT/Gemini) et répétez les tests dans le temps. Les comportements diffèrent selon le type de requête (informative, transactionnelle, tutorielle).

- Gouvernance/E‑E‑A‑T: attachez des preuves première main à vos affirmations (méthodologies ouvertes, jeux de données audités) et tenez une politique de corrections visible.

Prochaine étape simple: démarrez un « sprint de preuve » de 14 jours. Sélectionnez 15 requêtes, définissez 5 artefacts de preuve à produire, lancez 3 cycles de deep research programmés et mesurez l’évolution des citations et du temps‑à‑évidence. Ensuite, standardisez ce qui fonctionne et itérez.

—

Remerciements et ressources citées (sélection): IBM sur l’agentique d’entreprise (2025), Anthropic sur l’architecture multi‑agents (2025), Google sur AI Mode/AI Overviews (2025), Semrush sur l’occurrence des AI Overviews (2025), documentation Google sur FAQPage (2024–2025), Perplexity sur Deep Research (2025).