Pourquoi les exemples de marques comptent plus que les mots-clés (Best Practice 2025)

Découvrez pourquoi les exemples de marques surpassent l’optimisation mots-clés en SEO 2025 : E-E-A-T, IA, KPI, workflow GEO/LLMO, monitoring multi-plateformes.

Quand un AI Overview aspire la réponse tout en haut de la SERP, un simple mot-clé générique ne suffit plus. La visibilité se gagne désormais avec des preuves concrètes rattachées à une marque — études de cas, citations vérifiables, pages auteur, schémas — qui nourrissent la confiance et l’éligibilité à la citation par les modèles. Google a d’ailleurs durci ses politiques (abus de réputation, qualité, finalité) et met l’accent sur l’expérience vécue et la preuve dans ses référentiels qualité. Voir, côté politique, la mise à jour « site reputation abuse » détaillée par Google en 2024 et ses implications anti‑spam dans la recherche dans le billet officiel de Google Search Central, « Site reputation abuse » (19/11/2024) : Google précise que l’exploitation opportuniste de la réputation d’un site est contraire à ses règles. Côté évaluation qualité, les Raters Guidelines (PDF public, 2024) placent l’E‑E‑A‑T et la preuve au centre de l’analyse de la page et du site : consultez le document source, Search Quality Evaluator Guidelines (Google, 2024, PDF).

Au même moment, plusieurs analyses 2025 montrent que la présence d’un AI Overview peut rogner fortement le CTR organique des meilleurs résultats. HubSpot France a compilé ces tendances et retours d’études en 2025, soulignant des baisses substantielles de clics sur les requêtes concernées, dans son article « AI Overview Google » (HubSpot FR, 2025). Pour être choisis et cités par ces réponses IA, les contenus doivent « ressembler à des preuves », pas à des slogans.

1) Pourquoi les exemples de marques surpassent les mots-clés génériques

- Confiance et crédibilité. Les exemples de marques matérialisent l’E‑E‑A‑T : on cite une entreprise, un client, un auteur identifié, des chiffres datés et sourcés. C’est concret et vérifiable. Les contenus génériques, eux, restent interchangeables — donc moins citables.

- Éligibilité IA et citations. Les AI Overviews citent majoritairement des sources déjà positionnées et perçues comme fiables. Une synthèse 2025 indique que 76 % des sources retenues proviennent du top 10 organique classique, ce qui renforce l’importance d’un contenu de marque structuré et digne d’être référencé : voir l’analyse d’Ahrefs relayée par eCommerce Nation, « 76 % des sources citées viennent du top 10 Google » (2025).

- Intention et conversion. Les requêtes de marque captent souvent une intention plus chaude (navigational/transactionnelle). Sur ces parcours, une page preuve (cas client, témoignage, comparatif) convertit mieux qu’un billet générique. Vous voulez des ventes ou des visites ? La réponse change souvent quand la preuve est sous les yeux.

Pensez‑y ainsi : quand vous lisez un cas réel complet, avec un auteur identifiable et des chiffres récents, avez‑vous plus envie d’avancer que face à une liste de conseils génériques ?

2) Workflow GEO/LLMO en 7 étapes (actionnable)

- Audit d’autorité et d’extractibilité IA

- Dresser la cartographie de vos preuves: cas, témoignages, pages auteur, sources externes qui parlent de vous. Vérifier titles/H1, maillage, Core Web Vitals, balisage (FAQ, Article, Organization…). Examiner votre présence (ou absence) dans les AI Overviews et les citations LLM.

- Sélection d’exemples de marques prioritaires

- Choisir 3–5 cas forts, sectorisés et racontables (problème → solution → résultat). Rassembler les KPI, citations clients, captures, horodatage des résultats.

- Production de contenus structurés « citables »

- Rédiger des études de cas complètes, des FAQ ciblées, des sections « comment ça marche », des pages auteur crédibles. Relier chaque claim à une source ou une donnée datée. Répondre clairement aux questions de l’utilisateur en haut de page.

- Schéma/entités et clarté sémantique

- Déployer JSON‑LD (FAQPage, Article, Product, Organization, Review/Rating), soigner l’orthographe des entités (marques, personnes, produits), ajouter un glossaire interne. Objectif : faciliter l’extraction, la citation, et la compréhension machine.

- Diffusion et co‑occurrences

- Décliner vos preuves en formats multi‑plateformes (article, carrousel, vidéo courte, Q/R). Chercher des publications sur des sites d’autorité (partenaires, médias spécialisés) pour générer des co‑occurrences et mentions tierces crédibles.

- Monitoring SEO+IA multi‑plateformes

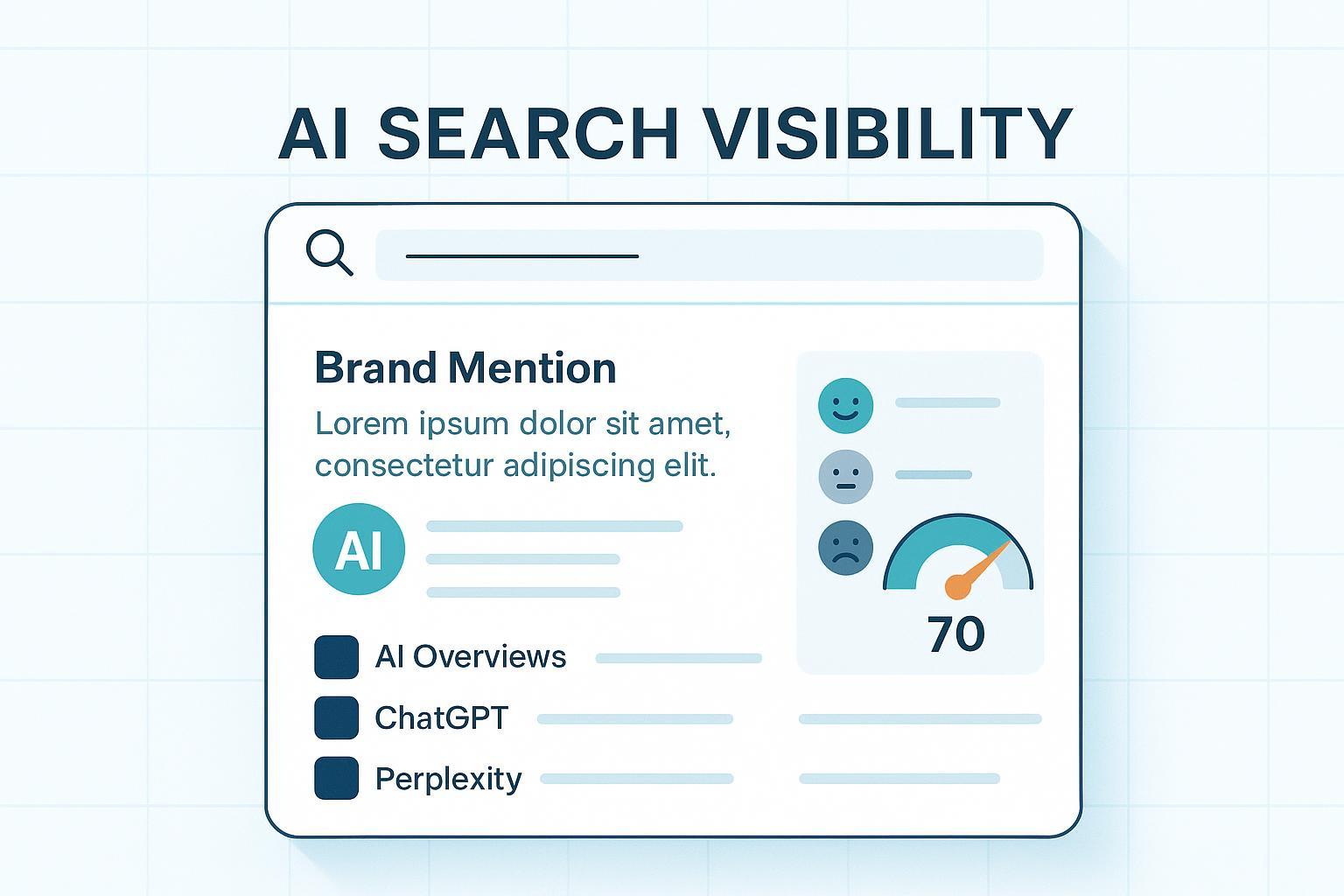

- Suivre: présence dans AI Overviews, citations/mentions par les LLM, taux d’obtention de snippets/FAQ, positions, CTR, sentiment des réponses IA, conversions sur pages preuves.

- Itération trimestrielle

- Mettre à jour chiffres, ajouter de nouveaux cas, enrichir les pages auteur, densifier le maillage interne, élargir la couverture thématique et tester de nouveaux formats orientés « preuve ».

3) Mini‑cas public et tableau comparatif

- Cas public côté structuration et pertinence: l’équipe Packref documente l’effet d’une rationalisation des contenus et d’un recentrage sur des pages « pertinentes » (FAQ, preuves, maillage), avec des gains organiques rapides observés après mise en ordre. Voir l’analyse méthodologique détaillée dans « Pages pertinentes vs pages mortes » (Packref, 2025).

| Type de contenu | Signaux fournis | Probabilité d’être cité par IA | Effet attendu sur conversion |

|---|---|---|---|

| Article générique « mots-clés » | Conseils abstraits, peu sourcés, auteur peu visible | Faible (contenu substituable) | Faible à moyenne |

| Exemple de marque (cas client) | Preuves datées, citations, KPI, auteur identifié, schéma | Élevée si structuré et référencé | Moyenne à élevée |

| Page auteur + témoignage | Identité claire, réputation externe, avis vérifiables | Moyenne (renforce E‑E‑A‑T) | Élevée sur requêtes de marque |

4) Mesure & KPI 2025 (SEO + IA)

- Visibilité IA

- Part des requêtes de votre secteur qui déclenchent un AI Overview et taux de citations où votre marque apparaît

- Nombre de citations LLM et proportion de pages sources en top 10 organique

- SEO

- CTR avec/sans AI Overview, featured snippets/FAQ captés, positions, trafic net sur pages preuves

- Business & confiance

- Taux de conversion des études de cas vs articles génériques, CPA brand vs générique, LTV des leads issus de requêtes de marque, sentiment net des réponses IA

- Méthodo de collecte

- Coupler Google Search Console (requêtes/CTR), Google Ads (brand exact vs generic), Analytics/CRM (leads, revenus, LTV) et suivi des citations/AI Overviews. Vous obtenez un tableau de bord qui reflète la réalité « SEO + IA » plutôt qu’un simple positionnement.

Pour cadrer la qualité et la conformité, suivez les références officielles: Google a renforcé ses règles et la pédagogie E‑E‑A‑T. En 2025, Search Engine Land a également signalé que Google illustrait mieux dans ses documents la manière dont les AI Overviews s’insèrent dans l’évaluation, ce qui rappelle l’importance des preuves et de l’expérience: « Google updates Search Quality Raters Guidelines, adding AI Overview examples » (Search Engine Land, 2025).

5) Exemple d’usage: intégrer Geneo dans votre monitoring GEO/LLMO

Disclosure: Geneo est l’éditeur de l’outil mentionné ci‑dessous. Cette section illustre un scénario d’usage possible, sans promesse de résultat.

Concrètement, comment ancrer vos preuves de marque dans un pilotage continu « SEO + IA »?

- Définir le corpus « preuves »: vos 5–10 cas clients phares, pages auteur, FAQ, comparatifs produits et billets méthodo. Chaque page doit comporter chiffres datés, citations, images/captures et un schéma JSON‑LD valide.

- Surveiller la présence de marque dans les moteurs IA: suivez vos mentions et liens cités dans ChatGPT, Perplexity, Google AI Overviews, Bing Copilot et autres interfaces. L’objectif: comprendre si vos pages « preuves » sont reprises telles quelles, si la tonalité est positive et quelles sources tierces sont co‑citées.

- Analyser le sentiment et les angles: repérer les réponses IA où la marque est présentée positivement vs prudemment; identifier les questions récurrentes auxquelles il faut répondre avec une preuve nouvelle (FAQ, cas, guide).

- Boucler avec vos KPI business: mappez les requêtes de marque, le trafic organique post‑AI Overview, et les conversions sur vos études de cas. L’idée: prioriser les prochains contenus « preuve » qui bougent réellement l’aiguille.

- Itérer les prompts/tests: formulez des questions typiques de vos prospects (« qui est le meilleur pour… », « étude de cas X dans tel secteur »). Vérifiez si vos contenus émergent naturellement; si ce n’est pas le cas, renforcez la structure, les citations et l’alignement entités.

Ce pilotage vous évite de produire au hasard. Il révèle quelles preuves sont citables, ce que les IA racontent déjà sur vous, et où creuser.

6) Risques, limites et contre‑exemples

- Sur‑promettre sans preuve. Les contenus « auto‑louange » non étayés sont vite déclassés, et rarement cités par les AI Overviews.

- Cas mal choisis. Un exemple de marque trop ancien, anonyme ou sans chiffres concrets convainc peu et n’aide pas l’éligibilité IA.

- Oublier la sémantique machine. Sans schéma, entités claires et réponses directes, même une bonne étude de cas reste difficile à réutiliser par les systèmes génératifs.

- Dépendre d’un seul canal. Les co‑occurrences (médias, partenaires, conférences) renforcent la crédibilité. À l’inverse, un silo de blog isolé paraît faible.

En bref: mieux vaut trois cas solides, frais et structurés qu’un calendrier éditorial de 40 billets génériques.

Pour aller plus loin

- Comprendre les acronymes et méthodes pour optimiser votre visibilité dans les réponses des moteurs IA: GEO, GSVO, AIO, LLMO — définitions et usages (Geneo, FR)