Comment évaluer l’exactitude factuelle des modèles d’IA

Guide expert sur l’évaluation factuelle IA : définitions, benchmarks LLM, audit de citations, impacts SEO et AI Overviews.

Que vaut une réponse d’IA si vous ne pouvez pas vérifier d’où viennent ses faits ? L’évaluation de l’exactitude factuelle n’est plus un sujet de niche: elle conditionne la confiance des utilisateurs, la conformité dans les domaines sensibles, et même la visibilité de votre marque dans les AI Overviews. Voici une explication pratico-pratique de ce que mesurent les méthodes modernes, comment les appliquer à vos systèmes LLM/RAG, et ce qu’il faut surveiller pour les citations et l’attribution.

Factualité, fidélité et “hallucinations”: remettre les mots au bon endroit

On confond souvent deux choses. La factualité (exactitude des énoncés) exige que les affirmations soient correctes et vérifiables. La fidélité (faithfulness ou grounding) demande que la sortie reste conforme aux sources ou au contexte fourni. Un modèle peut être “bien écrit” mais infidèle au document, ou fidèle au contexte et pourtant factuellement faux si la source est elle-même erronée. Les “hallucinations” se manifestent de plusieurs façons: intrinsèques (erreurs internes au modèle, raisonnements contradictoires) ou extrinsèques (faits inventés non appuyés par les données), et par omission (il manque des éléments essentiels) ou commission (le modèle ajoute des détails non fondés). Pensez à la fidélité comme à des notes de bas de page solides: chaque déclaration doit “coller” à une page précise du corpus. Sans cet ancrage, les citations deviennent décoratives et les risques d’attribution erronée montent en flèche.

Les benchmarks qui comptent (et pourquoi)

Dans l’écosystème 2024–2025, quelques ressources font autorité pour mesurer vérité et fidélité. TruthfulQA (Lin et al., 2021) est conçu pour tester la propension d’un modèle à éviter les fausses croyances populaires, via des questions adversariales; voir l’article arXiv dans TruthfulQA sur arXiv (2021). FEVER est un dataset de vérification de faits basé sur Wikipédia, avec un score combinant classification et preuves exactes; le site officiel détaille la tâche et les métriques: FEVER — Fact Extraction and VERification. QAGS et les approches LLM‑as‑a‑judge (ex.: G‑Eval) aident à juger la fidélité des résumés et des générations longues par rapport à une source, en “posant des questions” au texte; ces approches sont puissantes, mais sensibles aux biais du juge et nécessitent calibration.

| Approche | Quand l’utiliser |

|---|---|

| TruthfulQA | Tester la robustesse face aux croyances erronées et aux questions adversariales |

| FEVER | Vérifier des affirmations avec preuves explicites (support/refute/NEI) |

| QAGS / LLM-as-a-judge | Évaluer la fidélité d’un résumé/génération à un document source |

| RAGAS | Mesurer groundedness et exactitude dans des pipelines RAG |

| TruLens | Tracer et évaluer la pertinence du contexte et des réponses dans RAG |

Évaluer des systèmes RAG: retrieval, grounding, cohérence

Les architectures RAG (Retrieval‑Augmented Generation) combinent recherche de passages et génération. Pour les auditer, on mesure la qualité du retrieval (pertinence, rappel, MRR, nDCG), le groundedness (la réponse s’appuie‑t‑elle réellement sur le contexte récupéré ?) et la cohérence réponse‑contexte (pas de distorsion ni extrapolation non supportée). Deux outils de référence aident à opérationnaliser ces contrôles: RAGAS — Documentation officielle, cadre open‑source pour la fidélité et l’exactitude dans RAG; et TruLens — Site officiel, bibliothèque dédiée au traçage et à l’évaluation des apps LLM/RAG (RAG Triad: context relevance, groundedness, answer relevance). Pour une vue d’ensemble en français, Microsoft propose un guide d’évaluation RAG structuré (métriques, étapes, bonnes pratiques) dans Guide d’évaluation RAG sur Microsoft Learn (FR).

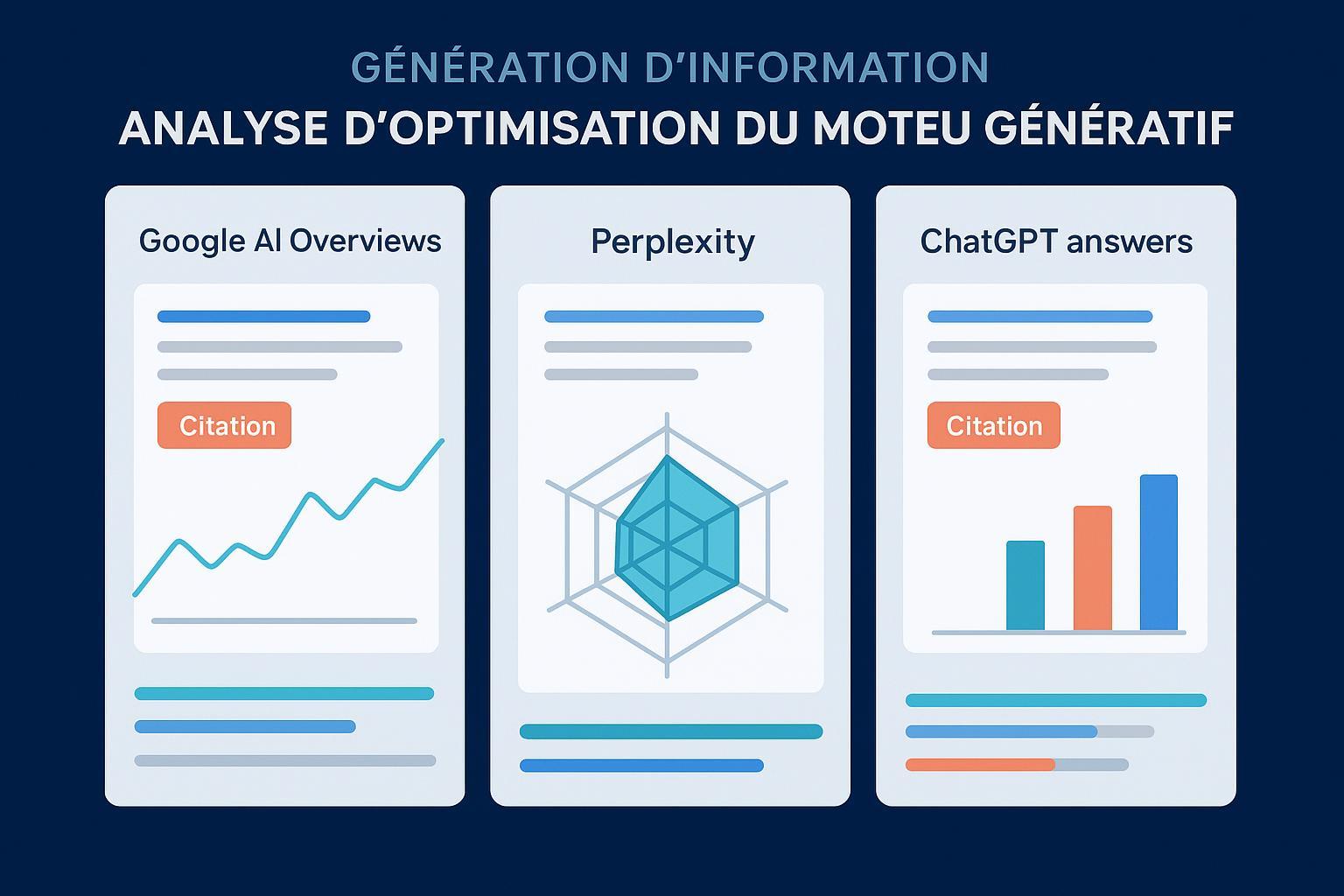

Citations et attributions: AI Overviews et moteurs “citation-first”

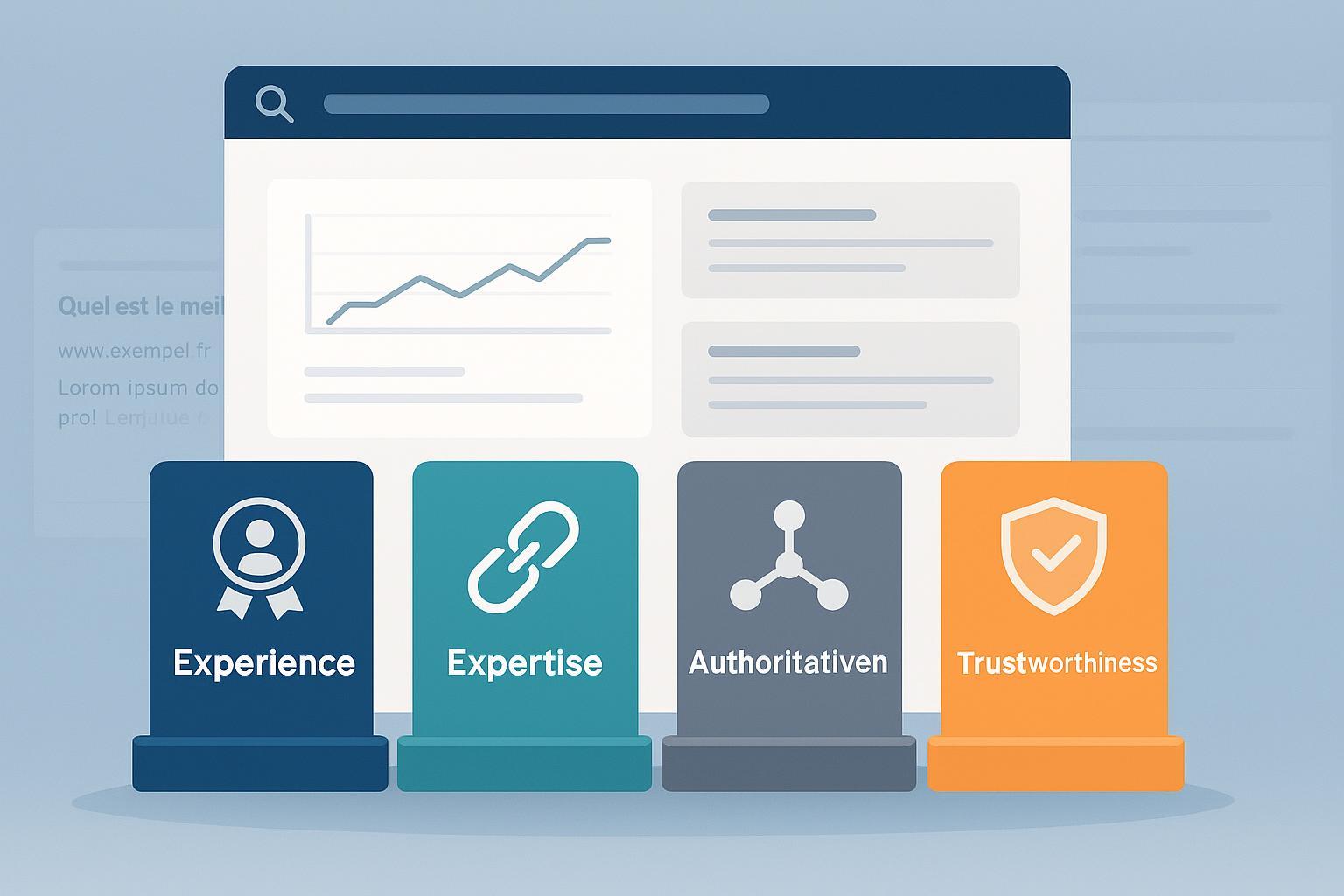

Dans les AI Overviews, la sélection des sources et la présentation des liens ont un impact direct sur votre visibilité de marque. Google publie des conseils aux éditeurs pour que les contenus soient éligibles, accessibles et utiles aux fonctionnalités d’IA de la recherche; consultez AI features and your website — Google Search Central pour les recommandations officielles. Perplexity adopte un design “citation‑first”: réponses accompagnées de sources numérotées, avec comportements spécifiques quand la plateforme ne trouve pas de références fiables. La page d’aide décrit cette transparence des citations: How does Perplexity work — Help Center. Côté audit, au‑delà de la présence d’un lien, vérifiez la qualité E‑E‑A‑T des sources, la cohérence réponse‑contexte et la traçabilité (URLs stables, pages accessibles, balisage clair). Une attribution erronée peut nuire à la réputation, surtout si la réponse est largement diffusée.

Un workflow d’évaluation pragmatique

Établissez un circuit simple, reproductible et mesurable. Voici une trame qui fonctionne bien pour des cas non‑YMYL et la plupart des assistants métier:

- Cadrer les risques: définir les domaines sensibles, les seuils d’abstention et les exigences de provenance.

- Constituer les jeux de test: questions adversariales (TruthfulQA), claims avec preuves (FEVER), corpus métier.

- Mesurer: fidélité (QAGS/LLM‑as‑a‑judge), vérité (TruthfulQA), groundedness RAG (RAGAS/TruLens), retrieval (précision/rappel/MRR/nDCG), et calibration (scores de confiance).

- Mitiger: meilleure récupération (chunking, embeddings, re‑ranking), filtres de confiance, abstention contrôlée, validation externe.

- Surveiller en production: tracing, feedbacks utilisateurs, revues périodiques, régressions maîtrisées.

Deux questions utiles pour rester lucide: votre modèle sait‑il s’abstenir quand il n’est pas sûr ? Qui contrôle la qualité des URLs citées—et selon quels critères ?

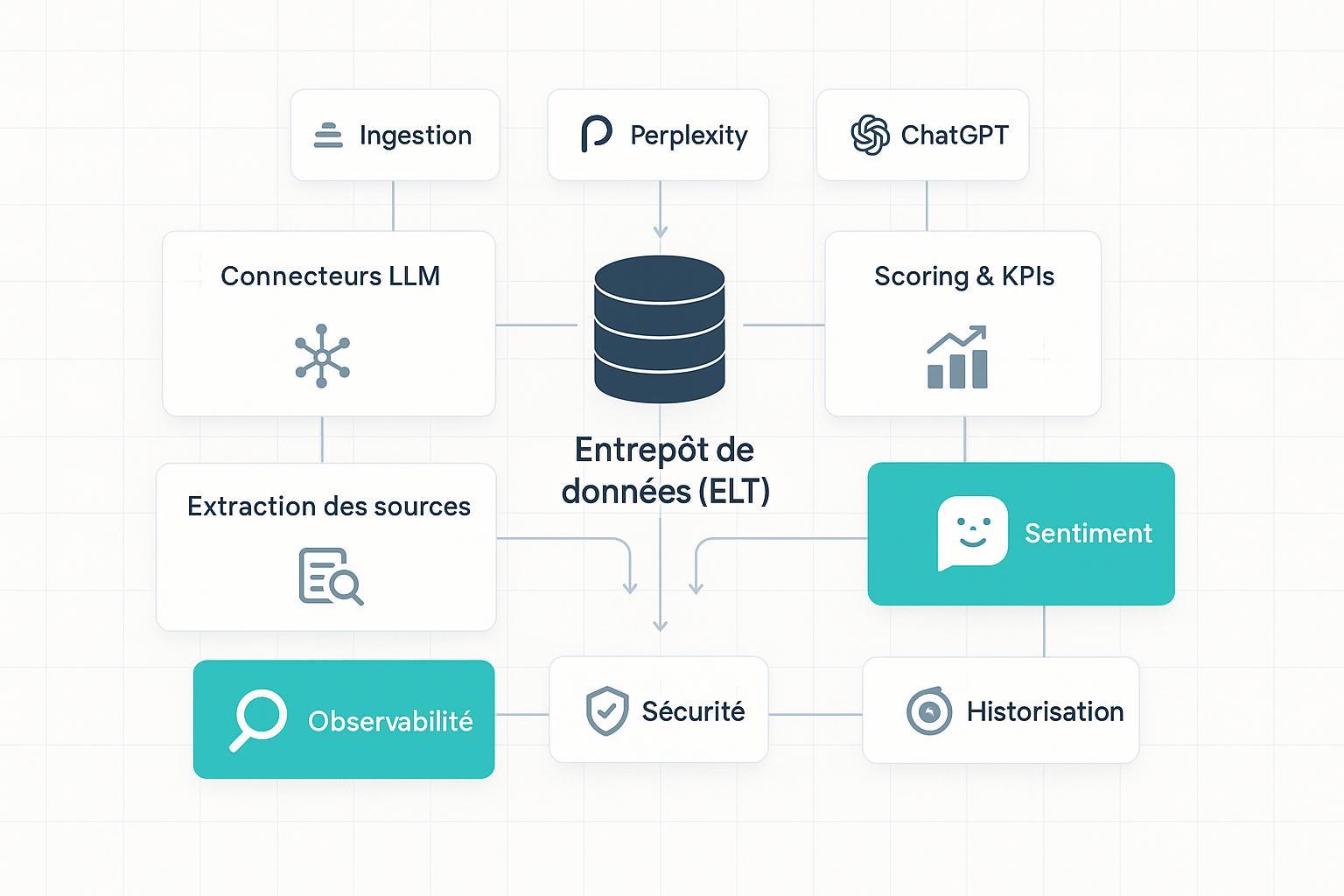

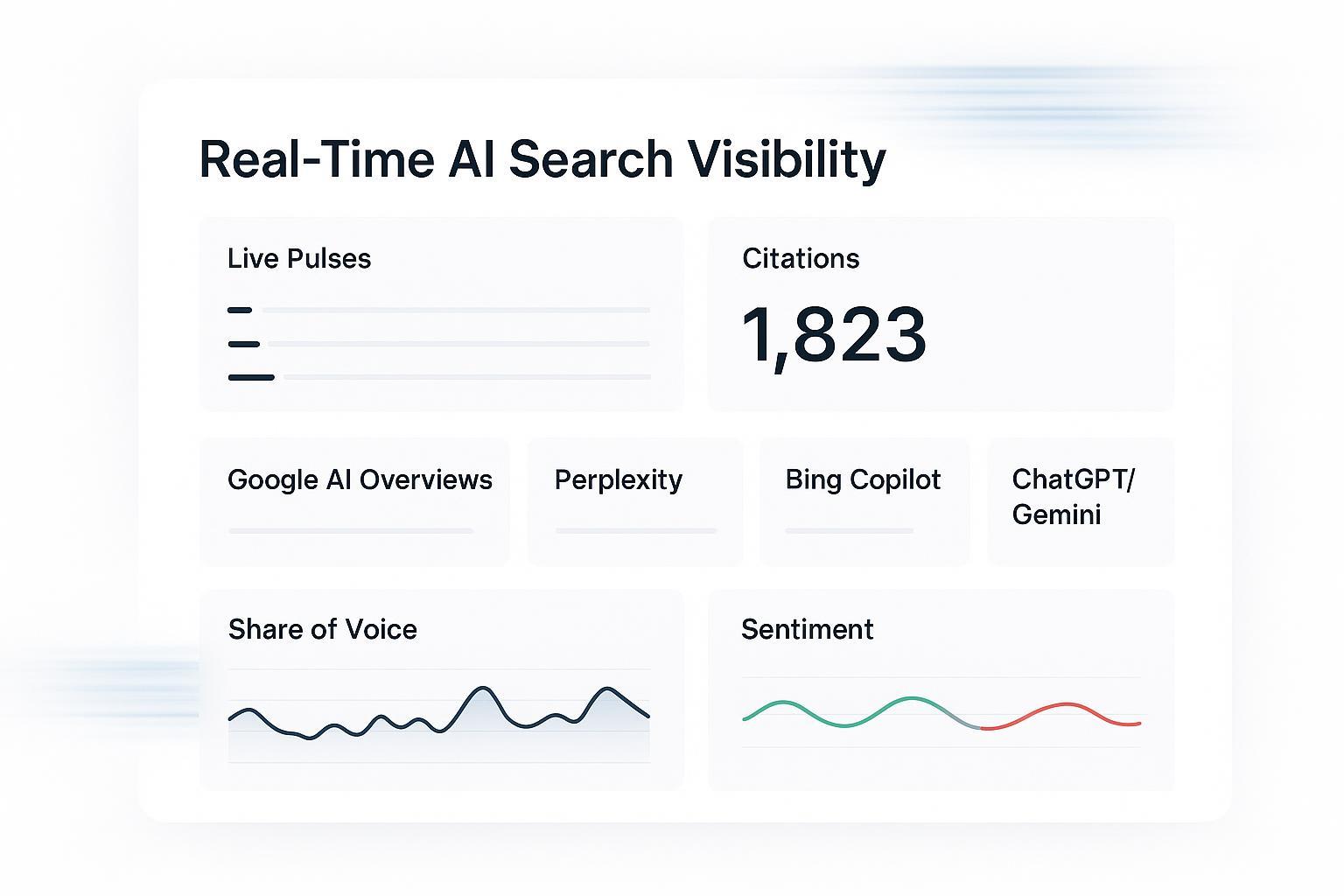

Exemple/Workflow: monitorer citations et sentiment multi‑plateformes

Disclosure: Geneo est notre produit.

Dans les environnements où vos contenus peuvent être cités par ChatGPT, Perplexity ou AI Overviews, il est utile d’observer en continu quelles pages sont référencées et avec quel ton. Un tableau de bord qui agrège les mentions, les liens et l’analyse de sentiment par requête vous aide à repérer les attributions manquantes ou inexactes et à prioriser des correctifs (améliorer la qualité des pages, le balisage, la performance et l’indexation). Geneo peut être utilisé pour centraliser ce monitoring multi‑plateformes et suivre l’historique des requêtes, afin de comparer l’évolution des citations et du sentiment sur la durée. En savoir plus: Geneo.

Pièges fréquents, limites et bonnes pratiques

Les métriques ne remplacent pas le jugement humain—elles le structurent. LLM‑as‑a‑judge est utile pour scaler l’évaluation, mais reste sujet aux biais; il faut calibrer et auditer périodiquement. Face à l’incertitude, mieux vaut s’abstenir que livrer un fait non sourcé; intégrez des seuils de confiance et des politiques d’abstention. Enfin, l’attribution: un lien n’est pas une preuve. Contrôlez la correspondance fine entre passage cité et assertion, et documentez cette traçabilité.

Ce qui compte pour la visibilité de marque

La factualité n’est pas seulement un enjeu technique. Des réponses d’IA correctement “ancrées” reprennent vos contenus plutôt que des sources tierces, et des citations exactes évitent les glissements de sens. Côté SEO, vous maximisez vos chances d’être repris dans des Overviews si vos pages sont de haute qualité, facilement crawlables, bien balisées et utiles au sujet. Côté produit, un suivi des mentions et du sentiment met en lumière les décrochages et ouvre la voie à des améliorations continues. En clair, évaluer, corriger et surveiller: c’est le trio gagnant.

Conclusion

Pour évaluer la factualité, combinez des benchmarks éprouvés (TruthfulQA, FEVER), des juges de fidélité (QAGS/LLM‑as‑a‑judge), et des cadres dédiés aux pipelines RAG (RAGAS, TruLens), en vous appuyant sur des guides opérationnels comme Microsoft Learn. Auditez systématiquement les citations et l’attribution selon les recommandations des plateformes (Google, Perplexity). Ensuite, instituez une boucle d’amélioration continue: métriques bien choisies, politiques d’abstention, validation externe, et supervision en production. C’est ainsi que vous obtenez des réponses fiables, utiles et bonnes pour votre marque.