AI Search Visibility Score : définition et méthode de calcul

Découvrez comment le AI Search Visibility Score mesure la visibilité d’une marque dans les réponses IA avec une méthode reproductible et des métriques clés.

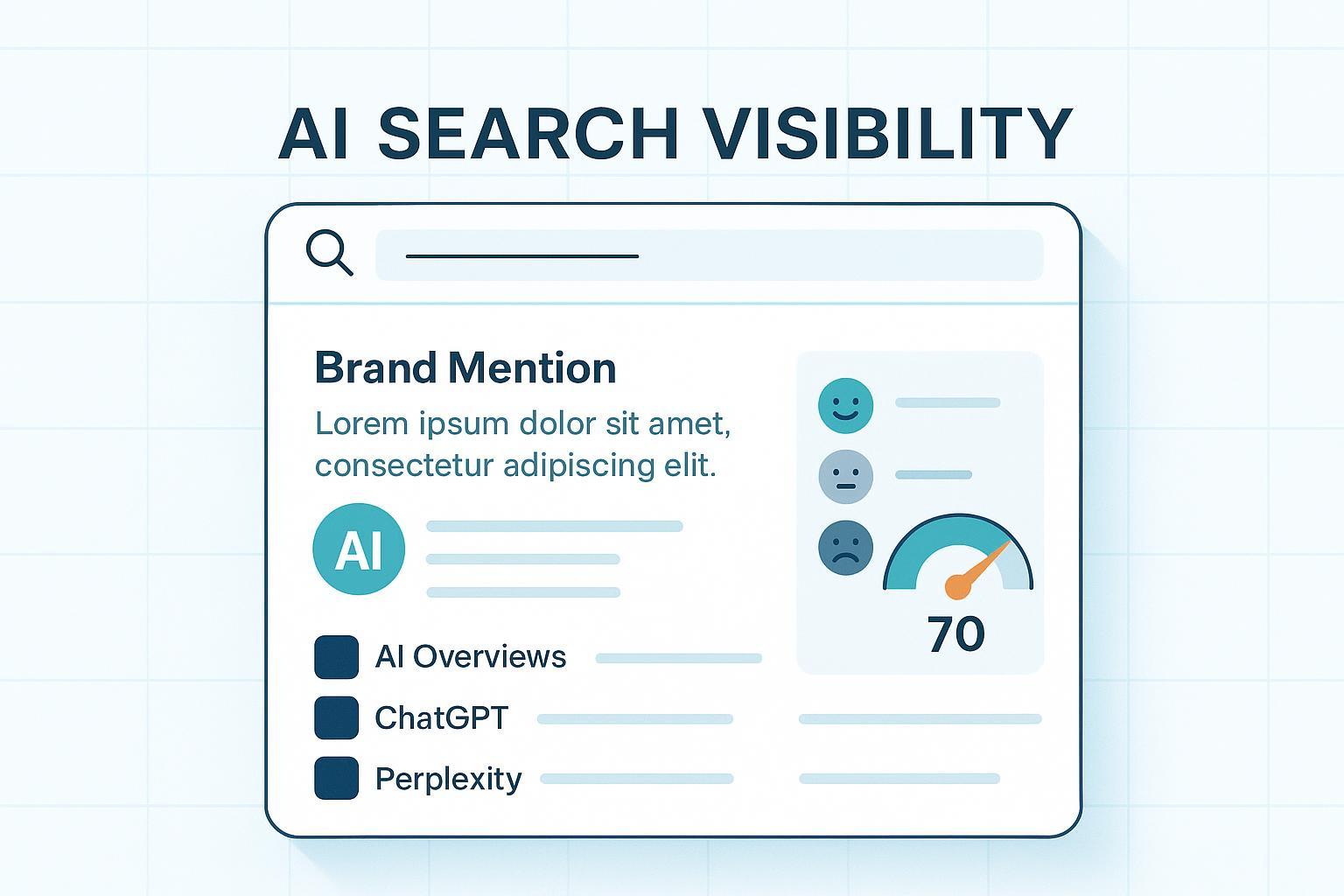

Mesurez-vous vraiment la place de votre marque dans les réponses génératives (AI Overviews, Perplexity, ChatGPT, Gemini) — ou bien vous fiez-vous à des impressions ponctuelles? Le « AI Search Visibility Score » n’est pas une norme officielle, mais il peut devenir votre boussole: un indice 0–100 qui synthétise quand, où et comment vous apparaissez dans les réponses d’IA, et avec quelle qualité perçue.

L’objectif de ce guide: poser une définition opératoire, expliciter une formule reproductible, lister les données à collecter par moteur et montrer comment auditer les résultats. Au passage, on soulignera les limites et les arbitrages à connaître.

Définition opératoire du score

Pensez-y comme à un indice boursier de votre marque dans les réponses IA. Sur un corpus de requêtes défini (50 à 200, par exemple), on observe pour chaque requête si la marque est mentionnée, si un lien vers votre domaine est cité, à quelle « hauteur » vous apparaissez dans la réponse, quelle part de voix vous détenez face aux concurrents, le sentiment associé, et sur combien de moteurs/variantes vous êtes visible. On agrège ensuite ces sous-métriques en un score unique.

Formule pédagogique (exemple de pondérations) :

Score global = 100 × moyenne( Score_requête )

Score_requête = 0,30×Présence + 0,20×Citations_liées + 0,15×Position + 0,15×Part_de_voix + 0,10×Sentiment + 0,10×Couverture_moteurs

Chaque sous-métrique est ramenée sur 0–1 avant agrégation. Voici un récapitulatif synthétique :

| Sous-métrique | Définition observée | Échelle | Pondération (ex.) |

|---|---|---|---|

| Présence | La marque est mentionnée dans la réponse IA | 0/1 | 0,30 |

| Citations liées | Un lien cliquable pointe vers votre domaine | 0/1 | 0,20 |

| Position | Importance/placement dans la réponse (haut=1, milieu=0,6, bas=0,3) | 0–1 | 0,15 |

| Part de voix (générative) | Part de vos mentions/liens vs. l’ensemble des marques citées | 0–1 | 0,15 |

| Sentiment | Tonalité du passage contenant la marque (pos=1, neutre=0,5, nég=0) | 0–1 | 0,10 |

| Couverture moteurs | Proportion de moteurs/variantes où vous apparaissez pour la requête | 0–1 | 0,10 |

Notez qu’aucune pondération « magique » n’existe. L’important est la transparence: déclarez vos choix, testez leur sensibilité et documentez votre protocole.

Données à collecter par moteur

- Google AI Overviews / Mode IA. Ce que vous pouvez observer: le déclenchement de l’aperçu IA pour une requête, la présence d’un lien vers votre domaine et l’ordre d’apparition relatif. Les recommandations 2025 de Google insistent sur le contenu utile, l’adéquation aux politiques anti‑spam et l’expérience de page. Voir les conseils de Google Search Central dans « Top ways to ensure your content performs well in AI search » (2025) pour cadrer vos efforts de contenu et d’éligibilité (Google Search Central 2025 — réussir dans l’AI search).

- Perplexity. La plateforme affiche des réponses avec des citations cliquables vers les sources, ce qui permet de distinguer clairement « mention » et « citation liée ». Utile pour le suivi fin des attributions (Centre d’aide Perplexity — fonctionnement et citations).

- ChatGPT / Gemini. Mesurez uniquement dans les modes où l’attribution est active et vérifiable (recherche web, connecteurs). L’annonce « ChatGPT Search » détaille les capacités de réponse avec liens vers des sources (OpenAI — Introducing ChatGPT Search).

Pour choisir où concentrer l’effort et comment échantillonner, comparez les moteurs et interfaces: ce comparatif pragmatique peut vous aider (Comparatif ChatGPT vs Perplexity vs Gemini vs Bing — monitoring IA).

Procédure de calcul pas à pas (atelier 28 jours)

- Définir le corpus. Sélectionnez 50–200 requêtes couvrant informations, commercial, marque et non‑marque. Ajoutez des prompts réellement observés.

- Échantillonner par moteur. Fixez des créneaux (heures/jours) et des réglages constants (langue, région, device). Conservez timestamps et version de l’interface.

- Extraire les variables. Pour chaque requête et moteur: Présence (0/1), Citation liée (0/1), Position (règles simples haut/milieu/bas), Part de voix (proportion), Sentiment (classificateur auditable), Couverture moteurs.

- Calculer les sous‑scores. Ramenez tout sur 0–1 puis appliquez les pondérations.

- Normaliser. Si besoin, appliquez min–max ou z‑score par cluster thématique pour limiter les effets extrêmes.

- Agréger. Calculez Score_requête puis la moyenne sur le corpus. Déclinez par moteur et par cluster.

- Rapporter et relier au business. Suivez la tendance (4–12 semaines) et la corrélation avec trafic/conversions (UTM, GA4, tagging serveur).

Exemple chiffré minimal (3 requêtes, valeurs déjà normalisées sur 0–1) :

weights = {

'presence': 0.30,

'linked_citations': 0.20,

'position': 0.15,

'sov': 0.15,

'sentiment': 0.10,

'engine_coverage': 0.10

}

queries = [

# q1: forte visibilité multi-moteurs

{'presence':1, 'linked_citations':1, 'position':1.0, 'sov':0.7, 'sentiment':0.8, 'engine_coverage':1.0},

# q2: mention sans lien, milieu de réponse

{'presence':1, 'linked_citations':0, 'position':0.6, 'sov':0.4, 'sentiment':0.5, 'engine_coverage':0.5},

# q3: pas de présence

{'presence':0, 'linked_citations':0, 'position':0.0, 'sov':0.0, 'sentiment':0.0, 'engine_coverage':0.0},

]

scores = []

for q in queries:

s = sum(q[k]*w for k, w in weights.items())

scores.append(s)

score_global = 100 * (sum(scores)/len(scores))

print(round(score_global, 1)) # ≈ 46,7 sur 100 dans cet exemple

Ce mini‑calcul illustre deux points essentiels: la valeur d’un lien cliquable (citations liées) et l’importance de la couverture multi‑moteurs.

Normalisation, comparabilité et audit

Pour rendre vos résultats comparables dans le temps et entre marques de tailles différentes, appuyez‑vous sur les bonnes pratiques des indicateurs composites (cadre conceptuel, normalisation, pondération transparente, analyses de sensibilité). Le référentiel de la Commission européenne fournit un cadre éprouvé (Handbook OCDE/JRC pour les indicateurs composites).

Bonnes pratiques d’audit:

- Conserver les captures, URLs et horodatages; séparer « mention » de « citation liée ».

- Journaliser langue, région, device et tout paramètre de personnalisation.

- Documenter le modèle de sentiment utilisé (précision, biais connus) et réaliser un contrôle humain par échantillonnage (10–20 %).

- Tester la sensibilité du score à ±10–20 % sur les pondérations et à la composition du corpus.

Limites, pièges et arbitrages

- Un score non standardisé. Par nature, cet indice est « privé ». C’est acceptable si vous publiez sa définition, vos pondérations et votre protocole de collecte.

- AIO et le paradoxe des clics. Des analyses indépendantes ont mesuré une baisse moyenne des clics quand un AI Overview s’affiche. Ahrefs (avril 2025) observe −34,5 % en moyenne sur les pages en position 1 (Ahrefs — AI Overviews reduce clicks). En parallèle, Google indique que ces visites peuvent être mieux satisfaites/plus engagées selon les cas (voir les recommandations 2025 citées plus haut). Faut‑il viser la quantité ou la qualité? Idéalement, suivez les deux: part de réponses IA avec lien + KPI d’engagement en aval.

- Variabilité des interfaces et des modes. ChatGPT/Gemini n’exposent pas toujours des citations; limitez la mesure aux modes documentés.

- Biais de corpus. Un panier trop restreint ou trop « marque » gonflera artificiellement votre score. Équilibrez les intentions, y compris des requêtes non‑marque à volume réaliste.

Exemple pratique (intégration neutre)

En pratique, un outil peut agréger les mentions et citations issues d’AI Overviews, Perplexity et des modes web de ChatGPT/Gemini, calculer automatiquement les sous‑scores et tracer l’historique. Divulgation : Geneo est notre produit. Dans un workflow type, l’outil distingue « mention » et « citation liée », applique les pondérations déclarées, affiche la tendance par moteur et met en évidence les requêtes où la part de voix recule.

Actions concrètes pour améliorer chaque sous‑métrique

- Présence et couverture moteurs. Élargissez la couverture thématique par clusters, adressez les questions composées (how‑to, comparatifs) et publiez des formats que les moteurs aiment citer (pas‑à‑pas, tableaux). Pour situer la terminologie (GEO, GSVO, AIO, LLMO), voyez ce décryptage utile (Nouveaux acronymes SEO liés à l’IA — GEO, GSVO, AIO, LLMO).

- Citations liées. Renforcez la « citabilité » de vos pages: études originales, données propriétaires, FAQ dédiées, schémas/étapes clairs, mentions d’auteurs experts et sources. Des liens éditoriaux de qualité vers ces actifs aident aussi.

- Position et part de voix. Structurez vos contenus pour être listés en tête (résumés clairs, sections nettes, ancres internes). Couvrez les alternatives/concurrents de façon impartiale pour accrocher la réponse IA tout en captant plus de part de voix.

- Sentiment. Traitez les critiques récurrentes sur vos pages d’aide/FAQ, publiez des réponses officielles aux inexactitudes et mettez en avant des preuves (méthodes, certifications, avis vérifiés).

Ressources et prochaine étape

- Recommandations officielles sur la performance dans l’AI search (contenu utile, UX, éligibilité): l’analyse 2025 de Google est un bon point de départ (Google Search Central 2025 — réussir dans l’AI search).

- Comprendre l’attribution par citations: la documentation de Perplexity détaille la mécanique de liens vers les sources (Centre d’aide Perplexity — fonctionnement et citations).

- Modes web et citations dans ChatGPT: l’annonce « ChatGPT Search » résume ce qu’il faut mesurer en priorité (OpenAI — Introducing ChatGPT Search).

- Méthodes d’indicateurs composites: cadre et bonnes pratiques pour la normalisation et l’audit (Handbook OCDE/JRC — indicateurs composites).

Envie de benchmarker votre score sur vos requêtes clés et de suivre la tendance par moteur? Essayez Geneo pour un essai sans friction et comparez‑vous à votre panel de concurrents: https://geneo.app