AI Search Crawling : comprendre, contrôler et optimiser l’exploration IA

Décryptage technique du AI Search Crawling : pipeline, bots IA, contrôles d’accès, sitemaps et bonnes pratiques pour maîtriser votre visibilité et vos citations.

Comment les moteurs de réponse IA « trouvent » vos pages, les assimilent, puis les citent — ou les ignorent ? Le « AI Search Crawling » désigne l’ensemble des opérations qui permettent aux moteurs assistés par IA (answer engines, RAG) de découvrir, explorer, récupérer, analyser, indexer puis réutiliser le contenu du Web dans leurs réponses.

1) Le pipeline technique, étape par étape

Pensez au pipeline comme à une chaîne logistique. À l’entrée, on repère les sources (discovery), on envoie des collecteurs (crawling), on rapatrie la marchandise (fetching), on la déballe et l’organise (parsing), on la range dans un entrepôt structuré (indexing), puis on la ressort à la demande (retrieval) pour composer un « plat » (generation) avec des références.

- Discovery : sitemaps, liens, signaux de notoriété, IndexNow, index tiers.

- Crawling : visites automatisées par des bots identifiés (ou non…), respect (volontaire) de robots.txt.

- Fetching : téléchargement des ressources, gestion du rendu (HTML, JS, images…).

- Parsing : extraction du texte, métadonnées, schémas, segmentation en « chunks ».

- Indexing : embeddings vectoriels et stockage dans une base (souvent hybride texte+vecteur), prêts pour un top‑k.

- Retrieval : recherche sémantique/lexicale, reranking, sélection des passages.

- Generation : le LLM assemble une réponse et peut afficher des citations.

Pour cadrer vos priorités, gardez deux idées : (1) discovery et crawling déterminent ce qui entre dans le système ; (2) parsing/structuration conditionnent la qualité de la citation et de la restitution.

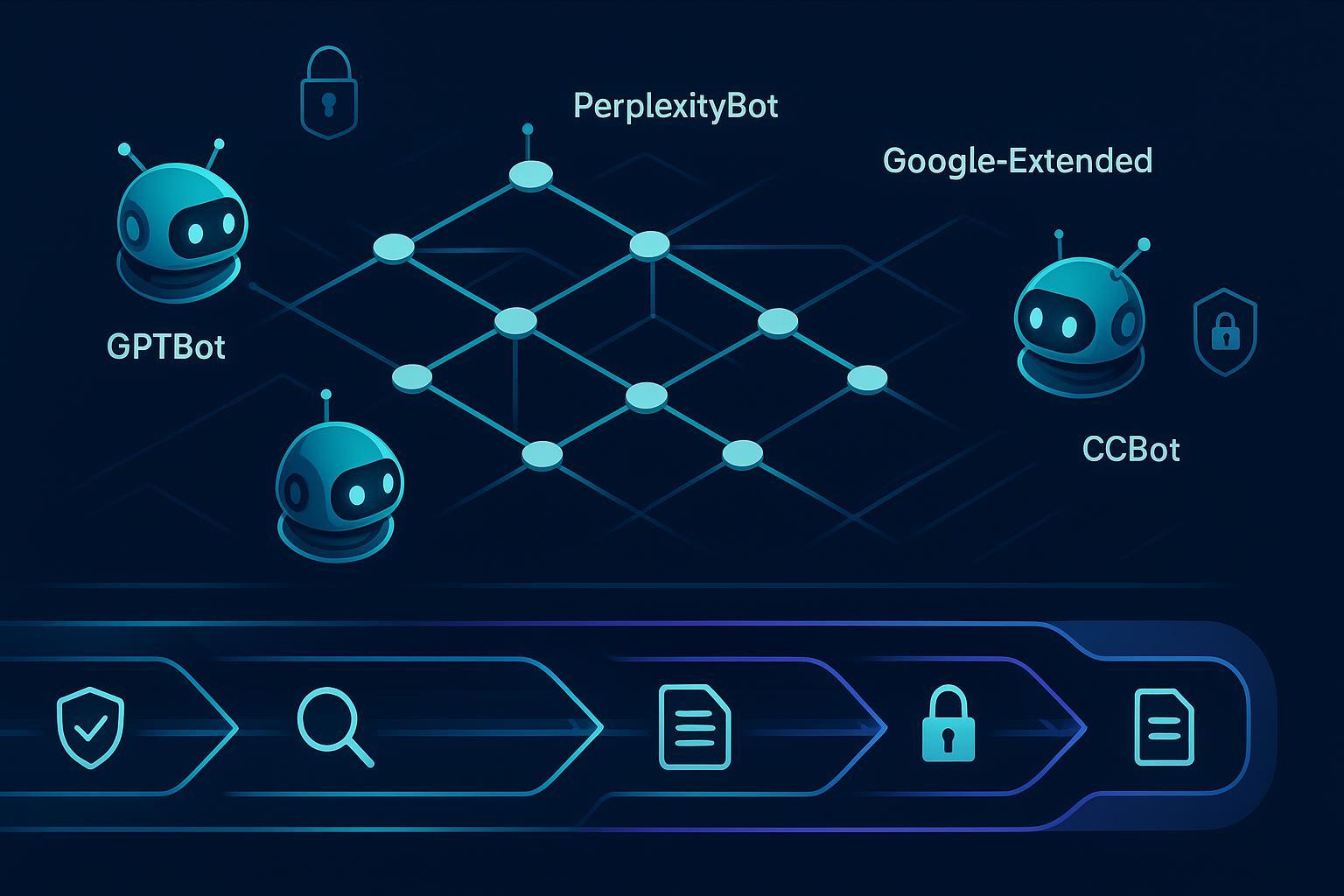

2) Qui crawle aujourd’hui ? (panorama 2024–2025)

Les moteurs IA combinent plusieurs sources : leurs propres crawlers, des index publics/partagés et des signaux éditeurs. Voici un aperçu synthétique des agents courants et de la manière de les contrôler.

| Bot / User‑Agent (exemples) | Usage principal | Contrôle recommandé | Référence |

|---|---|---|---|

| Google AI Features / Google‑Extended | Fonctionnalités IA liées à l’écosystème Google (réutilisation contrôlée) | robots.txt + directives spécifiques aux AI features | Guide officiel « AI Features and Your Website » de Google Search Central (2025) : lignes directrices |

| CCBot (Common Crawl) | Corpus ouvert à large échelle, réutilisé par des acteurs IA | robots.txt, validation IP + reverse DNS | Billet Common Crawl (2025) sur transparence et respect des règles : engagement public |

| GPTBot (déclaré par la communauté) | Ingestion et/ou vérification pour systèmes OpenAI (selon périodes et usages) | robots.txt + validation multi‑facteurs (UA+IP+rDNS) | En l’absence d’une page consolidée officielle, vérifier localement et suivre les annonces OpenAI |

| PerplexityBot / Perplexity‑User | Récupération côté service et fetch déclenché par l’utilisateur | robots.txt + allowlist des IP publiées + WAF | Documentation Perplexity (2025) « Bots & IP ranges » : références techniques |

Remarques utiles :

- Certains opérateurs combinent crawl propriétaire et ingestion via des index tiers. Les « AI features » peuvent avoir leurs propres mécanismes de contrôle, distincts de Search.

- Les user‑agents étant usurpables, fiez‑vous à une validation multi‑facteurs (voir section 3).

3) Contrôler l’accès : robots.txt, validation multi‑facteurs et WAF

Robots.txt reste la première couche : vous y autorisez ou bloquez des agents par nom. Mais son respect est volontaire, et sa portée concerne le crawl, pas toujours l’indexation. Google rappelle aussi que certaines directives traditionnelles (comme « crawl‑delay ») ne sont pas prises en charge par Googlebot — la gestion du débit relève plutôt de votre WAF ou d’un rate limiting. Voir le rappel de Google dans le guide « Robots.txt » : documentation Search Central (2025).

Exemple indicatif (à adapter à votre politique d’accès) :

# Ouvrir à Googlebot, restreindre certains bots IA (exemple pédagogique)

User-agent: Googlebot

Allow: /

# Règles par défaut

User-agent: *

Disallow: /private/

# Bloquer des bots IA spécifiques (selon vos objectifs)

User-agent: GPTBot

Disallow: /

User-agent: PerplexityBot

Disallow: /

# Autoriser explicitement Common Crawl si vous souhaitez contribuer au corpus ouvert

User-agent: CCBot

Allow: /

Au‑delà de robots.txt : mettez en place une validation multi‑facteurs côté serveur pour distinguer un bot légitime d’un script opportuniste. Combinez :

- User‑Agent attendu, exact (sensible à la casse et aux variantes) ;

- IP dans une plage publiée officiellement par l’éditeur ;

- Reverse DNS cohérent (le PTR remonte vers le domaine officiel, et la résolution avant/arrière concorde).

Enfin, un WAF moderne (ex. règles « verified bots », réponses conditionnelles 403/402, rate limiting) apporte un contrôle opérationnel robuste. Cloudflare documente ces approches et l’augmentation du trafic des bots IA dans « Declaring your AIndependence… » (2024) : guide Cloudflare en français.

4) Accélérer la découverte utile : sitemaps complets + IndexNow

La meilleure exploration, c’est souvent celle que vous facilitez. Des sitemaps XML propres, exhaustifs, avec un « lastmod » fiable, aident les moteurs à cibler les bonnes URLs. Pour les changements fréquents, IndexNow permet d’annoncer instantanément des ajouts/mises à jour/suppressions aux moteurs participants. Microsoft a détaillé en 2025 les gains mesurés côté shopping/ads et la réduction du crawl inutile : voir l’article du Bing Webmaster Blog (31 juillet 2025) : « IndexNow Enables Faster and More Reliable Updates… ».

Astuce pratique : couplez un sitemap principal (index) avec des sitemaps thématiques et un flux IndexNow déclenché à chaque événement CMS significatif (publication, mise à jour, dépublication). Documentez le tout dans vos runbooks.

5) Logs et observation continue : vérifier un « vrai » bot IA

Sans observation, difficile d’arbitrer. Une routine d’analyse de logs vous fera gagner du temps et des nerfs. Voici une checklist de base :

- Échantillonnez quotidiennement les visites par UA « IA » (GPTBot, PerplexityBot, CCBot, Google‑Extended) ; corrélez UA, IP, en‑têtes, timing, et URL scannées.

- Vérifiez l’IP : appartient‑elle à une plage publiée par l’éditeur ? Si oui, confirmez via reverse DNS (PTR) et vérifiez la concordance avant/arrière.

- Comparez le comportement : cadence de hits, respect de robots.txt, zones visitées. Un bot « furtif » laisse souvent des motifs atypiques.

- Automatisez des alertes (WAF, SIEM) : dépassements de seuil, UA inconnus, résolutions DNS suspectes.

- Tenez un registre des exceptions (périodes de test, migrations) pour éviter de bloquer un partenaire légitime par erreur.

6) Controverses 2024–2025 : rester factuel et précautionneux

Le respect de robots.txt varie selon les opérateurs et évolue dans le temps. Des acteurs de l’infrastructure ont observé la montée des crawlers IA et, ponctuellement, des comportements contournant les contrôles classiques. Cloudflare décrit ces tendances et propose des mécanismes de blocage/autorisation granulaire dans son billet de 2024 (voir la référence en section 3).

S’agissant de Perplexity, l’éditeur publie une page technique listant les user‑agents et (selon périodes) des plages IP, utile pour configurer vos règles. Référez‑vous à la documentation « Bots » (2025) : guide Perplexity. Là encore, privilégiez une politique observable : UA + IP officielles + reverse DNS, et remontez les anomalies à l’éditeur.

Du côté des corpus ouverts, Common Crawl réaffirme en 2025 le respect de robots.txt, l’identification claire « CCBot » et l’usage d’IP dédiées vérifiables : voir l’engagement de transparence 2025. En pratique : testez localement et ne généralisez pas à partir d’un cas isolé.

7) Favoriser la citation correcte dans les réponses IA

Vous voulez être cité clairement, avec un lien propre ? Voici les leviers qui aident concrètement :

- Données structurées (schema.org) cohérentes avec le contenu réel : FAQ/HowTo/Produit, auteurs, dates, canoniques.

- Propreté technique : titres uniques, canoniques stables, performance correcte, absence d’erreurs 4xx/5xx récurrentes.

- Signal éditorial : sources primaires, mentions de licence et d’attribution explicites quand pertinent (cela guide les systèmes qui affichent des citations).

- Fraîcheur contrôlée : sitemaps + IndexNow + flux RSS/Atom si vous en disposez.

- Cohérence multi‑pages : évitez les duplications concurrentes et alignez les résumés/abstracts avec la page source.

Astuce : dans vos pages « cornerstone », ajoutez une section « Sources et méthodologie » bien balisée. Beaucoup de moteurs récupèrent ces indices au parsing pour nourrir la restitution et la citation.

8) Pour aller plus loin : suivre votre visibilité IA

Disclosure : Geneo est notre produit. Pour les équipes qui souhaitent mesurer comment leur marque est reprise dans des réponses IA (ChatGPT, Perplexity, AI Overviews) et surveiller les citations/mentions, Geneo peut centraliser ce suivi multi‑plateforme et fournir des alertes et historiques utiles. En savoir plus : Geneo – plateforme de visibilité IA.

9) Résumé actionnable

- Clarifiez vos objectifs : ouverture à l’IA (citation/diffusion) ou protection (limiter l’ingestion) — souvent un mix selon les sections du site.

- Appliquez des règles robots.txt cohérentes, mais prévoyez leur limite : complétez par validation UA+IP+reverse DNS et un WAF moderne.

- Optimisez la découvrabilité utile : sitemaps propres, « lastmod » fiable, et IndexNow côté CMS.

- Mettez en place l’observabilité : collecte de logs, détection d’anomalies, runbooks d’escalade vers les éditeurs.

- Renforcez la citation : données structurées, canoniques clairs, qualité éditoriale et transparence méthodologique.

L’« AI Search Crawling » bouge vite, mais votre terrain de jeu est stable : contrôles d’accès, propreté technique, signaux de découverte, et observation continue. Quelle première action mettrez‑vous en place cette semaine : durcir vos règles d’accès ou documenter vos sitemaps et IndexNow ?