AI search analytics : meilleures pratiques 2025 pour finance, santé, juridique

Guide expert 2025 sur l’analyse IA multi-plateformes dans les secteurs réglementés : conformité, monitoring, auditabilité, KPIs et intégration Geneo.

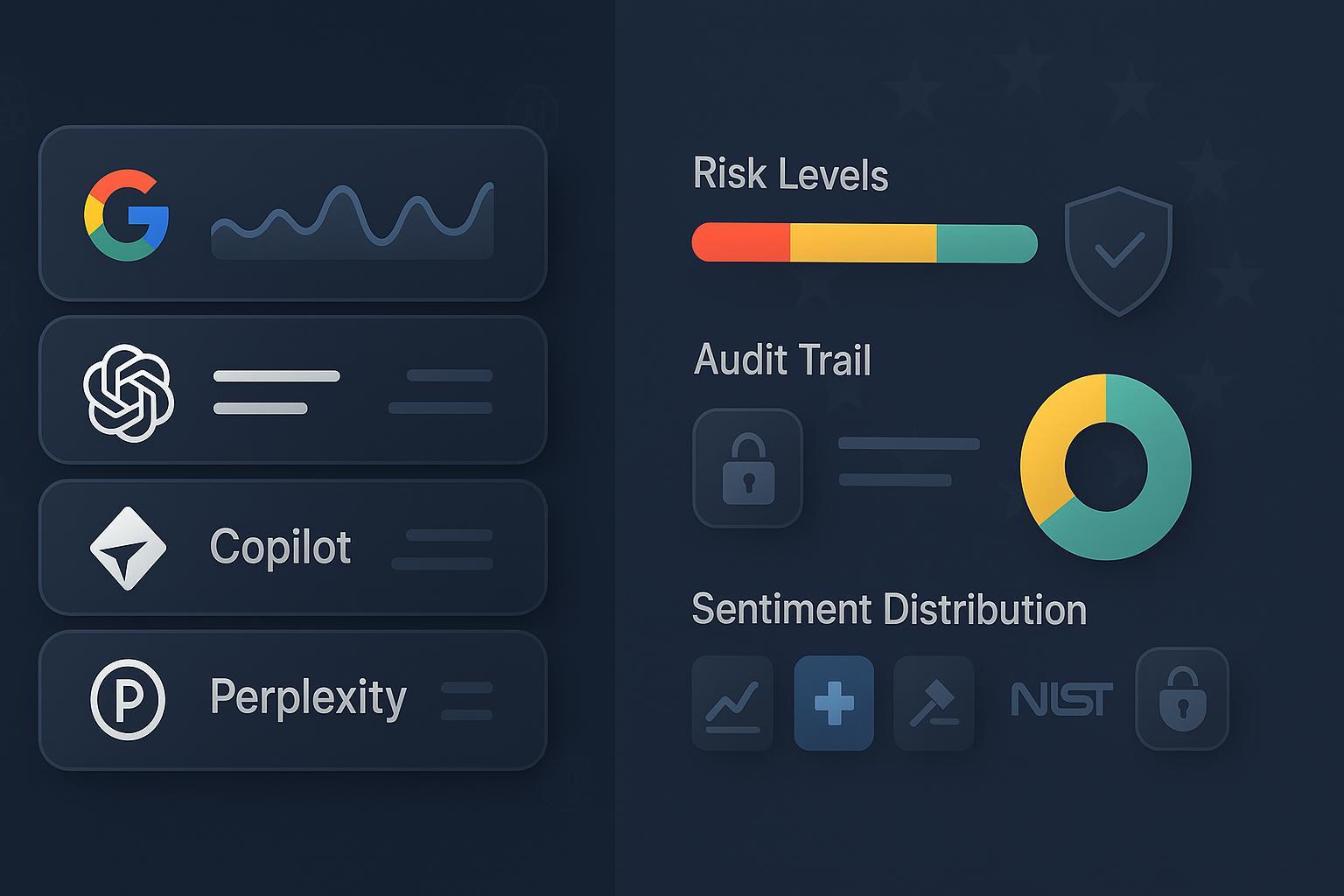

La visibilité de votre marque et de vos contenus n’est plus seulement une affaire de SEO classique. En 2025, les réponses générées par des assistants comme Google AI Overviews, ChatGPT, Copilot ou Perplexity deviennent des « points d’entrée » informationnels. Pour les secteurs réglementés, analyser et piloter cette exposition exige une gouvernance robuste, une auditabilité sans faille et une supervision humaine. Les lignes qui suivent condensent des pratiques éprouvées sur le terrain, alignées sur le cadre réglementaire actuel (UE, UK, US) et sur des références techniques reconnues.

- Le cadre européen impose désormais des obligations explicites pour la gestion des risques, la qualité des données et la supervision humaine des systèmes d’IA, telles que décrites dans l’AI Act (Commission, 2024) et le texte officiel sur EUR‑Lex 2024/1689.

- Côté sécurité et gestion des risques, des cadres de référence comme le NIST AI RMF 1.0 (2023‑2025) et le NIST CSF 2.0 (2024) aident à orchestrer gouvernance, contrôles et métriques.

- Les autorités nationales renforcent leurs attentes. En France, la CNIL a publié des recommandations 2025 pour le développement des systèmes d’IA, utiles pour cadrer la conformité by design.

Ce guide privilégie l’action: processus, checklists, KPIs et scénarios concrets, avec intégration outillée lorsque pertinent (ex: Geneo) pour industrialiser le monitoring et l’audit.

1) Gouvernance et conformité by design: l’ossature en 2025

Ce qui fonctionne de manière fiable dans les organisations matures:

- Cartographier les cas d’usage et les flux de données

- Distinguez contenus publics (monitorables) et données sensibles (PII/PHI, secrets d’affaires) et documentez les bases légales RGPD. Pour les traitements à risque, planifiez une analyse d’impact (DPIA) selon les guides de la CNIL sur les DPIA/IA.

- Marquez clairement ce qui peut être envoyé à des services externes et ce qui doit rester en interne (RAG contrôlé, data minimization).

- Encadrer les systèmes et tiers selon l’AI Act et les normes

- Appliquez l’approche par le risque de l’AI Act (EUR‑Lex 2024/1689) et documentez: sources de données, processus de vérification, supervision humaine.

- Déployez une gestion des risques IA suivant le NIST AI RMF (Govern‑Map‑Measure‑Manage) et alignez la cybersécurité avec le NIST CSF 2.0 (2024).

- Sécurité et menace: intégration des bonnes pratiques ENISA

- Reliez votre dispositif IA au cadre multi‑couches d’ENISA et à son panorama des menaces. Les publications 2024 soulignent la montée des risques IA/LLM et l’importance du monitoring continu, comme indiqué dans le ENISA Threat Landscape 2024.

- Les investissements NIS 2024 relèvent qu’environ « 30% » des organisations ayant déployé l’IA ont connu des incidents liés à l’IA, avec une lacune fréquente sur l’audit des fournisseurs tiers, d’après le rapport ENISA NIS Investments 2024. Traduction opérationnelle: due diligence renforcée, contractualisation solide, supervision et journaux.

- Politiques internes et supervision humaine

- Définissez un circuit de validation humaine préalable pour toute communication à risque (finance, santé, juridique), et un registre des justifications et sources.

- Tenez à jour une politique « usage des IA » (plateformes autorisées, prompts interdits, données prohibées) et formez les équipes.

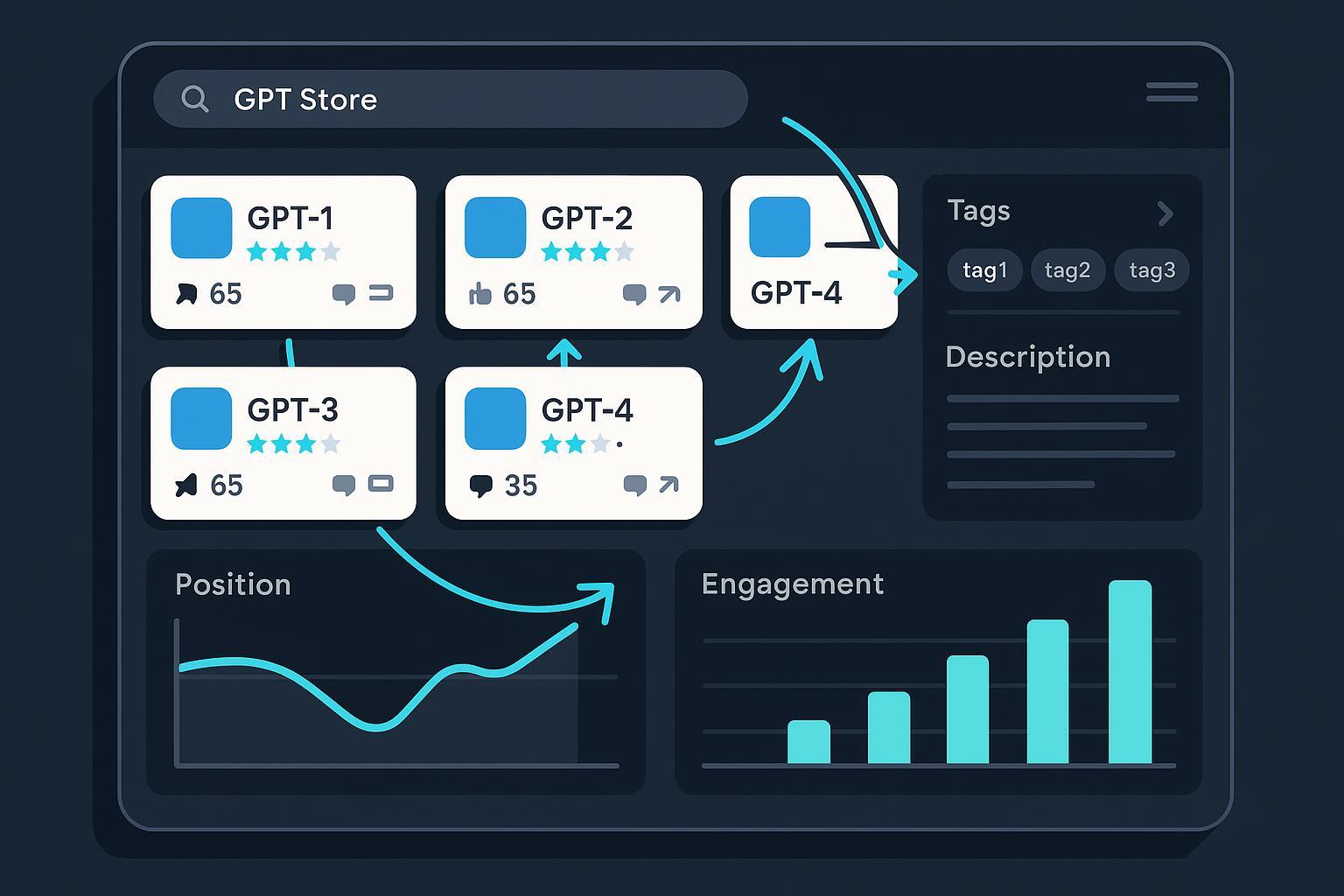

2) Playbook opérationnel d’AI search analytics (multi‑plateformes)

Objectif: surveiller ce que « disent » de vous les AI Overviews, ChatGPT, Copilot et Perplexity; détecter erreurs/allégations à risque; corriger à la source; prouver l’auditabilité.

Étape A — Périmètre et instrumentation

- Ciblez vos requêtes stratégiques (marque, produits, dirigeants) et sensibles (indications santé, performance financière, mentions juridiques). Sur Google, suivez les changements de SERP/Overviews en lien avec les Search updates 2024‑2025.

- Activez la journalisation: prompts, réponses, sources citées, captures temporelles, scores de sentiment, tag des thématiques à risques.

Étape B — Règles d’alerte et triage

- Définissez des déclencheurs: absence de citations fiables, contradictions avec vos fiches officielles, allégations règlementées.

- Équipez un triage par criticité: haut (risque réglementaire direct), moyen (réputation), faible (inexactitudes mineures). Pour Copilot, comprenez comment sont exposées les sources « From the web » et la confidentialité, via la doc Microsoft 365 Copilot – privacy and protections.

Étape C — Boucle de correction (content ops)

- Corrigez d’abord la base: pages officielles, FAQs, documents réglementés. Mesurez l’impact sur les Overviews ou les assistants dans les semaines suivantes.

- Documentez chaque modification et son effet pour vos audits; cadrez les tests (avant/après) et tenez un changelog.

Étape D — Evidence pack et reporting

- Constituez des « packets » d’évidence: historiques, captures, liens sources, évaluations humaines, décision d’escalade, MTTR.

- Pour les parties prenantes internes, créez des tableaux de bord mensuels avec KPIs (voir section 6).

Note plateformes: Google publie régulièrement des mises à jour de cœur et des exigences de qualité (« people‑first ») détaillées sur Search Essentials et sur le blog des core updates 2024. Microsoft décrit l’accès web et la référence aux sources pour Copilot sur Manage public web access. Adaptez vos contrôles en conséquence.

3) Intégration outillée: où Geneo apporte de la valeur

Dans les environnements réglementés, l’industrialisation du monitoring et de l’audit change l’échelle. Geneo, plateforme d’optimisation de visibilité IA, est utile lorsqu’il faut:

- Suivre en temps réel les expositions multi‑plateformes (ChatGPT, Perplexity, Google AI Overviews) et centraliser mentions et liens cités.

- Noter la tonalité des réponses avec une analyse de sentiment (détection de signaux faibles réputationnels et de risques de non‑conformité).

- Conserver un historique requêtes‑réponses pour l’audit, comparer les évolutions, alimenter des rapports pour Compliance.

- Générer des recommandations de contenu pour corriger les erreurs détectées sans déroger au cadre réglementaire sectoriel.

Exemples de mise en œuvre Geneo par contrôle interne:

- Gouvernance: segmentation par marque/pays; RBAC; journalisation horodatée; exports à fin d’audit.

- Opérations: règles d’alerting par mots‑clés sensibles; intégrations Slack/Jira/Email; exports vers SIEM/GRC via API.

- KPI: tableaux de bord par secteur (finance/santé/juridique), temps de correction (MTTR), taux d’allégations corrigées, part de réponses avec citations fiables.

Essayez Geneo: https://geneo.app

4) Scénarios sectoriels « real‑world » et modes opératoires

Finance (banques, asset management)

- Enjeu: communications exactes et contrôlées; gestion du risque d’« AI washing ». Au Royaume‑Uni, le superviseur met l’accent sur proportionnalité et résilience opérationnelle, comme le montrent l’AI Update 2024 de la FCA et l’étude conjointe Artificial intelligence in UK financial services 2024 (BoE/FCA).

- Workflow recommandé:

- Définir une liste d’allégations « interdites » (promesses de performance, comparatifs non étayés, déclarations prospectives non cadrées) et configurer des alertes.

- Revue hebdomadaire des mentions IA par Compliance; échantillonnage de précision; scoring de risque.

- Correction de la base documentaire (KID/KIIDs, fiches fonds, pages produits), suivi d’impact sur AI Overviews et Copilot.

- Reporting mensuel au comité des risques (taux d’exactitude, incidents, MTTR) et evidence pack archivé.

Santé (industriels, hôpitaux, e‑santé)

- Enjeu: confidentialité (RGPD, HDS) et encadrement des allégations santé. En France, l’hébergement de données de santé requiert la certification HDS, intégrée à la doctrine publique, cf. la feuille de route du numérique en santé 2023‑2027. Côté dispositifs médicaux, les évolutions algorithmiques doivent être prévues via les Predetermined Change Control Plans (PCCP) de la FDA.

- Workflow recommandé:

- Filtrer les requêtes monitorées pour éviter toute PHI; ne traiter que des contenus publics et anonymes; documenter la base légale.

- Maintenir une liste d’énoncés interdits: indications hors AMM, comparatifs non autorisés, promesses d’efficacité; configurer des alertes.

- Escalade immédiate vers l’équipe réglementaire/médicale en cas d’allégation détectée; revue humaine et décisions.

- Correction des pages officielles/FAQ approuvées; suivi de l’évolution des réponses IA; constitution d’un dossier d’audit.

Juridique (cabinets, directions juridiques)

- Enjeu: exactitude, confidentialité et secret professionnel. Réduisez l’exposition d’informations internes et préférez des bases de connaissance validées. Pour les assistants internes, appliquez un RAG contrôlé et une supervision humaine systématique; pour les plateformes publiques, ne poussez aucune donnée sensible.

- Workflow recommandé:

- Liste blanche de sources doctrinales/jurisprudences vérifiées à utiliser dans les contenus publics.

- Monitoring des mentions du cabinet et des interprétations juridiques dans les assistants IA; signalement des erreurs.

- Correction par notes d’actualité/FAQs et articles de référence; suivi de la rectification dans les réponses IA.

- Journalisation pour prouver diligence et traçabilité.

5) Architecture de contrôle et intégrations: modèle de référence

- Collecte et normalisation: agrégation des réponses AI (Overviews, ChatGPT, Copilot, Perplexity) avec métadonnées (timestamp, source, langue, sentiment, liens cités).

- Gouvernance des accès: RBAC, séparation des rôles (ops vs compliance), sauvegarde chiffrée, rétention selon politique sectorielle.

- Chaîne d’alerte: moteur de règles (mots‑clés réglementés), scoring, enrichissement (produit/secteur/pays), webhooks Slack/Jira/ITSM.

- Observabilité et sécurité: journaux immuables, détection d’anomalies, intégration SIEM; alignement sur NIST CSF 2.0 (2024).

- Dossiers d’audit: exports horodatés, conservation des versions, liens vers sources citées; alignement avec principes de l’AI Act – obligations de documentation.

Geneo dans cette architecture: connecteurs multi‑plateformes, historique consolidé, analyse de sentiment, alerting configurable, exports vers SIEM/GRC, et recommandations de correction de contenu.

6) KPIs, seuils et SLA d’assainissement

Suivez des indicateurs stables, comparables et audités:

- Qualité de réponse: taux d’exactitude vérifiée (échantillon mensuel), part de réponses avec citations fiables, taux d’hallucinations détectées.

- Risque & conformité: nombre d’allégations sensibles détectées (santé/finance), incidents critiques, MTTR (heures/jours) et taux de réapparition après correction.

- Couverture & exposition: proportion de requêtes stratégiques couvertes par votre monitoring, distribution par plateforme/territoire/lingue.

- Confiance & perception: sentiment moyen et répartition; corrélation avec vos initiatives de correction.

Pragmatisme: démarrez avec 6–8 KPIs maximum; ajoutez ensuite des métriques de second niveau (ex: profondeur de citation, diversité des sources, volatilité des réponses par mise à jour Google). Les mises à jour de Google sont documentées dans le hub Search updates, utile pour interpréter des variations soudaines.

7) Audits et preuves: comment « tenir la ligne » face aux régulateurs

- Dossier standard: cartographie des cas d’usage, DPIA (si requis), politique IA interne, registres d’accès, packs d’évidence (captures, logs), décisions de triage, corrections effectuées, résultats mesurés.

- Alignement cadre: rattachez chaque contrôle à un référentiel (AI Act, CNIL, NIST AI RMF, ENISA). Par exemple, mappez « journalisation des réponses IA » à AI RMF (Manage) et à vos obligations de documentation selon l’AI Act – documentation et supervision.

- Revue périodique: audit trimestriel interne; audit croisé annuel (sécurité/compliance); tests adverses (red teaming) recommandés par l’ENISA – bonnes pratiques IA.

8) Alerte réglementation 2025 et veille continue

- AI Act: entré en vigueur le 1er août 2024, avec un déploiement progressif des obligations selon le niveau de risque et des actes d’application en cours, d’après la communication de la Commission (2024). Préparez des feuilles de route sur 12–36 mois.

- UK supervision financière: travaux conjoints BoE/FCA sur IA/ML et résilience opérationnelle, cf. Financial Stability in Focus – avril 2025 (BoE) et l’AI Update 2024 (FCA).

- Santé numérique: suivez les mises à jour FDA pour les PCCP des dispositifs IA/ML et les évolutions nationales (ex: doctrine HDS en France via la feuille de route 2023‑2027).

Mettez en place une « cellule de veille IA » avec un tableau de bord trimestriel et un plan de mise en conformité incrémental.

9) Checklists actionnables

Checklist — Mise en place initiale

- [ ] Périmètre de requêtes sensibles défini et validé par Compliance/Juridique

- [ ] Politique d’usage des IA publiée (données prohibées, prompts, plateformes autorisées)

- [ ] Journalisation et stockage sécurisé opérationnels (RBAC, rétention)

- [ ] Règles d’alerte et triage par criticité configurées

- [ ] Boucle de correction (content ops) et changelog en place

- [ ] Tableau de bord KPIs et reporting mensuel

Checklist — Intégration Geneo

- [ ] Connexion multi‑plateformes (ChatGPT, Perplexity, Google AI Overviews)

- [ ] Analyse de sentiment et détection de signaux faibles activées

- [ ] Règles d’alerte sectorielles (finance/santé/juridique) configurées

- [ ] Exports SIEM/GRC et notifications Slack/Jira/Email

- [ ] Evidence packs automatisés (captures, logs, décisions)

Checklist — Audits/Conformité

- [ ] DPIA (si nécessaire) et mapping aux obligations AI Act/NIST/ENISA

- [ ] Revue humaine systématique des contenus à risque

- [ ] Tests adverses/contrôles périodiques (au moins trimestriels)

- [ ] Registre de décisions et justificatifs prêt pour inspection

Conclusion pratique

L’AI search analytics n’est ni un gadget marketing, ni une simple extension du SEO. C’est un dispositif de conformité et de résilience éditoriale. En combinant un cadre rigoureux (AI Act, CNIL, NIST, ENISA), une boucle opérationnelle outillée (monitoring, alertes, correction, audit) et des indicateurs maîtrisés, les organisations des secteurs réglementés réduisent le risque et améliorent la qualité de l’information délivrée au public. L’important est de démarrer avec un périmètre clair, de tracer systématiquement, et d’itérer. Des plateformes comme Geneo aident à industrialiser ces routines tout en restant dans les limites strictes des réglementations applicables.

—

Prêt à industrialiser votre monitoring multi‑plateformes dans un cadre conforme? Découvrez Geneo et demandez une démo: https://geneo.app