¿Qué es la mitigación de alucinaciones en LLM? Definición, técnicas y aplicaciones en IA y SEO

Descubre qué es la mitigación de alucinaciones en LLM: definición, técnicas clave como RAG, fact-checking y cache semántico, y su impacto en motores de búsqueda, reputación de marca y SEO. Aprende cómo proteger tu marca frente a respuestas inexactas de la IA.

Definición en una frase

La mitigación de alucinaciones en LLM (Large Language Model Hallucination Mitigation) es el conjunto de técnicas y estrategias para reducir o prevenir que los modelos de lenguaje generen respuestas inexactas, inventadas o engañosas.

Explicación detallada

Los modelos de lenguaje grandes (LLM), como ChatGPT o Google AI Overview, generan texto prediciendo la siguiente palabra más probable según patrones aprendidos de grandes volúmenes de datos. Sin embargo, debido a su naturaleza probabilística y a la falta de comprensión real del mundo, pueden producir respuestas que parecen correctas pero son falsas o incoherentes: esto se denomina "alucinación". Es como ver figuras en las nubes: el modelo detecta patrones donde no los hay realmente (IBM).

Las alucinaciones pueden afectar gravemente la confianza en la IA, la reputación de marca y la toma de decisiones basada en IA, especialmente en motores de búsqueda, asistentes virtuales y sistemas de recomendación.

Componentes clave de la mitigación

- Control de temperatura y entropía: Ajustar la creatividad del modelo para priorizar precisión sobre originalidad.

- Entrenamiento con datos de alta calidad: Usar datos diversos, actualizados y verificados para reducir sesgos y errores.

- RAG (Retrieval Augmented Generation): Integrar recuperación de información en tiempo real desde bases de datos externas para anclar las respuestas en hechos verificables (InterSystems).

- Caché semántico verificado: Almacenar preguntas y respuestas validadas para responder con información fiable antes de generar texto nuevo (ejemplo técnico).

- Fact-checking automatizado y feedback humano: Implementar sistemas de verificación automática y revisión por expertos para filtrar respuestas incorrectas.

Aplicaciones prácticas y casos de uso

- Motores de búsqueda de IA: Google AI Overview, Perplexity y ChatGPT pueden mostrar respuestas alucinadas sobre marcas o productos. La mitigación es clave para evitar la difusión de información errónea y proteger la reputación digital.

- SEO y reputación de marca: Optimizar el contenido para ser citado correctamente por LLM (estructura clara, datos verificables, autoridad) aumenta la probabilidad de respuestas precisas y reduce el riesgo de alucinaciones (guía SEO IA).

- Plataformas de monitoreo: Herramientas como Geneo permiten monitorizar en tiempo real las menciones y respuestas generadas por IA, alertando sobre posibles alucinaciones y sugiriendo acciones correctivas para proteger la imagen de la marca.

- Ejemplo aplicado: Una marca detecta una respuesta alucinada en Google AI Overview; Geneo alerta al equipo y recomienda optimizar el contenido fuente y solicitar corrección en plataformas clave.

Visualización sugerida

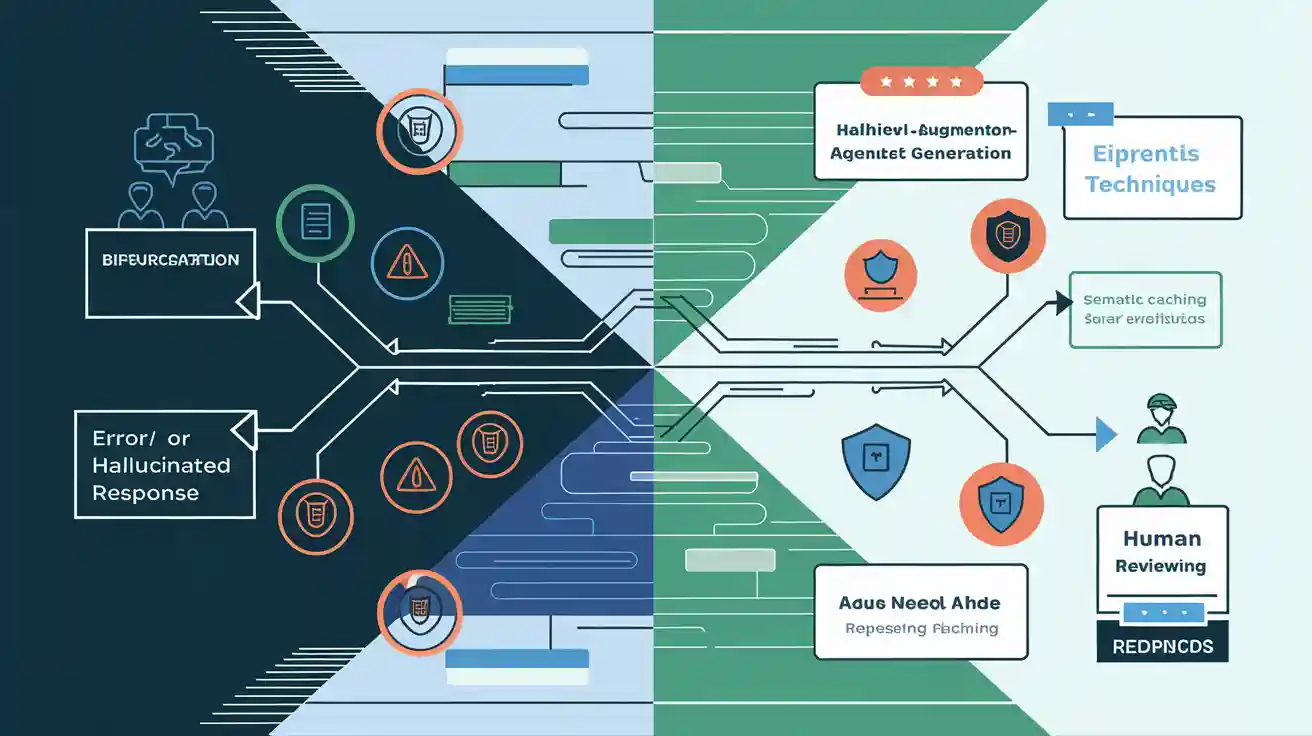

- Diagrama de flujo: Proceso desde la generación de una respuesta por el LLM, bifurcando en una rama de alucinación (con advertencia) y otra de mitigación (con RAG, cache semántico y revisión humana).

- Tabla comparativa: Técnicas de mitigación y su efectividad en diferentes escenarios (ver imagen de portada).

Conceptos relacionados

- RAG (Retrieval Augmented Generation): Técnica que reduce alucinaciones anclando respuestas en datos externos.

- AEO (Answer Engine Optimization): Optimización para motores de respuesta basados en IA.

- Fact-checking automatizado: Sistemas que verifican la veracidad de las respuestas generadas por IA.

- SEO para IA: Estrategias para mejorar la visibilidad y precisión de la información en motores de búsqueda impulsados por IA.

- Modelos de lenguaje grandes (LLM): Algoritmos de IA entrenados con grandes volúmenes de texto para generar lenguaje natural.

¿Quieres monitorizar y proteger tu marca frente a alucinaciones de IA en motores de búsqueda? Descubre cómo Geneo puede ayudarte: geneo.app