Markenreputation in der KI-Suche: Bedeutung, Signale, Messung

Erklärt, warum Markenreputation für die KI-Suche entscheidend ist. Praxisnah: E-E-A-T, Trust-Signale, Monitoring, KPIs und Risiko-Compliance.

Die Art, wie Menschen Antworten finden, hat sich spürbar verändert: Antwort‑Engines wie Google AI Overviews, ChatGPT mit Browsing und Perplexity verdichten Inhalte direkt im Interface und zeigen Quellen sichtbar an. In diesem Umfeld entscheidet Markenreputation mit darüber, ob Ihre Inhalte überhaupt ausgewählt, korrekt zitiert und am Ende angeklickt werden. Dieser Beitrag erklärt die Mechanik dahinter, operative Hebel und verlässliche Metriken – mit klaren Quellen und einem pragmatischen Workflow.

KI‑Suche vs. klassische Websuche

Klassische Websuche liefert eine Trefferliste, aus der Nutzer manuell auswählen. KI‑gestützte Suche synthetisiert Antworten, kontextualisiert und verlinkt Quellen bereits im Antwortfeld. Google beschreibt seine „Übersichten mit KI“ als Erweiterung, die komplexe Fragen besser bedient und „Links auf unterschiedliche Weise präsentiert“ sowie „mehr Quellen anzeigt“ auf der Ergebnisseite. Mehr dazu im Beitrag „Succeeding in AI Search“ (Google, 2025).

Perplexity wiederum hebt Transparenz durch Quellen und Zitate hervor; Funktionshinweise sind im Help Center Überblick sowie im Produkt‑/Blogbereich dokumentiert. Wichtig: Attributionsregeln ändern sich; maßgeblich sind stets die offiziellen Produktseiten.

Wer neu in das Thema „Generative Engine Optimization (GEO)“ einsteigt, findet Grundlagen im GEO‑Einsteiger‑Guide zu AI Overviews.

Mechanik der Reputation in Antwort‑Engines

Reputation bestimmt, ob eine Marke als verlässliche Quelle gilt. Google betont seit den Core Updates und Spam‑Policies (März 2024), dass hilfreiche, originäre Inhalte und Vermeidung von „Site‑Reputation‑Abuse“ priorisiert werden. Das Helpful‑Content‑System wurde 2024 in die Core‑Systeme integriert; Dokumentationshinweise finden sich unter „Search updates“ (Google, 2024).

Die Search Quality Rater Guidelines (QRG, offizielles PDF) liefern das Bewertungsraster: E‑E‑A‑T (Experience, Expertise, Authoritativeness, Trustworthiness) und YMYL‑Sensitivität setzen die Latte für Seitenqualität und Vertrauenswürdigkeit. Praktisch heißt das:

- Erfahrung und Expertise müssen erkennbar sein (z. B. autorisierte Bylines, Fachprofile, belegte Methoden).

- Autorität entsteht durch externe Belege: Primärdaten, wissenschaftliche Zitate, seriöse Erwähnungen.

- Vertrauenswürdigkeit zeigt sich in Transparenz (Impressum, Kontakt), korrekten Darstellungen und verlässlichen Reviews.

Kurz gesagt: Antwort‑Engines bevorzugen zitierfähige, nachvollziehbare Inhalte mit klarer Absenderidentität. Oder anders: Wenn Ihre Inhalte wie saubere „Bausteine“ mit Quellen und Struktur auftreten, steigen die Chancen, ausgewählt zu werden.

Reputationshebel für Marken

Welche Signale stärken Ihre Auswahl als Quelle und Ihre Klickwahrscheinlichkeit, wenn Antworten bereits im Interface erscheinen?

1) Inhalte und Autorschaft

- Präzise, aktuelle, konsistente Inhalte mit klarer Autorenschaft/Bylines.

- Zitate und Primärquellen einbinden; Aussagen nachprüfbar machen.

- FAQ‑Formate und „Short Answers“ für direkte Zitierfähigkeit aufbereiten.

2) Autorität durch Primärdaten und Referenzen

- Eigene Studien/Whitepapers publizieren; methodisch transparent.

- Qualitative Erwähnungen/Backlinks aus seriösen Fachquellen fördern.

- Autorprofile mit glaubwürdigen Credentials und Beiträgen pflegen.

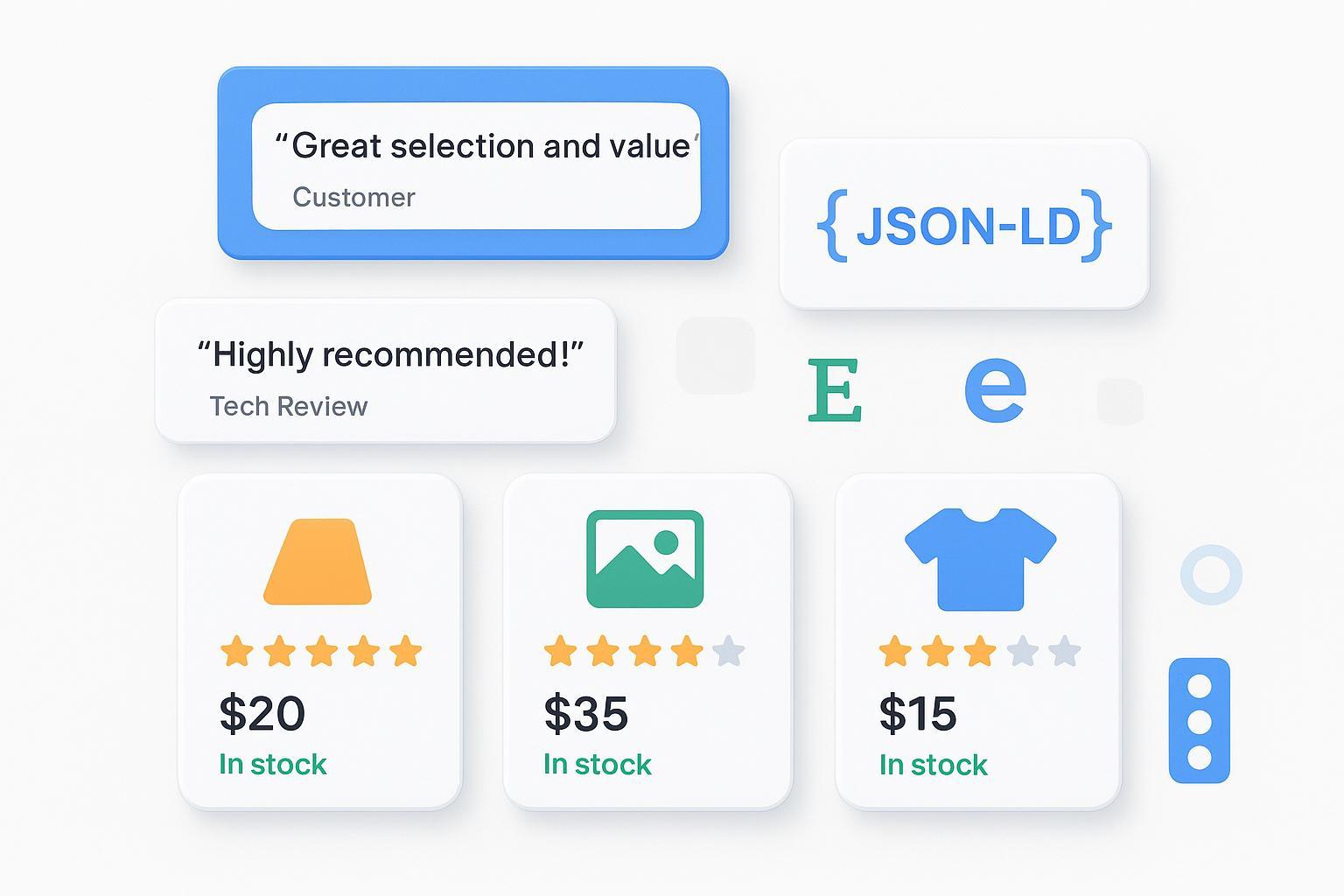

3) Vertrauenssignale und Reviews

- Authentische Nutzerbewertungen gemäß Richtlinien auszeichnen; siehe Review‑Snippet Richtlinien (Google).

- Impressum/„Über uns“, Kontakt/Support, Zertifizierungen sichtbar platzieren.

- Konsistentes Tonalitäts‑ und Reaktionsmanagement bei Kritik.

4) Strukturierte Daten und technische Sauberkeit

- Organization, Person, Product, Review und relevante Listings sauber auszeichnen; z. B. Product Daten und Merchant Listings.

- Lizenz‑ und Urheberhinweise korrekt; saubere interne Verlinkung.

- Knowledge‑Snippets/FAQ‑Sektionen maschinenlesbar gestalten.

5) Markendaten‑Konsistenz

- NAP (Name, Address, Phone), Domain und Social‑Handles konsistent über alle Plattformen.

- Einheitliche Markensprache und visuelle Konsistenz.

6) Sentiment‑Management

- Erwähnungen beobachten; Net‑Sentiment und Tonalität auswerten.

- Sachlich reagieren, Fehler korrigieren, Verbesserungen dokumentieren.

Zur Vertiefung des Zusammenhangs zwischen Sentiment und E‑E‑A‑T: Markensentiment, Vertrauen und Autorität.

Messen & Monitoren: ein schlankes KPI‑Framework

Antwort‑Engines kombinieren viele Signale; dennoch lassen sich Trends messen. Denken Sie an dieses Set als „Kontrollinstrument“ – nicht als einzelnes Ranking‑Geheimnis.

| KPI | Definition | Messhinweis |

|---|---|---|

| Share of Citations | Anteil der Marken‑Erwähnungen/Zitationen in KI‑Antworten über Plattformen hinweg | Quellenlisten pro Query erfassen; Attributionslücken beachten |

| AI‑Overview‑Präsenz | Sichtbarkeit und Zitierung in Google AI Overviews | Queries regelmäßig prüfen; Sichtbarkeit/Quellen dokumentieren |

| Sentiment‑Score | Net‑Sentiment und Tonalität der Erwähnungen | Reviews/Erwähnungen sammeln; Trend statt Einzelwert |

| Autoren‑/Domain‑Reputation | Sichtbare Bylines, Autorprofile, externe Autoritätssignale | Bylines konsistent; Profile/Markup pflegen |

| Datenkonsistenz | NAP‑Konsistenz, Markup‑Fehlerquote | Verzeichnisse synchronisieren; SD‑Validierung |

Praxis‑Workflow: Monitoring in drei Schritten

- Queries und Quellen kartieren

- Relevante Fragen/Intentionen definieren; KI‑Antworten abrufen und Quellenlisten dokumentieren.

- Für Google spezifisch: die Hinweise in „Succeeding in AI Search“ (2025) berücksichtigen.

- Sentiment und Konsistenz prüfen

- Erwähnungen und Reviews sammeln; Net‑Sentiment berechnen; strukturiertes Daten‑Audit durchführen.

- Richtlinienkonform arbeiten: siehe Structured‑Data‑Policies (Google).

- Maßnahmen priorisieren

- Zitierfähigkeit verbessern (präzise FAQs, klare Quellen, Autorprofile).

- Markendaten bereinigen, Reviews fördern, technische Hygiene sichern.

Disclosure: Geneo ist unser Produkt. Ein Monitoring‑Tool wie Geneo unterstützt solche Workflows, indem es Quellenlisten aus KI‑Antworten erfasst, Erwähnungen zentralisiert und Stimmungswerte gegenüberstellt – ohne Leistungsversprechen.

Für die Einrichtung einer strukturierten Messumgebung siehe AI Search Mapping: Anleitung.

Risiken & Compliance

- YMYL‑Themen: Bei Gesundheit, Finanzen oder Recht sind zusätzliche Belege, Expertenreview und klare Autorschaft Pflicht. Die QRG beschreiben, wie hohe Standards anzulegen sind; siehe offizielle QRG (PDF).

- Halluzinationen/Fehlzitate: Antwort‑Engines können sich irren. Quellen nachprüfen, Korrekturroutinen etablieren, sachlich kommunizieren.

- Spam/Skalierter Content: Automatisierte Inhalte sind dann problematisch, wenn sie primär Rankings manipulieren oder keinen Nutzermehrwert bieten. Hinweise dazu im März‑2024 Core Update & Spam‑Policies und im Update‑Hinweis (Google, 05.03.2024).

- Strukturierte Daten: Markup muss dem sichtbaren Inhalt entsprechen; Verstöße führen zu Ignorierung oder Maßnahmen, siehe Structured‑Data‑Policies.

Fazit: Prioritäten, die wirken

Markenreputation ist in der KI‑Suche mehr als ein Image‑Thema – sie ist ein operatives Auswahl‑ und Zitationssignal. Wer E‑E‑A‑T sichtbar macht, Inhalte zitierfähig strukturiert, Reviews und Transparenz pflegt, sauberes Markup setzt und Sentiment aktiv managt, erhöht die Chancen, in Antwort‑Engines präsent zu sein und trotz Zero‑Click‑Effekten Präferenz aufzubauen.

Starten Sie mit einem schlanken Audit: Fragen/Quellen kartieren, Sentiment und Datenkonsistenz bewerten, Maßnahmen priorisieren. Oder, ganz pragmatisch gesagt: Sorgen Sie dafür, dass Ihre besten Antworten dort liegen, wo KI‑Systeme sie verlässlich finden – klar, sauber und belegbar.