12 Best Practices für LLM‑freundliche Listen (2025): Strukturieren, Chunking & AI Overviews

Entdecken Sie 12 Best Practices, um Listen 2025 optimal für LLMs & AI Overviews zu gestalten – mit strukturieren, Chunking, Schema und Messung. Jetzt anwenden!

Gute Listen können heute weit mehr als menschliche Leser:innen überzeugen: Sie sollten auch von LLMs zuverlässig geparst, zitiert und in Antworten aufgenommen werden – ob in Google AI Overviews, ChatGPT oder Perplexity. Dieser Leitfaden zeigt, wie Sie Ihre Listen so strukturieren, belegen und ausspielen, dass sie für Menschen und Maschinen gleichermaßen funktionieren. Alle Empfehlungen sind praxisnah, evidenzgebunden (2024–2025) und in vier Ebenen gegliedert: Struktur, Semantik/Chunking, Evidenz/Schema, Delivery/Messung.

A. Struktur & Formatierung

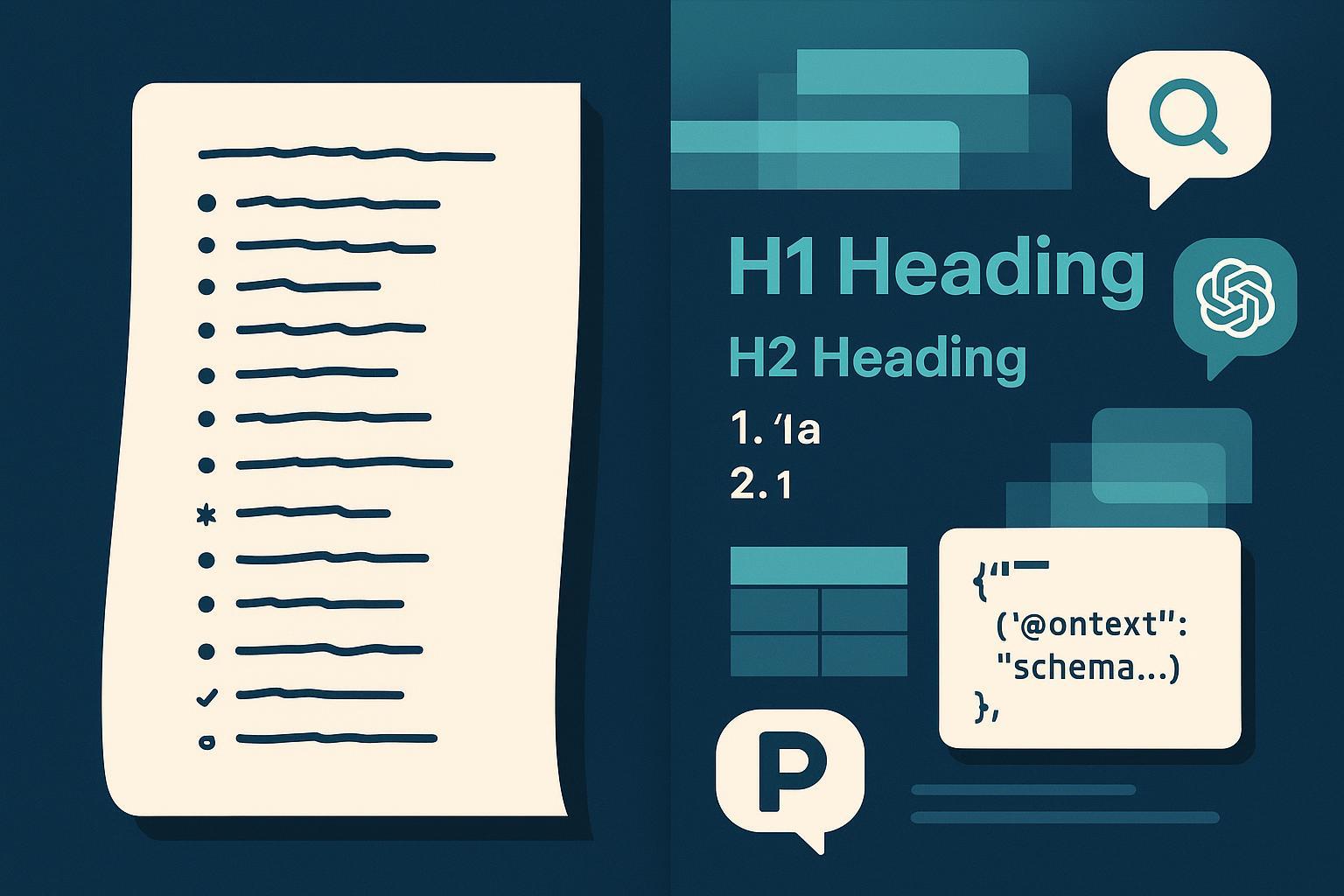

- Setzen Sie auf hierarchisches Markdown und kanonische Listen

- Warum es zählt (1‑Zeiler): LLMs folgen klaren, vorhersehbaren Strukturen. Überschriften (H1–H3), kurze Absätze, nummerierte und Bullet‑Listen erhöhen die Extrahierbarkeit.

- So umsetzen:

- H1 nur einmal, dann H2/H3 logisch staffeln.

- Paragraphen kurz halten (3–5 Sätze), pro Absatz 1 Kernaussage.

- Für Schritte nummerierte Listen; für Aufzählungen Bullets.

- Tabellen nur, wenn Spalten vergleichbar sind.

- Evidenz/Standards: Praktiken zur Ausgabestruktur werden in den Prompting‑Leitlinien des OpenAI Cookbook (2024/2025) betont; klare Formatvorgaben verbessern Modelladhärenz, inklusive Tabellen bei Bedarf, siehe die Hinweise zum „Output‑Format“ im OpenAI Cookbook Prompting‑Guide (2025) und die ergänzenden Beispiele im OpenAI Cookbook zu Evaluations mit Markdown‑Tabellen (2024).

- Pitfalls: Wiederholender Satzbau wirkt „spammig“. Tabellen mit unhomogenen Zellen behindern Vergleichbarkeit.

- Wann einsetzen/nicht: Immer für Guides, Checklisten, Tool‑Listen. Nicht erzwingen bei narrativen Essays.

- Normalisieren Sie „Item‑Cards“ mit konsistenten Feldern

- Warum es zählt: Wiederkehrende Felder (Titel, 1‑Zeiler, „Warum für LLMs“, Schritte, Evidenz, Pitfalls, Einsatzgrenzen) erleichtern Parsing und Zitierbarkeit.

- So umsetzen: Ein Redaktions‑Template definieren und in CMS‑Blöcken abbilden.

- Evidenz/Standards: Strukturierte, erwartbare Ausgaben werden von LLMs besser befolgt, vgl. Microsoft Learn – Azure OpenAI Prompting Best Practices (2025) und den OpenAI Cookbook Prompting‑Guide (2025).

- Pitfalls: Zu viele Felder blähen Content auf. Halten Sie es schlank.

- Einsatz: Produkt‑Vergleiche, Best‑Practice‑Sammlungen, FAQ‑Blöcke.

- Nutzen Sie Tabellen sparsam – mit konsistenten Spalten

- Warum es zählt: Tabellen sind extrahierbar, wenn Header eindeutig sind und Werte komparabel bleiben.

- So umsetzen: Einheitliche Spalten (z. B. „Use Case“, „Stärke“, „Grenzen“, „Kosten“). Zahlen/Einheiten standardisieren.

- Evidenz/Standards: Strukturierte Tabellenbeispiele in den Cookbook‑Artefakten zeigen die Vorteile klarer Spalten für LLMs, siehe OpenAI Cookbook Evaluations‑Beispiel (2024).

- Pitfalls: „Textwände“ in Zellen erschweren Ranking/Scoring durch Modelle.

- Einsatz: Vergleiche, Feature‑Matrizen, Monitoring‑Toolboxen.

B. Semantik & Chunking

- Chunken Sie semantisch – mit moderatem Overlap

- Warum es zählt: RAG‑Pipelines und Answer Engines profitieren von kohärenten Chunks; moderater Overlap reduziert Kontextabbrüche.

- So umsetzen:

- Startwerte: 500–1.000 Tokens pro Chunk; 10–20 % Overlap oder 50–200 Tokens als Brücke.

- Content‑aware Splitting (Sätze/Absätze) gegenüber starren Längen bevorzugen.

- Evidenz/Standards: Richtwerte und Strategien werden in Pinecone „Chunking Strategies“ (2024) erläutert; Defaults/Separatoren finden sich in LangChain Text‑Splitter‑Doku (2025) und den LlamaIndex Splitter‑Docs (2025).

- Pitfalls: Zero‑Overlap bei dichtem Fachtext begünstigt Abrisse; zu viel Overlap erhöht Kosten und Redundanz.

- Einsatz: Long‑form‑Guides, Doku‑Seiten, Wissensbasen.

- Verwenden Sie natürliche Delimiter – und bei Bedarf explizite Tags

- Warum es zählt: Saubere Trennstellen (H2/H3, Absätze) erhöhen semantische Kohärenz. Explizite „Chunk“-Tags helfen dort, wo CMS‑Strukturen fehlen.

- So umsetzen:

- Split nach Absätzen/Überschriften; sekundär nach Sätzen/Wörtern.

- Optional eigene Tags im Quelltext/CMS verwenden.

- Mini‑Snippet:

<!-- Beispiel: Explizite Chunk-Tags im CMS-HTML -->

<chunk id="best-practice-04" topic="chunking" intent="how-to">

<h3>Semantisches Chunking</h3>

<p>Richtwerte: 500–1.000 Tokens, 10–20 % Overlap …</p>

</chunk>

- Evidenz/Standards: Separator‑Reihenfolgen für sinnvolle Splits sind in LangChain‑Dokumentation (2025) beschrieben; Praxisleitlinien bei Pinecone.Pinecone „Chunking Strategies“ (2024)

- Pitfalls: HTML‑Kommentar‑Tags werden nicht überall persistiert; CMS‑Custom‑Fields sind oft robuster.

- Einsatz: Headless‑CMS, Entwicklernahe Teams.

- Injektion von Metadaten auf Chunk‑Ebene

- Warum es zählt: Titel, Entitäten und Intent je Chunk verbessern Retrieval, Re‑Ranking und Filterung.

- So umsetzen: Pro Chunk Metafelder pflegen (z. B. section_title, entities, intent, updated_at) – in Indizes/Embeddings mitschreiben.

- Evidenz/Standards: RAG‑Framework‑Praxis stützt Metafelder; siehe LlamaIndex Splitter‑Docs (2025) und Pinecone‑Leitfaden (2024).

- Pitfalls: Inkonsistente Taxonomie erzeugt Drift. Governance definieren.

- Einsatz: Wissensdatenbanken, Doku‑Portale, Enterprise‑Search.

C. Evidenz, Schema & Compliance

- Binden Sie Claims an belastbare Quellen – mit aussagekräftigen Ankertexten

- Warum es zählt: E‑E‑A‑T stärkt Vertrauen; Answer Engines bevorzugen zitierfähige, belegte Aussagen.

- So umsetzen: Statistiken/Definitionen direkt im Satz verlinken; Originalquellen bevorzugen; Jahr und Herausgeber nennen.

- Evidenz/Standards: Google rät zu „helpful, reliable, people‑first content“, das Vertrauen schafft, vgl. Google Search Central Leitfaden „Creating helpful, reliable, people‑first content“ (laufend aktualisiert). Zur Einordnung des Umfelds mit AI Overviews siehe die Google‑Ankündigung zu generativer Suche (Mai 2024) sowie Hinweise zu Funktionsprinzipien wie „query fan‑out“ in den AI‑Features‑Docs von Google (2024/2025).

- Pitfalls: Sekundärblogs statt Primärquellen; „hier“-Links ohne Kontext.

- Einsatz: Studien, Behörden/Normen, Hersteller‑Doku.

- Ergänzen Sie passendes schema.org‑Markup (ItemList/FAQ/QAPage)

- Warum es zählt: Strukturierte Daten erhöhen Maschinenverständnis; Sichtbarkeit von Rich Results ist kontextabhängig.

- So umsetzen: ItemList für Listen, FAQPage/QAPage für Q&A‑Formate; mit dem Rich‑Results‑Test validieren.

- Snippets:

<!-- FAQPage (eingeschränkte Rich-Results seit 2023, trotzdem nützlich fürs Verständnis) -->

<script type="application/ld+json">

{

"@context": "https://schema.org",

"@type": "FAQPage",

"mainEntity": [{

"@type": "Question",

"name": "Was ist schema.org?",

"acceptedAnswer": {"@type": "Answer", "text": "Schema.org ist ein Vokabular …"}

}]

}

</script>

<!-- ItemList für Listenartikel -->

<script type="application/ld+json">

{

"@context": "https://schema.org",

"@type": "ItemList",

"itemListElement": [

{"@type": "ListItem", "position": 1, "url": "https://example.com/item-1"},

{"@type": "ListItem", "position": 2, "url": "https://example.com/item-2"}

]

}

</script>

- Evidenz/Standards: Offizielle Hinweise in der Google‑Doku zu strukturierten Daten und der Search Gallery (laufend) sowie der schema.org‑Referenz für ItemList. Beachten Sie: Google hat die Sichtbarkeit von FAQ‑Rich‑Results seit 2023 stark reduziert, siehe Google Search Central Blog „How‑to/FAQ‑Changes“ (Aug. 2023) und die QAPage‑Richtlinien (DE, laufend).

- Pitfalls: Markup passt nicht zum sichtbaren Inhalt; Validierung vergessen.

- Einsatz: Listen, Help‑Center, Community‑Q&A.

- YMYL‑Vorsicht und E‑E‑A‑T‑Hygiene beachten

- Warum es zählt: In sensiblen Kategorien (Finanzen, Gesundheit) ist die Beleg‑ und Review‑Hürde höher; falsche Sicherheitssignale schaden.

- So umsetzen: Expert:innen‑Review, Datumsstempel, klare Haftungsausschlüsse und Quellenangaben. Keine aggressiven CTAs in YMYL‑Kontexten.

- Evidenz/Standards: Googles people‑first‑Leitlinien sind die Basis, vgl. Google Search Central – Creating helpful, reliable, people‑first content (laufend) und die verschärften Spam‑Policies im März‑2024‑Core‑Update (Google Developers Blog, 2024).

- Pitfalls: Autorenschaft unklar, fehlende medizinische/finanzielle Expertise.

- Einsatz: Branchen mit regulatorischer Relevanz.

D. Delivery, Messung & Ops

- Optimieren Sie für AI Overviews und Answer Engines – ohne „Tricks“

- Warum es zählt: Google nennt keine Sonder‑SEO für AI Overviews; konsistente Qualität, Aktualität und Mehr‑Perspektiven erhöhen Chancen, als Quelle ausgewählt zu werden.

- So umsetzen: Fragen ganzheitlich beantworten, konkurrierende Perspektiven erwähnen, Belege verlinken, Daten aktualisieren.

- Evidenz/Standards: Googles öffentliche Kommunikation betont people‑first‑Inhalte und die Rolle von Quellenvielfalt; siehe Google Blog zur generativen Suche (Mai 2024) und Hinweise zu „AI features“ inklusive „query fan‑out“ in der Search‑Doku (2024/2025). Branchenanalysen zeigen Variabilität in Prävalenz/CTR, siehe die Übersichten von BrightEdge/SEJ 2024–2025 und seoClarity‑Research (2024/2025).

- Pitfalls: „AI Overview‑SEO“ mit Keyword‑Stuffing oder redundanten PAA‑Farmen – solche Muster laufen Gefahr, von Spam‑Policies betroffen zu sein, vgl. Google Core Update & Spam‑Policies (März 2024).

- Einsatz: Themenseiten, Erklärartikel, How‑tos.

- Tracken Sie LLM‑Pickup und iterieren Sie gezielt

- Warum es zählt: Ohne Monitoring bleibt unklar, ob Listen in AI Overviews/Answer Engines erscheinen, wie oft sie zitiert werden und wie sich die Tonalität entwickelt.

- So umsetzen:

- KPI‑Set: Anteil Queries mit AI Overviews, Zitathäufigkeit Ihrer Domain, Position/Prominenz, Tonalität, Historie.

- Cadence: Wöchentlich Stichproben checken; quartalsweise umfangreiche Audits; nach Updates gezielt re‑validieren.

- Toolbox (Auswahl; je nach Bedarf):

| Tool/Ansatz | Stärken | Grenzen | Am besten geeignet für |

|---|---|---|---|

| Geneo | Monitoring über ChatGPT, Perplexity und Google AI Overviews; Sentiment; Historie; Multi‑Brand/Team | Erfordert Ziel‑Query‑Set und laufende Pflege | Marken/Teams, die AI‑Sichtbarkeit zentral steuern |

| Advanced Web Ranking (AWR) Studien/Tracking | Aggregierte Studien und Tracking‑Funktionalität für AI Overviews | Nicht alle Märkte/Queries; eher Forschungs‑/Trendfokus | Marktforschung, Trendbeobachtung |

| seoClarity/BrightEdge (Enterprise) | Suite‑Reports zu AI Search Visibility, Workflows, Dashboards | Enterprise‑Lizenz, Implementierungsaufwand | Große Unternehmen mit SEO‑Data‑Ops |

| Manuelle Checks + GSC | Flexibel, kostengünstig; GSC für indirekte CTR/Impressions | Zeitintensiv; AI‑Overviews nicht direkt in GSC messbar | Proof‑of‑Concepts, kleine Teams |

Erste verlinkte Nennung und Offenlegung: Geneo. Offenlegung: Geneo ist unser Produkt.

- Evidenz/Standards: Methodiken und Analysen finden sich in den AWR‑Publikationen zu AI Overviews (2024/2025), z. B. der Advanced Web Ranking AI Overviews Study (laufend), sowie in den Forschungsseiten von seoClarity zu AI Overviews (2024/2025) und ergänzenden Branchenberichten bei SEJ/BrightEdge (2024/2025).

- Pitfalls: Volatilität nach Updates; Messungen stets datieren, Stichproben dokumentieren, Bias beachten.

- Einsatz: Kontinuierliche Optimierung von Evergreen‑Listen und Hub‑Seiten.

- Etablieren Sie eine wiederholbare Publishing‑Checkliste

- Warum es zählt: Konsistenz senkt Fehlerrisiken und erhöht die Chance auf LLM‑Aufnahme.

- So umsetzen (Kurz‑Checkliste):

- Struktur: H1–H3 sauber, Absätze kurz, Listen korrekt, Tabellen konsistent.

- Item‑Cards: Felder vollständig, Ton klar, Redundanz minimiert.

- Evidenz: Primärquellen mit Ankertext, Jahr/Publisher genannt; Linkdichte moderat.

- Schema: ItemList/FAQ/QAPage passend; Rich‑Results‑Test bestanden; sichtbarer Content ↔ Markup deckungsgleich.

- Chunking: 500–1.000 Tokens, 10–20 % Overlap; Delimiter sauber; Metadaten je Chunk gepflegt.

- Delivery: Fragen vollständig beantworten, Mehr‑Perspektiven, Aktualität sichern.

- Monitoring: Query‑Set, Baseline, wöchentliche Checks, Quartals‑Audits; Änderungen protokollieren.

- Evidenz/Standards: Grundprinzipien folgen Googles people‑first‑Leitlinien und RAG‑Praxis; siehe Google Search Central „Creating helpful…“ (laufend) und Pinecone „Chunking Strategies“ (2024).

Häufige Stolpersteine (und wie Sie sie vermeiden)

- Gleichförmige, redundante Listeneinträge: Arbeiten Sie mit konsistenten Feldern, aber variieren Sie Sprache und Beispiele.

- Überoptimierte Tabellen: Weniger Spalten, klarere Werte → höhere Nutzbarkeit.

- „One‑size“‑Chunking: Startwerte nutzen und an Texttyp/Antwortstil anpassen; Metriken beobachten.

- Zitate ohne Quellen: Jede Zahl/Definition mit Primärquelle und Jahr verankern.

- Markup ohne Sichtbarkeit: schema.org nur einsetzen, wenn Inhalt dazu passt – und validieren.

Kurzer Methodenblock und Transparenz zu Auswahlkriterien

- Auswahlkriterien der 12 Praktiken: LLM‑Parsebarkeit (30 %), Retrieval‑Wirkung (25 %), Evidenzstärke (20 %), redaktionelle Umsetzbarkeit (15 %), Wartungsaufwand (10 %).

- Quellenbasis: Google Search Central/Blog (AI Features, Helpful Content, Spam‑Policies 2024), OpenAI/Azure Prompting‑Guides (2024/2025), Pinecone/LangChain/LlamaIndex (Chunking), AWR/seoClarity/BrightEdge (Messung/Prävalenz 2024–2025), schema.org‑/Google‑Markup‑Doku (laufend).

Weiterführende, zitierwürdige Ressourcen

- Überblick zu people‑first Content: Google Search Central Leitfaden (laufend)

- AI Overviews einordnen: Google Blog zur generativen Suche (Mai 2024) und Google AI‑Features‑Doku mit „query fan‑out“ (2024/2025)

- Chunking‑Praxis: Pinecone Leitfaden (2024), LangChain Splitter‑Doku (2025), LlamaIndex Token‑Splitter (2025)

- Prompt‑Strukturierung: OpenAI Cookbook Prompting‑Guide (2025), Azure OpenAI Best Practices (2025)

- Markup‑Grundlagen: Google Search Gallery/Structured Data (laufend), schema.org ItemList, FAQ‑Änderungen 2023

Zum Mitnehmen: LLM‑freundliche Listen sind kein Kunststück, sondern Handwerk. Wer Struktur konsequent durchzieht, semantisch chunked, Aussagen sauber belegt, passendes Markup pflegt und die eigene Sichtbarkeit in Answer Engines misst, wird häufiger und verlässlicher zitiert – und liefert Leser:innen gleichzeitig klare, nützliche Inhalte.