KI-Zusammenfassungen mit Marken-Kontext: Best Practices 2025

Erfahren Sie praxisnahe Best Practices, wie KI-Zusammenfassungen durch Marken-Kontext optimiert werden. Ideal für Marketing und Brand-Profis. Technisch fundiert, mit Workflow und KPIs.

KI kann Inhalte blitzschnell verdichten – doch ohne Marken‑Kontext klingen Zusammenfassungen beliebig, verfehlen Tonalität und lassen Proof‑Points unter den Tisch fallen. Das kostet Vertrauen, Klicks und Conversion. Die gute Nachricht: Mit sauber aufbereitetem Brand‑Kontext und einem klaren Workflow lassen sich Antworten aus ChatGPT, Perplexity oder Google AI Overviews deutlich markenkonformer, faktenfester und nützlicher machen. Kurz gesagt: Sie füttern die Modelle mit dem, was Ihre Marke unverwechselbar macht – und sichern dies per Governance und Metriken ab.

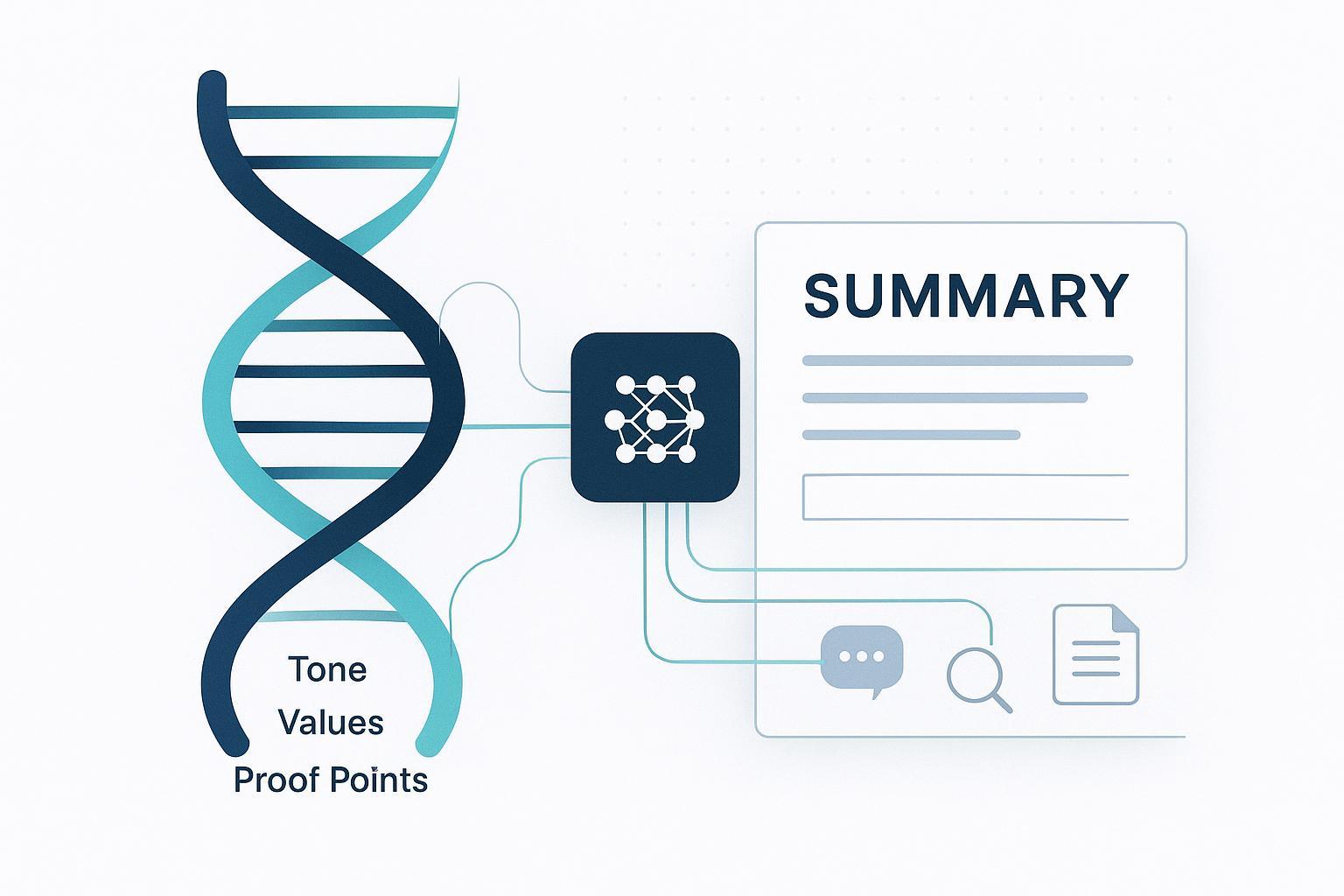

1. Marken‑Kontext präzise definieren

Unter Marken‑Kontext verstehen wir die strukturierte Summe Ihrer Brand DNA: Werte, Nutzenversprechen, Differenzierungsmerkmale, Tonalität und Sprachstil, Belege (Kundenstimmen, Zertifizierungen, Zahlen), Produktarchitektur, sowie No‑Gos (z. B. Begriffe, die nicht verwendet werden sollen). LLMs generalisieren von Natur aus; ohne expliziten Kontext tendieren sie zu Einheitsstil und vereinfachten Aussagen. Je präziser und maschinenlesbar Sie Ihren Kontext bereitstellen, desto konsistenter werden KI‑Summaries.

Praktische Faustregeln: Kontext muss aktuell, überprüft und zentral gepflegt sein (Versionierung, Verantwortliche, Änderungslog). Beschreiben Sie Stil und Ton konkret („präzise, sachlich, keine Superlative; bevorzugt aktive Verben; Fachbegriffe A/B erlaubt“), nicht nur als Adjektivliste. Proof‑Points gehören in klaren, zitierfähigen Formaten (Kennzahlen mit Quelle/Datum, kurze Case‑Snippets). Warum das wichtig ist? Weil der Markenkern sonst in der Verdichtung verloren geht. Und weil falsche oder veraltete Belege das Risiko von Halluzinationen erhöhen.

2. Technische Wege, Brand‑Kontext in KI‑Summaries zu bringen

Nachfolgend eine kompakte Übersicht, wie Sie Ihren Markenkontext praktisch in den Summarization‑Flow einspeisen können. Jede Methode hat Stärken und Grenzen – oft ist ein hybrider Ansatz sinnvoll.

| Methode | Was es ist | Stärken | Grenzen | Geeignet für |

|---|---|---|---|---|

| Prompt‑Pakete (System/Inline) | Vordefinierte Rollen-/Stilprompts plus Markenregeln | Schnell implementiert; flexibel; keine Infrastruktur nötig | Flüchtig; kontextlängengebunden; schwer skalierbar | Pilots, kleine Teams, schnelle Tests |

| RAG (Retrieval‑Augmented Generation) | Externe Wissensbasis (Brand‑Guide, Cases) wird vor Antwort abgerufen | Aktuell, überprüfbar; Quellenzitate möglich; skaliert sauber | Erfordert Content‑Kuratierung, Embeddings, Vektor‑Suche | Reife Workflows, Compliance, große Korpora |

| Fine‑Tuning/Adapter | Modell lernt Stil/Strukturen auf Marken‑Daten | Sehr konsistent im Stil; geringer Prompt‑Overhead | Datenmenge/Qualität kritisch; Pflegeaufwand; Kosten | Hohe Volumina, stabile Domains |

| Schema/Markup (Web) | strukturierte Daten, E‑E‑A‑T‑Signale für KI‑Crawls | Bessere Erfassung für AI Overviews; klare Entitäten | Indirekt; keine Garantie auf Zusammenfassungs‑Übernahme | Owned Media, SEO/GEO Initiativen |

| API/Connectors | Orchestrierung zwischen CMS, DAM, CRM und LLMs | Automatisierung, Governance, Logs, Messbarkeit | Integrationsaufwand, Dev‑Ressourcen nötig | Skalierte Content‑Pipelines |

Zwei Beobachtungen aus dem Marktumfeld: Publisher betonen, dass Vertrauen und klare Datenführung den Ausschlag geben, wenn KI Zusammenfassungen generiert – dazu gehören überprüfbare Quellen und konsistente Markenstimme, wie in Retrescos Beitrag für Verlage erläutert wurde (Deutschland, 2024) in der Analyse „AI Summaries in Google Discover“: siehe die Einschätzungen und Beispiele in Retrescos Überblick zu AI Summaries für Publisher (2024). Und im SEO‑Umfeld formiert sich eine eigene Disziplin für generative Oberflächen: Die Praxisleitfäden zur Generative Engine Optimization zeigen, wie Markeninhalte strukturiert werden müssen, damit sie in KI‑Antworten präsent und korrekt dargestellt sind; eine deutschsprachige Einordnung bietet die Einführung in Generative Engine Optimization von SEO‑Küche (2024).

3. Vom Rohtext zur markenkonformen Summary: Referenz‑Workflow

Denken Sie in Phasen – von der Erfassung bis zur Freigabe. Ein bewährtes Muster sieht so aus: Roh‑Summary erzeugen (neutrale Erstfassung), dann Kontext‑Injection (Stil‑/Markenregeln per Prompt oder RAG), anschließend Stil‑ und Fakten‑Check (Guardrails, Quellenabgleich), Human‑in‑the‑Loop‑Review und finale Freigabe samt Versionierung.

Guardrails, die sich bewährt haben: definierte Terminologie‑Listen, Negativlisten, Mindestanzahl belastbarer Belege pro Summary, klare Längen‑ und Stilgrenzen, plus ein „Abbruch bei Unsicherheit“ mit Hand‑Off an die Redaktion.

Praxisbeispiel (Offenlegung): Geneo ist eine Plattform für AI‑Suchsichtbarkeit und Marken‑Monitoring. In einem Workflow kann Geneo genutzt werden, um markenrelevante Queries auf Chat‑/Search‑Oberflächen zu überwachen, die Tonalität der Antworten zu bewerten und Lücken bei Proof‑Points zu identifizieren. Diese Insights speisen Sie dann zurück in Ihre RAG‑Basis oder Prompt‑Bibliothek, sodass künftige Summaries Ihre Kernbelege zuverlässiger aufgreifen. Hinweis: Dies ist ein Anwendungsbeispiel, kein Leistungsversprechen.

4. Schritt‑für‑Schritt Implementierung

Phase A – Dateninventur und Kuratierung. Sammeln Sie Brand‑Guide, Messaging‑Matrix, Produktblätter, Zertifikate, Case‑Studies, FAQs, Terminologie und verbotene Claims. Strukturieren Sie alles in modulare, wiederverwendbare Einheiten (Mission, Elevator Pitch, Produkt‑Benefits, Metriken mit Quelle/Datum). Normalisieren Sie Begriffe und Aktualität; machen Sie Inhalte maschinenlesbar (Markdown/JSON, vektorisiert, IDs, Versionen).

Phase B – Prompt‑Vorlagen und Stilbibliothek. Definieren Sie System‑Prompts (Stimme, Ton, No‑Gos, Zitierregeln, Zielgruppen‑Nuancen), Task‑Prompts (Ziel, Länge, Format) und Evaluations‑Prompts (Checkfragen für Tonalität, Proof‑Points, Faktenlage).

Phase C – Evaluations‑Set und Redaktionsprozess. Bauen Sie ein Gold‑Standard‑Set mit 20–50 repräsentativen Texten und idealen, markenkonformen Summaries. Automatisieren Sie Scoring (Stil‑Kohärenz, Terminologie‑Trefferquote, Quellenabdeckung, Lesbarkeit). Legen Sie im Redaktions‑Playbook fest, wann Menschen eingreifen, wie Änderungen dokumentiert werden und wie Unsicherheit behandelt wird.

Phase D – Orchestrierung & Rollout. Integrieren Sie CMS/DAM/CRM; aktivieren Sie Logs und Telemetrie; definieren Sie Rechte & Rollen. Standardisieren Sie Summary‑Typen als wiederverwendbare Jobs und Guardrails als Policies; schulen Sie Redaktion, Brand und Legal auf gemeinsame Standards.

5. Qualitätssicherung, KPIs und Risiken

Eine gute KI‑Summary ist korrekt, ausreichend vollständig, markenkonform und nützlich für die Zielgruppe. Messen Sie deshalb: Marken‑Kohärenz (Stil/Terminologie), Faktentreue (Quellen, Zahlen, Daten), Proof‑Point‑Abdeckung (Mindestzahl verifizierter Belege), Sentiment/Brand‑Tone (klingt es „wie Sie“?) sowie Output‑Performance in Ihren Kanälen (Klick‑/Interaktionsraten). Zur Marktverortung liefern deutschsprachige Analysen hilfreiche Perspektiven – taktisch etwa die „7 Tipps für mehr Sichtbarkeit im Google AI Overview“ von neustadt.swiss (2024) und strategisch die Einordnung „Kontext statt Klicks“ der absatzwirtschaft (2024). Beide zusammen zeigen: Struktur/Entitäten sichern Sichtbarkeit; konsequenter Marken‑Kontext sorgt für die richtige Stimme.

Typische Risiken mit Gegenmaßnahmen lassen sich kompakt zusammenfassen: Gegen veraltete Belege helfen strikte Versionsführung und automatische Aktualitäts‑Checks. Halluzinationen begegnen Sie mit harten Zitierregeln, Confidence‑Signalen und definierten Abbruchbedingungen. Gegen Stildrift wirken regelmäßige Re‑Evaluations gegen Ihr Gold‑Set plus dokumentierte Prompt‑/Modell‑Updates. Und Bias/Compliance steuern Sie über Fairness‑Checks, juristische Freigaben bei Claims und nachvollziehbare Herleitungen.

6. Projekt‑Blueprint für 8–12 Wochen

Phase 1 – Discovery (2–3 Wochen): Ziele, Kanäle und Summary‑Typen definieren; Dateninventur starten; KPI‑Set festlegen; Risiken/Policies klären.

Phase 2 – Pilot (3–4 Wochen): RAG/Prompting implementieren; Gold‑Set erstellen; Guardrails aktivieren; 3–5 Summary‑Typen testen; Scoring & Redaktion im Loop.

Phase 3 – Rollout (3–5 Wochen): Orchestrierung in CMS/DAM/CRM; Schulung & Governance; Dashboarding; kontinuierliche Optimierung und Varianten‑Tests.

Rollen im Überblick: Brand/Kommunikation verantwortet Tonalität und Terminologie, Redaktion kuratiert und finalisiert, Data/Engineering baut Retrieval, Orchestrierung und Telemetrie, Legal prüft Claims. Ohne klare Zuständigkeiten verliert sich das Projekt im Kleinklein – und die Marke zahlt die Zeche.

Schlussabschnitt

Wenn KI verdichtet, entscheidet Kontext über Qualität. Wer Brand‑Kontext sauber definiert, maschinenlesbar verfügbar macht und ihn systematisch in den Summarization‑Flow injiziert, bekommt Antworten, die fachlich stimmen und zur Marke passen. Der Weg dahin ist kein Hexenwerk: strukturierte Daten, robuste Guardrails, ein diszipliniertes Review‑System – und klare KPIs, die Fortschritt sichtbar machen.

Hier ist der Deal: Starten Sie klein, aber sauber – mit einem Pilot, einem Gold‑Set und einer klaren Stilbibliothek. Skalieren Sie erst, wenn die Qualitätsmetriken stabil sind. Und behalten Sie den Markenkern als Nordstern, damit jede KI‑Summary klingt, als käme sie aus Ihrem Team.