KI-Suchalgorithmus-Updates 2025: Monitoring & schnelle Adaption – Best Practices für Profis

Führende Best Practices 2025 für Monitoring, Adaption und KPI-Messung bei KI-Suchalgorithmus-Updates. Multi-Plattform-Brand-Monitoring, Sentiment-Analyse & Geneo-Integration für Experten.

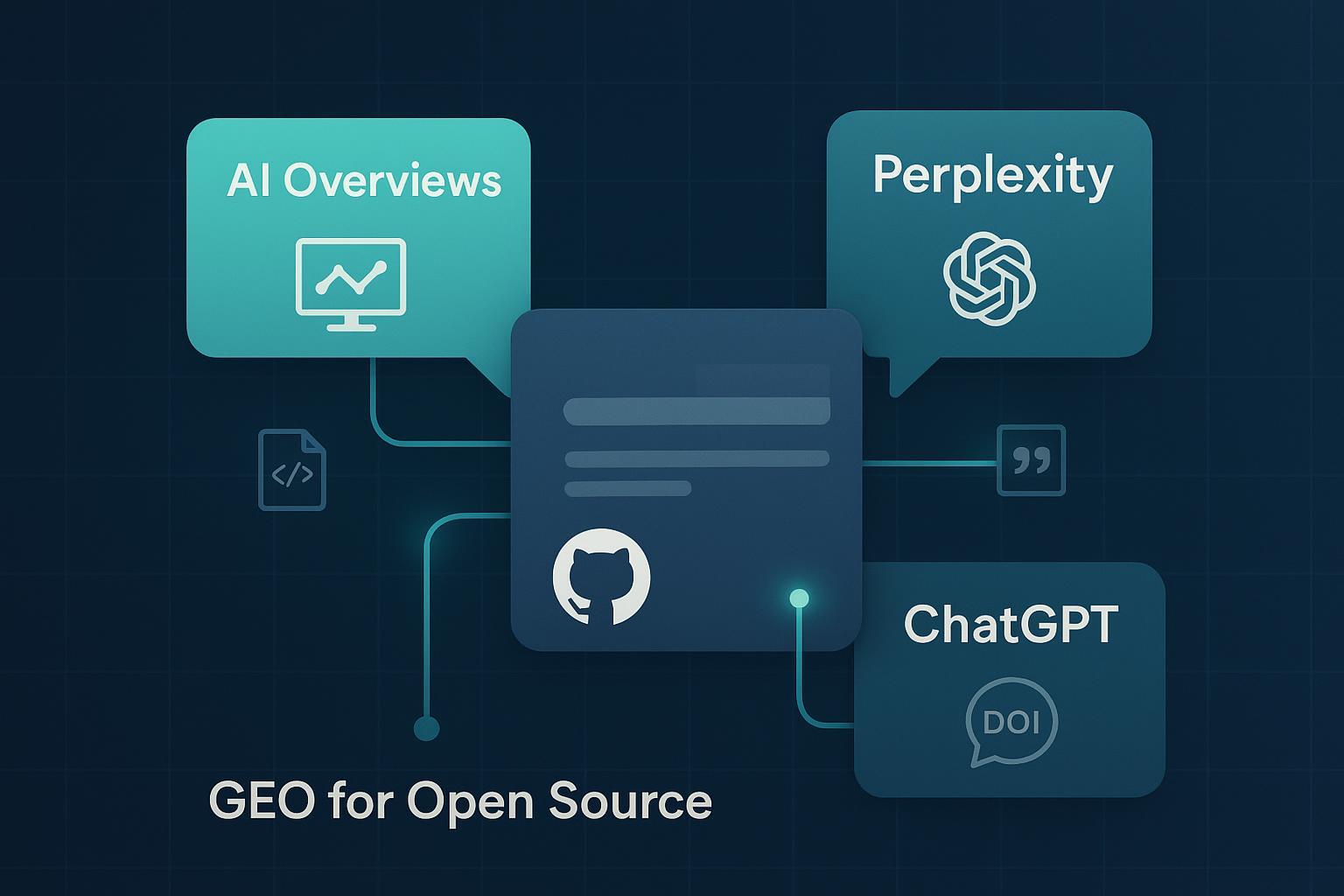

Wenn KI-Suchsysteme wie Google AI Overviews, ChatGPT, Perplexity, Copilot/Bing und Gemini ihre Mechaniken anpassen, verschiebt sich Sichtbarkeit oft über Nacht. Aus der Praxis lautet die einzig nachhaltige Antwort: kontinuierliches, plattformübergreifendes Monitoring mit klaren Reaktions-SLAs – und ein Team-Setup, das Änderungen in Stunden statt Wochen operationalisiert.

Worauf ich mich stütze:

- Google hat 2025 die Reichweite der KI-Funktionen deutlich ausgebaut; AI Overviews werden laut den Google I/O 2025 Ankündigungen (Google, 2025) global skaliert und mit Gemini-2.5-Fähigkeiten weiterentwickelt.

- OpenAI verlagert Such- und Rechercheverhalten mit Agentenfunktionen; „Deep Research“ ermöglicht laut Introducing Deep Research (OpenAI, 2025) mehrstufige Web-Analysen und Synthesen.

- Plattformen unterscheiden sich stark in Zitierlogik und Transparenz: Perplexity positioniert sich bewusst mit sichtbaren Quellenangaben, siehe Getting Started (Perplexity, laufend aktualisiert), während OpenAI-Release Notes keine festen Regeln garantieren, vgl. ChatGPT Release Notes (OpenAI, 2024–2025). Für unternehmensinterne RAG-Setups zeigt Microsofts Doku, wie sich Quellensteuerung implementieren lässt, siehe Use your data (Microsoft Azure OpenAI, 2025).

Diese Unterschiede bedingen ein GEO-Setup (Generative Engine Optimization), das Monitoring, Diagnose und schnelle Anpassung als wiederholbaren Prozess verankert. Unten zeige ich ein praxisbewährtes Framework, inkl. KPI-Set, Incident-SOP und Geneo-Integration.

1) Warum Multiplattform-Monitoring heute unverhandelbar ist

- KI-Module verändern Klickpfade. Gerade Zero-Click- und Conversational-Interfaces verlagern Aufmerksamkeit. Marktberichte belegen die Dynamik der Suchumgebung; so dokumentiert Search Engine Land für Q4 2024 veränderte Budget- und Klicktrends im Google-Umfeld (Ads), was den Wettbewerbsdruck indirekt erhöht, siehe Tinuiti Benchmark Coverage (Search Engine Land, 2024).

- Zitationswettbewerb entscheidet über Präsenz in Antworten. Wer in den begrenzten Quellen-Slots der KI-Antworten erscheint, prägt Wahrnehmung und Nachfrage – unabhängig vom klassischen SERP-Ranking.

- Fehl- oder Unterlassungsinformationen sind Marktrisiko. Gerade bei YMYL-Themen oder erklärungsbedürftigen Produkten ist Brand Safety ohne Sentiment- und Faktenmonitoring kaum gewährleistet.

Praktischer Schluss: Sichtbarkeit muss dort gemessen werden, wo Nutzer Antworten konsumieren – über alle relevanten KI-Plattformen hinweg.

2) Was genau monitoren? Ein präziser Messplan

Definieren Sie ein stabil gepflegtes Query-Set und messen Sie für jede Plattform folgende Dimensionen:

- Antwortpräsenz: Erscheint eine KI-Antwort für die Query? Wenn ja, in welcher Ausprägung (Kurz- vs. Langform, Follow-up-Empfehlungen)?

- Citation Share: Wird Ihre Marke/Domain zitiert oder verlinkt? Wie viele Quellen-Slots sind verfügbar, welche Domains dominieren?

- Prominenz: Wie sichtbar ist die Erwähnung (oben/unten, expandiert/zugeklappt, visuelle Hervorhebung)?

- Sentiment/Framing: Welche Tonalität und welches Framing prägen die Antwort hinsichtlich Ihrer Marke/Produktkategorie?

- Konsistenz: Stimmen Fakten (Preise, Features, Verfügbarkeit) und Kernaussagen mit Ihrer aktuellen Positionierung überein?

Empfohlene Frequenz:

- Täglich: Top-50–100 Queries je Marke (Brand- und Non-Brand Core-Cluster)

- Wöchentlich: Longtail-Cluster, Wettbewerbervergleiche

- Ad hoc: Bei Volatilitätsspitzen oder Alerts

3) Platform-Nuancen: Worauf Teams realistisch achten sollten

- Google AI Overviews: 2025 breiter ausgerollt; genaue Einblendungs-/Zitationslogik ist nicht vollständig dokumentiert. Daher sind Musterbeobachtung und historische Vergleiche entscheidend, vgl. Google I/O 2025 Ankündigungen (Google, 2025).

- ChatGPT (inkl. Deep Research): Fokus auf mehrstufiger Quellenauswertung – Links können variieren, feste Anzeige-Standards sind nicht garantiert; Orientierung über ChatGPT Release Notes (OpenAI, 2024–2025) und Deep Research Ankündigung (OpenAI, 2025).

- Perplexity: Quellenangaben sind sichtbar und daher gut für Citation-Analysen geeignet, siehe Getting Started (Perplexity, laufend aktualisiert).

- Copilot/Bing und Enterprise-RAG: Für unternehmensnahe Experiences lassen sich Quellen kuratieren und verlinken, siehe Use your data (Microsoft Azure OpenAI, 2025).

- Branchen-Tools: Einige SEO-Suiten haben 2024/25 KI-Feature-Tracking ergänzt; Semrush fasst relevante Produkt-Updates zusammen, siehe Semrush Updates (2024). Nutzen Sie solche Sensoren als Ergänzung, nicht als Ersatz für plattformspezifisches Monitoring.

Trade-off: Tiefe (qualitative Stichproben) versus Breite (Skalierung über viele Queries/Plattformen). Ein hybrides Setup – automatisiert messen, manuell validieren – funktioniert erfahrungsgemäß am besten.

4) Das Monitoring-Setup: So setzen Sie es in 7 Schritten auf

- Query-Inventory bauen

- Cluster nach Intent (Informations-, Transaktions-, Navigations- und Wettbewerbs-Intents) und nach Geschäftswert priorisieren.

- Pro Cluster klare Owner definieren.

- Plattformen festlegen

- Google (klassisch + AI Overviews), ChatGPT/Deep Research, Perplexity, Copilot/Bing, Gemini.

- Für jede Plattform festhalten: Datenerhebungsmethode, Sampling-Regeln, Prüfintervalle.

- Messschema standardisieren

- Einheitliche Felder: Antwort vorhanden (Ja/Nein), Quellen-Slots, eigene Domain/Marke zitiert (Ja/Nein), Prominenz-Level, Sentiment (-1 bis +1), Faktenkonsistenz (Ja/Nein), Notizen.

- Schwellenwerte und Alerts definieren

- Beispiele: -30% Citation Share in Top-20 Queries binnen 24 h; neues negatives Sentiment (<-0,3) in Antworten zu „Produkt X“; Verlust aller Erwähnungen in einem Kern-Cluster.

- Historisierung und Vergleich

- Vor-/Nach-Vergleiche nach Maßnahmen (Content-Update, PR, technische Korrektur) und nach beobachteten Plattformänderungen.

- Governance verankern

- Rollen: Monitoring Lead (täglich), Content Lead (Hotfixes), Technical SEO (Schema/Indexierung), PR/Comms (Korrektur-PR), Analytics (Attribution), Legal (Brand Safety).

- SLA: Erstreaktion <4 Stunden; Hotfix <48 Stunden; Ursachenanalyse + Maßnahmenplan innerhalb 72 Stunden.

- Reporting und Review

- Wöchentlicher Review mit Trendgrafiken (AI Visibility Rate, Citation Share, Sentiment Score) und Maßnahmenstatus.

- Quartalsweise ROI-Review (siehe Abschnitt 6).

5) Schnelle Adaption: Playbooks, die in der Praxis tragen

Wenn Alerts ausgelöst werden, gehen Sie strukturiert vor. Ein bewährtes Playbook:

-

Triaging (0–4 Std.)

- Umfang prüfen: plattformweit, clusterweit oder Einzelfälle?

- Change-Log abgleichen (eigene Releases, bekannte Plattformänderungen, z. B. laut Google-/OpenAI-Updates 2024–2025).

-

Hypothesenbildung (bis 24 Std.)

- Content-Freshness: Fehlen Datumsangaben, aktuelle Zahlen, prägnante Fact-Boxen?

- Quellenmix: Dominieren Drittquellen (Wikipedia, Verbände, Medien) – fehlen eigene zitierfähige Primärquellen?

- Technik: Strukturierte Daten (FAQ, HowTo, Organization) aktuell? Indexierung stabil? Robots/Canonicals korrekt?

- Reputation: Negatives Sentiment oder Fehlinformationen in Antworten?

-

Hotfixes (24–48 Std.)

- Content: Aktualisierte, zitierfähige Abschnitte (mit klaren Zahlen/Definitionen, Datumsstempel), FAQ-Erweiterungen, präzise Produkt-/Preisinformationen.

- E-E-A-T-Signale: Autorenprofile, Referenzen, Verlinkungen zu Primärstudien/Offiziellen Docs.

- Technik: Schema-Updates, interne Verlinkung, schnelle Indexierung (z. B. Aktualitätssignale).

- Korrektur-PR: Kurzstatement auf Website/LinkedIn/PR-Newsroom, um KI-Systemen konsistente Fakten zu bieten.

-

Offpage-/Quellenarbeit (1–2 Wochen)

- Outreach an häufig zitierte Sekundärquellen (Wikipedia, Branchenverbände, öffentliche Doku-Seiten), Bereitstellung geprüfter Primärquellen (Whitepaper, Data Pages, Demos).

-

Review (7/14/28 Tage)

- Wirkung messen: AI Visibility Rate, Citation Share, Sentiment.

- Maßnahmen nachschärfen oder skalieren.

Hinweis zur Realität: Die genaue Einblendungs-/Zitationslogik der Plattformen ist teils nicht öffentlich dokumentiert (insb. Google AI Overviews). Deshalb ist Musterbeobachtung über Zeitreihen und qualitative Validierung zentral, siehe erneut Google I/O 2025 Ankündigungen (Google, 2025).

6) KPI- und ROI-Framework für AI Visibility

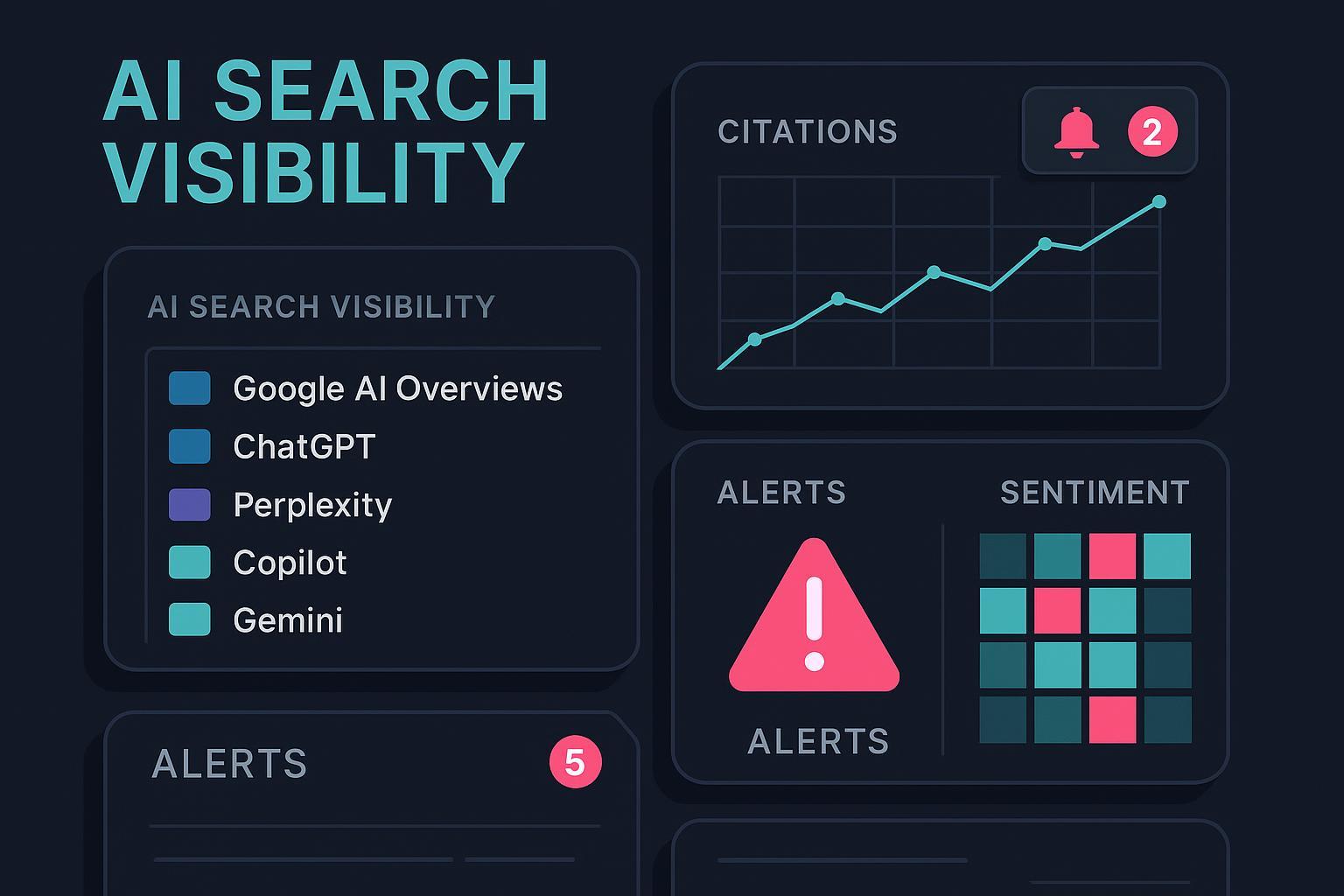

- AI Visibility Rate: Anteil der Queries mit KI-Antwort, in der Ihre Marke/Domain genannt oder verlinkt ist.

- Citation Share: Anteil Ihrer Quellen-Slots versus Wettbewerber in KI-Antworten, je Plattform/Cluster.

- Sentiment Score: Tonalitätsindex (z. B. -1 bis +1) je Query-Cluster/Plattform.

- Traffic-Proxies: Veränderungen bei Brand Search Volume, Direktzugriffen und Navigationsanfragen um Sichtbarkeitsereignisse herum (7/14/28 Tage Betrachtung).

- Conversion-Proxies: Uplift in Mikro-Conversions (Newsletter, Trials, Demos) in zeitlicher Nähe zu AI-Visibility-Gewinnen.

Attribution in der Praxis:

- Vorher/Nachher-Analyse um signifikante Ereignisse (z. B. +X% Citation Share in Top-Queries) mit festen Zeitfenstern.

- Kontrollgruppen: Cluster ohne Sichtbarkeitsänderung zum Vergleich heranziehen.

- Multi-Touch: AI Visibility mit organischem Traffic, PR-Erwähnungen und Social-Mentions triangulieren. Kontextdaten zu Marktveränderungen liefern Branchenreports wie Search Engine Land zu Q4 2024, auch wenn sie keine GEO-spezifische Attribution bieten.

7) Praxis: So operationalisieren Teams Monitoring und Adaption mit Geneo

Geneo ist eine auf AI-Sichtbarkeitsoptimierung spezialisierte Plattform, die für Marken und Agenturen den Alltag spürbar beschleunigt. Relevante Funktionen (laut Produktbeschreibung):

- KI-Erwähnungs- und Zitations-Tracking über ChatGPT, Perplexity, Google AI Overviews u. a.

- Echtzeit-Alerts bei Sichtbarkeits- oder Sentimentveränderungen

- Historisierung und Vergleich von Query-/Plattform-Entwicklungen

- AI-gestützte Content-/Strategie-Empfehlungen

- Multi-Brand- und Team-Workflows

So setze ich Geneo in Workflows ein:

A) Tagesroutine-Dashboard

- Für die Top-Queries je Marke: AI Visibility Rate, Citation Share, Sentiment-Heatmap.

- Abweichungen werden farblich markiert; ein Klick führt zum Detail mit Originalpassage/Quellenliste (plattformabhängig). Dadurch lässt sich schnell prüfen, ob Fakten/Framing korrekt sind.

B) Alerting mit Schwellenwerten

- Beispiel-Trigger: „-30% Citation Share in Top-20 Queries in 24 h“ oder „erstmaliges negatives Sentiment für Produktkategorie Y in ChatGPT-Antworten“.

- Alerts erzeugen automatisch ein Incident-Ticket mit Query, Plattform, Zeitstempel, Impact-Schätzung und Owner-Zuweisung.

C) Hotfix-Playbook direkt auslösen

- Content Lead erhält Aufgabenkarte mit konkreten Vorschlägen aus Geneo (z. B. fehlende zitierfähige Datenabschnitte, FAQ-Lücken, E-E-A-T-Stärkung).

- Technical SEO bekommt Schema-/Indexierungsempfehlungen.

- PR/Comms startet, falls nötig, eine Korrektur-Note mit einheitlicher Botschaft.

D) Historische Vergleiche & Wirksamkeitsmessung

- Nach 7/14/28 Tagen: Geneo-Report zeigt, ob AI Visibility, Citation Share und Sentiment sich erholt oder verbessert haben – je Plattform und Query-Cluster.

E) Multi-Brand-Governance

- Für Agenturen oder Unternehmensgruppen: ein zentrales Board bündelt Vorfälle, Prioritäten, SLA-Status und Lernpunkte; wiederkehrende Muster (z. B. Quellenpräferenzen) werden in Guidelines überführt.

Transparenz-Hinweis: Die oben beschriebenen Abläufe basieren auf den bereitgestellten Produktfunktionen. Externe, öffentlich verifizierte Case-Metriken zu Geneo liegen in dieser Darstellung nicht zugrunde; der Nutzen ergibt sich aus dem beschriebenen Prozessgewinn.

8) Incident- und Recovery-Checkliste (zum Direkt-Übernehmen)

-

Erstreaktion (<4 Std.)

- Incident im Board anlegen (Plattform, Query-Cluster, Datum/Uhrzeit, Impact, Owner).

- Relevante Beispiele sichern (Screenshots, Antworttexte, verlinkte Quellen).

- Interne Releases/Änderungen checken; Plattform-Release Notes prüfen, z. B. ChatGPT Release Notes (OpenAI, 2024–2025).

-

Diagnose (bis 24 Std.)

- Hypothesen priorisieren: Content-Freshness, Quellenmix, Technik, Reputation.

- Stichproben (manuell) gegenprüfen, insbesondere Sentiment-Fehlklassifizierungen.

-

Hotfix (24–48 Std.)

- Content aktualisieren (zitierfähige Daten/Definitionen, Datumsangaben, FAQ ergänzen).

- E-E-A-T-Signale stärken (Autorensteckbriefe, Primärquellen, Referenzen).

- Schema und interne Verlinkung justieren; Indexierung anstoßen.

- Korrektur-PR veröffentlichen, um einheitliche Faktenlage zu schaffen.

-

Offpage (1–2 Wochen)

- Outreach an häufig zitierte Drittquellen; Bereitstellung offizieller, verlinkbarer Primärquellen.

-

Review (7/14/28 Tage)

- KPI-Vergleich in den Dashboards (AI Visibility Rate, Citation Share, Sentiment).

- Lessons Learned dokumentieren; SOPs aktualisieren.

9) Typische Stolperfallen – und wie man sie vermeidet

- Nur auf eine Plattform schauen: Wer nur Google betrachtet, übersieht Chancen und Risiken in ChatGPT/Perplexity/Copilot.

- Kein Schwellenwert-Alerting: Manuelles „Durchklicken“ reicht nicht – ohne Alerts kommen Reaktionen zu spät.

- Sentiment blind vertrauen: Automatisierte Klassifizierungen sind nicht unfehlbar; stichprobenartig manuell validieren.

- Maßnahmenwirkung nicht messen: Ohne Vor-/Nach-Vergleich lassen sich Ressourcen nicht priorisieren.

- PR nicht einbinden: Faktenkorrekturen ohne Kommunikationsspur bleiben oft wirkungsschwach.

10) Start in 14 Tagen: Eine realistische Roadmap

- Tag 1–2: Query-Inventory, Plattformliste, Rollen/SLA festzurren.

- Tag 3–5: Monitoring-Setup in Geneo konfigurieren; Schwellenwerte/Alerts definieren.

- Tag 6–7: Erste manuelle Validierung, Feintuning der Metriken.

- Tag 8–10: SOPs und Playbooks finalisieren; Team-Briefing durchführen.

- Tag 11–14: Erste Maßnahmenzyklen (Content-/Schema-Updates), Baseline-Reporting aufsetzen.

Nach zwei Wochen steht ein funktionsfähiges Minimal-Setup, das Sie fortlaufend verfeinern.

11) Ressourcen und weiterführende Lektüre

- Umfang und Ausbau der KI-Funktionen im Suchkontext: Google I/O 2025 Ankündigungen (Google, 2025)

- Agentenbasierte Web-Recherche: Introducing Deep Research (OpenAI, 2025)

- Laufende Modell-/Produktänderungen: ChatGPT Release Notes (OpenAI, 2024–2025)

- Quellen-Transparenz in Endnutzer-Antworten: Getting Started (Perplexity, laufend aktualisiert)

- Quellensteuerung in Enterprise-RAG: Use your data (Microsoft Azure OpenAI, 2025)

- Markt- und Umfeldveränderungen: Tinuiti Benchmark Coverage (Search Engine Land, 2024)

- Tool-Ökosystem-Updates: Semrush Updates (2024)

Schlussgedanke und nächster Schritt

KI-Suchumgebungen entwickeln sich schneller als klassische SEO-Zyklen. Wer heute gewinnt, beherrscht das Handwerk: messen, deuten, handeln – kontinuierlich. Ein multiplattformfähiges Monitoring mit klaren SLAs, ein belastbares KPI-/ROI-Set und ein eingespieltes Team sind die Trümpfe.

Wenn Sie diesen Ansatz ohne Overhead starten möchten, testen Sie Geneo in Ihrem Setup: Multi-Plattform-Brand-Monitoring, Echtzeit-Alerts, Sentiment-Analyse, Historisierung und Content-Empfehlungen – alles an einem Ort. Jetzt kostenlose Testphase starten: https://geneo.app