How to Reverse-Engineer KI-Suchergebnisse: Praxisleitfaden & Protokoll

Schritt-für-Schritt-Anleitung für das Reverse-Engineering von KI-Suchergebnissen: effektives Logging, Zitationsanalyse und Monitoring Ihrer AI Visibility. Jetzt umsetzen!

Wer KI‑Suchergebnisse verstehen will, arbeitet gegen eine Black Box. Exaktes Reverse‑Engineering ist nicht möglich – aber probabilistische Muster sind messbar. Genau hier setzt dieses Playbook an: Sie bauen ein wiederholbares Test‑ und Monitoring‑Setup auf, erkennen, warum Quellen zitiert werden (oder nicht), und verbessern gezielt Ihre AI Visibility. Eine kompakte Begriffseinordnung zu AI Visibility finden Sie in „What Is AI Visibility? Brand Exposure in AI Search Explained“.

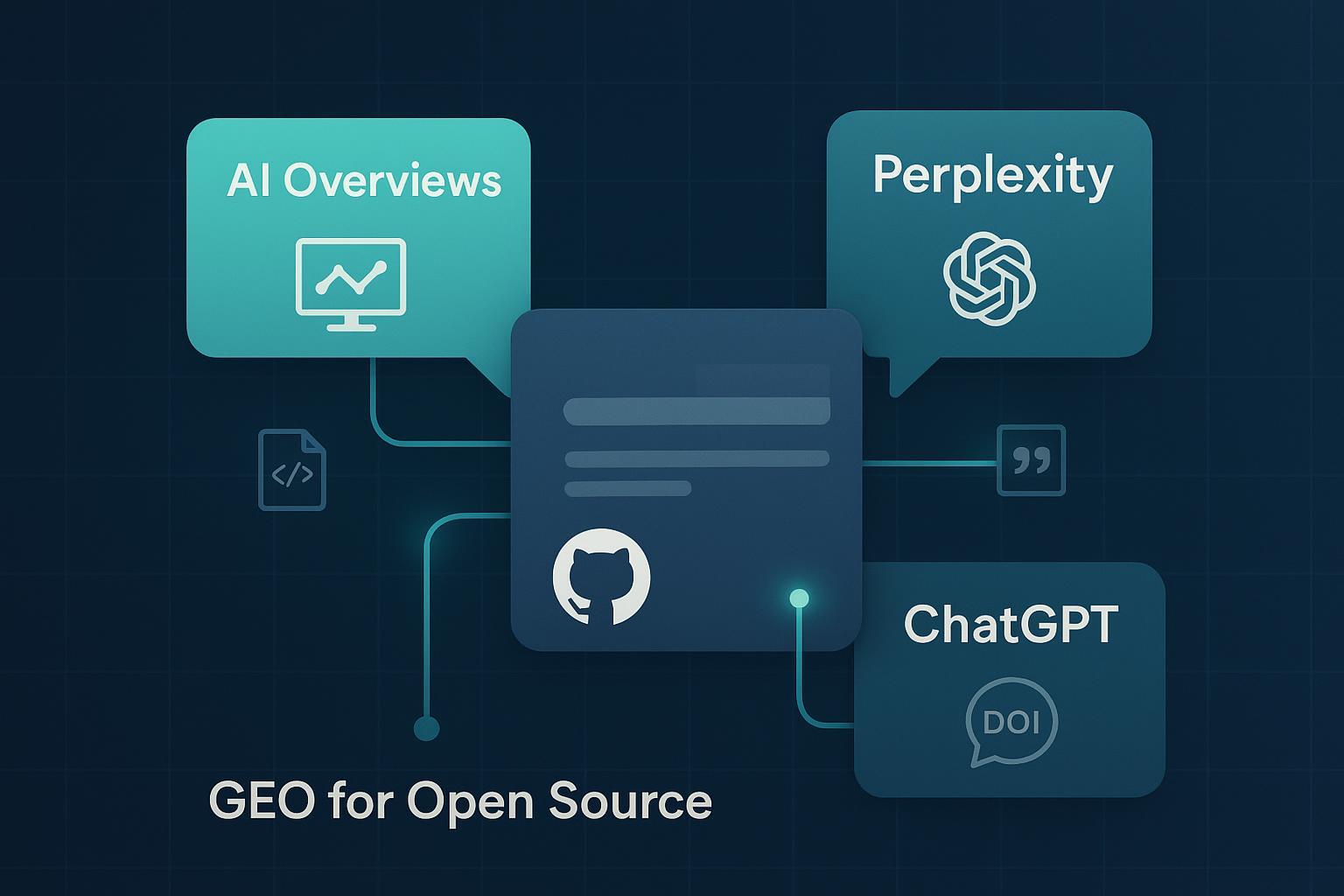

Warum Probabilistik? Google beschreibt die „Übersicht mit KI“ (AI Overviews) als generative Zusammenfassung, die erscheint, wenn sie „besonders hilfreich sein kann“ – inklusive Links zu Quellen, damit Nutzende die Ursprungsseiten prüfen können. Das unterstreicht den Fokus auf Qualitätssignale und nachvollziehbare Belege, etwa E‑E‑A‑T‑Prinzipien in den Search‑Docs. Siehe die offiziellen Hinweise in „Übersicht mit KI in der Google‑Suche“ sowie „E‑E‑A‑T in den Search Essentials“. Perplexity wiederum ist ein „Answer Engine“ mit Echtzeit‑Websuche und Zitaten, vgl. „Help Center: How Perplexity works“. Und bei ChatGPT Search macht OpenAI deutlich, dass Antworten mit Websuche „inline citations“ enthalten, siehe „ChatGPT Search (OpenAI Help)“. Als technischer Unterbau erklärt u. a. das Fraunhofer IESE, wie Retrieval‑Augmented‑Generation (RAG) Quellenbindung und Nachvollziehbarkeit stärkt: „RAG erklärt“.

A. Das Setup: Queries, Cluster, Protokoll

Starten Sie mit einem kontrollierten Experiment. Bilden Sie Query‑Cluster nach Intent (informational, transactional, navigational) und nach Entitäten (Marke, Produkt, Kategorie). Pro Cluster definieren Sie 5–10 repräsentative Suchanfragen und testen diese parallel in Google (AIO‑Ausspielung prüfen), Perplexity und ChatGPT Search/Gemini. Halten Sie bei jedem Run Zeitstempel, Ort/Sprache und Login‑Status fest. Nur so lassen sich später Schwankungen und Saisonalität von echten Verbesserungen unterscheiden.

Praxisnahe Frage: Brauchen Sie viele Queries? Wenige, aber sauber ausgewählte Queries pro Cluster liefern oft bessere Einsichten als eine unstrukturierte Masse. Denken Sie an Kontrollgruppen: unveränderte Seiten vs. optimierte Seiten über denselben Zeitraum.

B. SERP ↔ AI Overviews und On‑Page‑Hausaufgaben

Ein robuster Indikator ist die Korrelation zwischen klassischen SERP‑Top‑Quellen und den in AI Overviews verlinkten Seiten. Stellen Sie für jede Query die organischen Top‑10‑Domains der AIO‑Zitierliste gegenüber. Häufig ergeben sich Überschneidungen – aber keine 1:1‑Deckung. Die Lücke zeigt Optimierungschancen jenseits pures SERP‑Rankings an: klare Struktur, präzise definitorische Sätze, sichtbare Autorität.

Ihre On‑Page‑Hausaufgaben bestehen aus drei Säulen:

- Strukturierte Daten: Ergänzen/prüfen Sie Schema.org‑Markup (Article, FAQ, HowTo, Breadcrumb, Person/Organization) inklusive author, datePublished, mainEntityOfPage, about. Validieren Sie regelmäßig mit dem Rich‑Results‑Test. Die Suchdokumentation betont diese Grundlagen in den „Search Essentials/E‑E‑A‑T“-Rahmenwerken.

- E‑E‑A‑T sichtbar machen: Nennen Sie Autor:in mit Qualifikation, fügen Sie Belege und externe Referenzen ein und pflegen Sie Aktualisierungs‑/Versionshinweise. Seriosität und Kontext verdichten die Wahrscheinlichkeit einer Zitierung.

- Freshness: Inhalte, die eine Aktualitäts‑Erwartung tragen, sollten Datum, letzte Änderungen und neue Datenpunkte deutlich zeigen. Aktualisierte Abschnitte können die Auswahlchance erhöhen, wenn Systeme „frische“ Antworten bevorzugen.

C. Antwortmuster sichtbar machen (Perplexity, ChatGPT/Gemini)

Um Muster zu erkennen, variieren Sie pro Query 3–5 Prompt‑Formulierungen: neutral („Erkläre …“), kontextreich („Für B2B‑Einsatz, DACH‑Markt …“), eingeschränkt („Nur Schritt‑für‑Schritt, mit Quellen …“). Protokollieren Sie, ob sich die Zitationsreihenfolge, die Zahl der Quellen oder die Antwortstruktur ändern. Bei RAG‑ähnlichen Systemen (Perplexity, teils ChatGPT/Gemini) sind diese Effekte oft sichtbar. Stabil wiederkehrende Bausteine weisen den Weg: definitorische Eröffnungssätze, nummerierte Schritte, kurze Pro/Contra‑Blöcke, ein Mini‑Fazit mit Quellenkarten.

Für die Content‑Optimierung heißt das: Platzieren Sie prägnante Definitionssätze früh im Text, ordnen Sie Schritte sauber unter H2/H3, und bieten Sie eine kurze, evidenzbasierte Zusammenfassung mit verlinkten Primärquellen. So erhöhen Sie die „Zitier‑Tauglichkeit“ Ihrer Seite, ohne platt zu kopieren.

D. Dein Mess‑ und Logging‑Schema (Template)

Ein gutes Log ist halb gewonnen. Erfassen Sie bei jedem Run mindestens diese Felder und werten Sie sie je Engine separat aus.

| Datum/Uhrzeit | Engine/Modus | Query/Prompt | AIO/Antwort‑URL | Zitierte Domains/Links | Zitier‑Position | Antwortstruktur | Hinweise/Fehler | SERP Top‑10 | Schema‑Status | E‑E‑A‑T‑Check | Freshness‑Hinweis |

|---|---|---|---|---|---|---|---|---|---|---|---|

| 2025‑12‑06 10:15 | Google AIO (DE) | „prozesskosten abrechnen kmu“ | – | domainA.de; domainB.de; … | oben/mitte/unten | Definition; Schritte | „KI kann Fehler enthalten“ | [Top‑10 gespeichert] | Article+FAQ valide | Autorprofil ja | aktualisiert 2025‑11 |

| 2025‑12‑06 10:25 | Perplexity | gleich | Antwort‑Permalink | domainC.de; domainA.de; … | 1.; 3.; 4. | Liste; Pro/Contra | – | – | – | – | – |

KPI‑Rahmen für die Auswertung (je Cluster und je Engine): Citation Rate (CR), Engine Coverage (EC), Citation Prominence (CP), Source Stability (Stab), Freshness Match (FM), Structured Data Health (SDH), SERP‑AIO Overlap (SAO). Eine detaillierte Einordnung mit Praxisbeispielen finden Sie im Beitrag „AI Sichtbarkeit KPIs 2024: Best Practices für Brand Mentions/Citations“.

E. Troubleshooting: Wenn Zitationen ausbleiben

Bleiben Zitationen aus oder verschwinden sie, prüfen Sie die typischen Ursachen. Fehlende/fehlerhafte strukturierte Daten? Ergänzen Sie Article/FAQ/HowTo, prüfen Sie author/datePublished/mainEntityOfPage und validieren Sie mit dem Rich‑Results‑Test. Schwache E‑E‑A‑T‑Signale? Stärken Sie Autor:innenprofil, Belege und Impressums‑/Kontakttransparenz. Freshness‑Defizite? Aktualisieren Sie Inhalte, fügen Sie neue Daten ein, datieren Sie sichtbar. Unklare Struktur? Verdichten Sie definitorische Passagen, formulieren Sie die Schritte präziser, vernetzen Sie zu vertiefenden Stücken. Technische Hürden wie Indexierung oder Performance? Beheben Sie sie gemäß den Grundlagen im SEO‑Starter‑Guide. Und: Verwechseln Sie Korrelation nicht mit Kausalität – wiederholen Sie Tests, arbeiten Sie mit Kontrollgruppen und dokumentieren Sie systematisch.

F. Monitoring & KI‑Response‑Datenbank (mit Beispiel)

Ohne konsistente Dokumentation lässt sich kein Muster stabil belegen. Legen Sie deshalb eine interne „KI‑Response‑Datenbank“ an. Spalten entsprechen dem Logging‑Template; zusätzlich speichern Sie Screenshots der Antworten und Quellenkarten. Aktualisieren Sie Cluster wöchentlich oder 14‑tägig und markieren Sie Änderungen an Ihren Seiten (Schema‑Rollout, Content‑Update). Über die Zeit entsteht ein klares Bild, welche Taktiken wirken.

Disclosure: Geneo ist unser Produkt. Für das plattformübergreifende Mentions‑ und Zitations‑Tracking kann „Geneo“ eingesetzt werden: Es unterstützt die Erfassung von Marken‑Erwähnungen und Zitierungen in ChatGPT, Perplexity und Google AI Overviews, ordnet Sentiment zu und speichert historische Runs. Ein möglicher Mini‑Workflow: 1) Query‑Cluster definieren und erste Runs protokollieren; 2) Zitations‑Treffer und Sentiment automatisch erfassen; 3) Varianten‑Tests (z. B. Schema‑Erweiterung, Text‑Refactor) anstoßen; 4) CR/CP/Stabilität je Engine vergleichen; 5) gewonnene Muster in die Redaktionsrichtlinien überführen. Mehr Tiefe zu GEO/Begriffswelten finden Sie ergänzend im Überblick „Nouveaux acronymes SEO : GEO, GSVO, AIO, LLMO“.

G. Nächste Schritte

- Planen Sie eine erste Messrunde über 2–3 Query‑Cluster mit 5–10 Queries je Cluster. Protokollieren Sie exakt und wiederholen Sie die Runs im festen Rhythmus.

- Leiten Sie nach zwei Iterationen 2–3 Hypothesen ab (z. B. „klare Definition + FAQ‑Schema erhöht CR in AIO um X Punkte“) und testen Sie gezielt gegen Kontrollgruppen.

- Verankern Sie das Logging im Team: Wer führt Runs durch, wer wertet aus, wer setzt Änderungen um? Kleine Disziplingewinne addieren sich – und plötzlich erkennen Sie stabile Muster.

Sie wollen die Sichtbarkeit Ihrer Marke in KI‑Antworten systematisch messen und optimieren? Beginnen Sie mit dem Logging‑Template oben, binden Sie die genannten Quellen in Ihre On‑Page‑Hausaufgaben ein, und skalieren Sie die Tests schrittweise. Für konsistentes, engine‑übergreifendes Tracking von Erwähnungen, Zitierungen und Sentiment kann Geneo den Prozess unterstützen – die Methodik bleibt jedoch dieselbe: beobachten, messen, iterieren.