15 essentielle GEO-Tools für Content-Teams 2025

Entdecken Sie 15 GEO-Tools für AI-Sichtbarkeit, Monitoring, Sentiment & Optimierung. Praktische Segmentierung, aktuelle Tipps & Teamempfehlungen für 2025.

GEO – Generative Engine Optimization – rückt 2025 vom Buzzword zum Betriebsstandard. Während klassische SEO auf blaue Links zielt, entscheidet GEO, ob Inhalte in KI-Antworten erscheinen, zitiert und verstanden werden. Eine fundierte Einführung liefert Search Engine Land: siehe den Überblick „What is generative engine optimization (GEO)?“. Ergänzend ordnet HubSpot 2025 GEO als Brücke zu AI-Answer-Engines ein; vgl. den deutschsprachigen Leitfaden „Google AI Overviews“ (Kontext und Auswirkungen auf Marketing).

So viel zur Theorie—und jetzt zur Praxis: Welche Tools gehören 2025 in den Stack? Unten finden Sie einen kuratierten Überblick, segmentiert nach Use Cases. Transparenzhinweis zu Geneo: Disclosure: Geneo ist unser Produkt.

Wie wir bewertet haben

Wir haben die Tools nach folgenden Kriterien eingeordnet (Gewichtung in Klammern):

- Engine-Abdeckung & Datentiefe (25%)

- Lernkurve/Implementierung & Team-Fit (15%)

- Messbarkeit & Reporting (15%)

- Evidenzqualität/Transparenz (15%)

- Integrationen & Workflow-Kompatibilität (15%)

- Preis/Value & Limits (15%)

Preisangaben, sofern genannt, verstehen sich als „ab“ und sind Änderungen vorbehalten. Für die Relevanz von AI Overviews in der Suche empfehlen wir den aktuellen Dateneinblick von Conductor (2025), der die Verbreitung und Wirkung von KI-Übersichten anhand eines großen Keyword-Samples analysiert; siehe die „Analyse zu AI Overviews (2025)“.

Welche Kategorie löst welches Problem?

| Kategorie | Hauptproblem | Ergebnis/Outcome |

|---|---|---|

| Monitoring (KI-Antwort-Präsenz) | „Erscheinen wir überhaupt in KI-Antworten – und wie oft?“ | Überblick über Erwähnungen, Zitationen, Trends, Alerts |

| Ranking-/Visibility-Tracking | „Wie verändert AI Search unsere Sichtbarkeit vs. klassische SERPs?“ | Zeitreihen, Share-of-Voice, Konkurrenzvergleich |

| Sentiment-/Narrativ-Analyse | „Wie wird unsere Marke in Antworten bewertet und kontextualisiert?“ | Tonalität, Narrative, Risikofrüherkennung |

| Prompt-/Response-Analyse & Testing | „Welche Prompts/Content-Formate führen zu besseren Zitaten?“ | Testläufe, Variantenvergleiche, Halluzinationsscreening |

| AI Overview/Answer-Engine Tracking | „Wo, wann, wie oft erscheinen AI Overviews – und nennen sie uns?“ | Abdeckung AO/SGE, Zitatanalyse, Auswirkungen |

| Content-/Entity-Optimierung | „Welche Entitäten/Belege fehlen unserem Content?“ | Strukturierte Inhalte, stärkere Zitationschancen |

1) Monitoring: KI-Antwort-Präsenz, Zitationen, Brand Mentions

-

Geneo — Monitoring für AI-Search-Sichtbarkeit (Disclosure: Geneo ist unser Produkt)

- Wofür geeignet: Zentrale Sicht auf Brand Mentions, Zitationen und Sentiment in Antworten über mehrere generative Engines hinweg; Multi-Brand- und Team-Workflows.

- Stärken: Alerts, Verlaufsvergleiche, Team-Kollaboration; praxisnahe KPI-Denke (Mentions, Citations, Share-of-Voice). Vertiefung: Leitfaden zu KPIs und Dashboards in „AI Sichtbarkeit KPIs 2024“.

- Zu beachten: Kein All-in-one-SEO-Suite-Ersatz; API- und Export-Anforderungen vor Rollout klären.

-

Profound — GEO Monitoring & Insights

- Wofür geeignet: Beobachtung von Präsenz in generativen Antworten, Wettbewerbs-Benchmarks und Content-Gaps; guter Startpunkt für GEO-Workflows. Siehe den aktuellen „GEO-Guide 2025 von Profound“.

- Stärken: GEO-spezifische Perspektive, Guides/Frameworks.

- Zu beachten: Funktionsumfang und Abdeckung je nach Plan prüfen; Datenscope dokumentieren.

2) Ranking-/Visibility-Tracking

-

Semrush — Sichtbarkeits- und SERP-Feature-Tracking

- Wofür geeignet: Breite Keyword- und Wettbewerbsanalysen; SERP-Feature-Tracking als Basis, um Veränderungen durch KI-Module gegen traditionelle Rankings zu stellen.

- Stärken: Reife Datenpipelines, Reporting, Integrationen in Content-Workflows.

- Zu beachten: GEO-spezifische Metriken (z. B. AI-Antwort-Zitate) sind nicht Kernfokus; Ergänzung durch dedizierte GEO-Tools sinnvoll.

-

Advanced Web Ranking (AWR) — Langfristiges Visibility-Tracking

- Wofür geeignet: Präzise Rank-Tracking-Zeitreihen und SERP-Feature-Beobachtung; solide Grundlage, um AO/SGE-Effekte neben klassischen Ergebnissen zu beobachten.

- Stärken: Historie, flexible Reports, Wettbewerbsvergleiche.

- Zu beachten: GEO-spezifisches Tracking ist begrenzt; AO-spezifische Erhebung gesondert evaluieren.

3) Sentiment- und Narrativ-Analyse

-

Brandwatch — KI-gestützte Sentiment- und Themenanalyse

- Wofür geeignet: Bewertung von Stimmungen und Narrativen rund um Marken/Produkte im Web und in sozialen Kanälen; gute Ergänzung zu GEO-Monitoring-Daten.

- Stärken: Ausgereifte Kategorisierung, Dashboards, Alerting.

- Zu beachten: Fokus nicht speziell auf Antwort-Engines; als Kontext-/Risikoradar nutzen.

-

Talkwalker — Marken- & Themenradar mit AI-Unterstützung

- Wofür geeignet: Trend-, Themen- und Sentiment-Analysen; Identifikation von Narrativen, die in KI-Antworten aufgegriffen werden könnten.

- Stärken: Breite Quellenbasis, Visualisierungen.

- Zu beachten: Verbindung zu GEO-Daten via Tags/Exports herstellen, um Insights zu konsolidieren.

4) Prompt-/Response-Analyse & Testing

-

Promptfoo — Open-Source LLM-Evaluierung

- Wofür geeignet: Systematische Tests von Prompt-/Output-Varianten, Qualitätsmetriken und Guardrails; ideal für interne GEO-Experimente. Siehe die „Promptfoo-Dokumentation“.

- Stärken: Reproduzierbare Test-Suites, Scorecards, CI-Integration.

- Zu beachten: Erfordert Setup-Disziplin und klare Metriken (Halluzination, Zitierqualität, Faktentreue).

-

LangSmith (LangChain) — Evaluation & Observability

- Wofür geeignet: Analyse von LLM-Pipelines, Traces und Ausgaben; nützlich für Teams, die eigene GEO-Testframeworks bauen.

- Stärken: Tiefe Observability, Datentagging, Experimentvergleiche.

- Zu beachten: Technischer; eher für Data/Platform-Teams als für reine Content-Redaktionen.

5) AI Overview-/Answer-Engine-Tracking

-

BrightEdge — AI Overview Analytics

- Wofür geeignet: Nachvollziehen, wo AI Overviews erscheinen, welche Quellen genannt werden und wie sich das auf die eigene Sichtbarkeit auswirkt. Produktseite: „BrightEdge Copilot & AI Overview Analytics“ (deckt AO-bezogene Analysen ab).

- Stärken: Enterprise-Reporting, Branchen-Benchmarks; expliziter Fokus auf Google AI Overviews. Kontext liefert u. a. die „Conductor-Analyse (2025)“.

- Zu beachten: Enterprise-Preisgefüge; Testzugang/Proof-of-Concept lohnt.

-

Conductor — AO-Insights & Studien

- Wofür geeignet: Strategische Planung auf Basis von AO-Prävalenz, Keyword-Mustern und Wirkungsanalysen; Produktmodule können AO-Daten in Reporting integrieren.

- Stärken: Aktuelle Studienbasis und Suchdaten-Know-how.

- Zu beachten: Prüfen, welche AO-Funktionen im jeweiligen Plan verfügbar sind.

-

Profound — Answer-Engine-Monitoring

- Wofür geeignet: Beobachtung generativer Antworten (inkl. Zitationsmuster) über mehrere Engines; hilfreich für Wettbewerbs- und Themenradar.

- Stärken: GEO-Spezialisierung; Framework-orientierte Workflows.

- Zu beachten: Abdeckung/Methodik offenlegen lassen (Sampling, Frequenz, Engines).

6) Content- und Entity-Optimierung

-

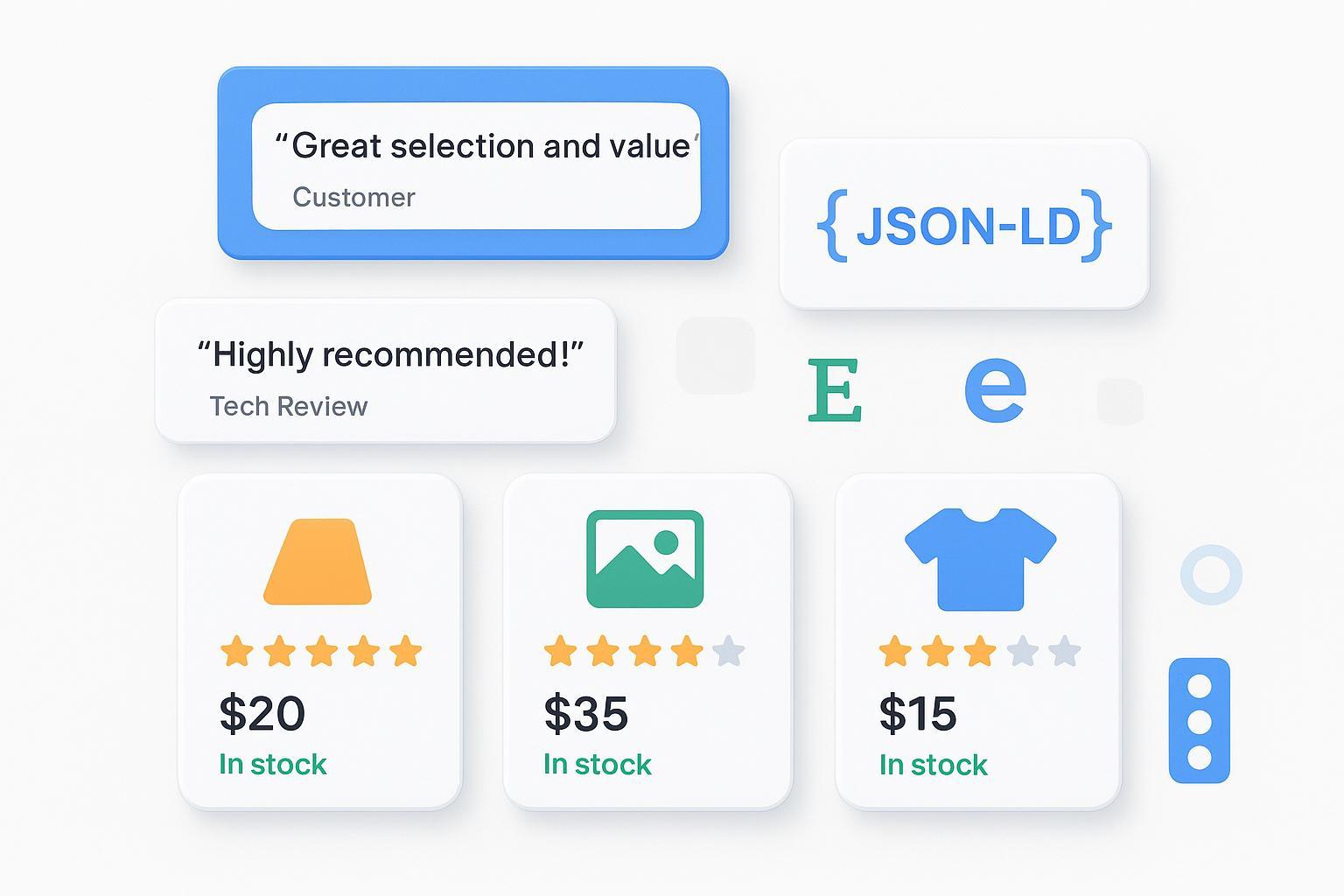

InLinks — Entitäten, interne Verlinkung, Schema

- Wofür geeignet: Aufbau und Pflege einer kohärenten Entitätsstruktur, bessere disambiguierte Inhalte und strukturierte Daten—alles Faktoren, die Zitationschancen in generativen Antworten erhöhen können. Offizieller Überblick: „InLinks – Entity SEO & Schema“.

- Zu beachten: Ergebnis hängt an sauberer Themenarchitektur; Guidelines und QA wichtig.

-

Clearscope — Content-Optimierung nach Themenabdeckung

- Wofür geeignet: Analysen zur Themenabdeckung, Termvorschläge, Lesbarkeit; solide Basis, um Content für E-E-A-T-konforme Belege aufzurüsten.

- Zu beachten: GEO ist kein eigenes Modul; Nutzen entfaltet sich über bessere inhaltliche Evidenz.

-

MarketMuse — Planung & Content-Briefing

- Wofür geeignet: Themencluster, Content-Briefs, Lückenanalysen; hilfreich, um recherchierte Quellen und Entitäten konsistent in Inhalte einzubauen.

- Zu beachten: Lernkurve und Kosten gegen Teamgröße abgleichen; Governance-Regeln definieren.

Setup-Empfehlungen nach Teamgröße

-

Kleine Teams/SMB:

Monitoring (Geneo oder Profound) + Visibility-Tracking (AWR oder Semrush) + eine Content-Optimierung (Clearscope oder InLinks). Prompt-Tests mit Promptfoo ad hoc. -

Scale-Ups/Agenturen:

Monitoring (Geneo) + Visibility-Tracking (Semrush + AWR) + AO-Insights (Conductor oder BrightEdge, je nach Budget) + Entity-/Content-Optimierung (InLinks + Clearscope) + strukturierte Prompt-/Output-Tests (Promptfoo, optional LangSmith). -

Enterprise:

BrightEdge für AO-Analytics + Conductor für Markt-/Keyword-Modelle + zentrales Monitoring (Geneo) + Governance (Entity-/Schema-Programm mit InLinks) + CI-gestützte Evaluierung (LangSmith) + dedizierte Risiko-/Narrativ-Überwachung (Brandwatch/Talkwalker).

Praxis-Tipps für den Betrieb

- Klare KPIs: Mentions, Citations, Share-of-Voice, Zitierqualität, Faktentreue. Definieren Sie Messfenster (z. B. 28/90 Tage) und Trigger für Alerts. Eine kompakte KPI-Definition samt Dashboard-Beispielen finden Sie im Leitfaden „AI Sichtbarkeit KPIs 2024“.

- Evidenz sichern: Quellen in eigenen Artikeln sauber benennen, aktualisieren und strukturieren (Schema, Autor:in, Datum, Zitate). Wollen Sie in Antworten genannt werden, müssen Belege schnell erfassbar sein.

- Tests staffeln: Erst Content-Fixes (Entitäten/Belege), dann Prompt-/Snippet-Varianten, zuletzt komplexe Experimente. Think of it this way: Erst das Fundament, dann der Ausbau.

- Compliance im Blick: Prüfen Sie Datenquellen, Crawler-Policies und API-Nutzungen der Tools; dokumentieren Sie Sampling-Methoden und Coverage-Annahmen.

Fazit

GEO ist kein Ersatz für SEO, sondern die fehlende Brücke zu Antwort-Engines. Wer 2025 gewinnen will, baut einen kompakten, messbaren Stack aus Monitoring, Visibility-Tracking, AO-Insights, Evaluierung und Entity-/Content-Optimierung. Wenn Sie ein zentrales Monitoring für AI-Antworten testen möchten, probieren Sie Geneo in einem Pilotprojekt—klein starten, sauber messen, schnell lernen.