Wie GEO‑Tools E‑E‑A‑T‑Signale auditieren: Praxisleitfaden für KI‑Sichtbarkeit

Schritt-für-Schritt Audit der E‑E‑A‑T‑Signale für GEO. Praxisnaher Leitfaden zur Verbesserung Ihrer Sichtbarkeit in KI‑Antworten.

Wer heute in AI Overviews und LLM‑Antworten sichtbar sein will, muss mehr liefern als Keywords. Es geht um überprüfbare Erfahrung, echte Expertise, nachvollziehbare Autorität und Vertrauen – kurz: E‑E‑A‑T. Dieser Leitfaden zeigt Schritt für Schritt, wie Sie E‑E‑A‑T‑Signale im GEO‑Kontext (Generative Engine Optimization) auditieren und messbar verbessern.

E‑E‑A‑T im GEO‑Kontext – warum es zählt

E‑E‑A‑T (Experience, Expertise, Authoritativeness, Trust) ist seit Jahren der Qualitätsrahmen, an dem sich die Bewertung von Seiten orientiert. Die Quality Rater Guidelines beschreiben den Rahmen ausführlich und benennen Vertrauen als übergeordneten Faktor; sie sind die Referenz dafür, wie Qualität beurteilt wird, auch wenn sie kein Ranking‑Algorithmus sind. Lesen Sie dafür die offizielle PDF von Google: die Search Quality Evaluator Guidelines (PDF, 2024/2025).

Für die Umsetzung auf Websites liefert Google praktische Grundlagen in den Search Essentials/SEO‑Starter‑Guide (de). In der Praxis heißt das: klare Autorenschaft, Quellen, Aktualisierungen, technische Sauberkeit und eine verlässliche Nutzererfahrung.

GEO verschiebt die Perspektive: Inhalte müssen nicht nur ranken, sondern auch von Antwortmaschinen zitiert werden. Wer die Unterschiede zwischen klassischem SEO und GEO sauber verstehen möchte, findet eine Einordnung im Beitrag Traditional SEO vs GEO: Vergleich und Strategie.

Audit‑Setup: Scope, Queries, Protokollierung

Bevor Sie mit Detailprüfungen starten, legen Sie ein minimales Audit‑Setup fest. So stellen Sie sicher, dass Ergebnisse vergleichbar sind und Sie Veränderungen messen können.

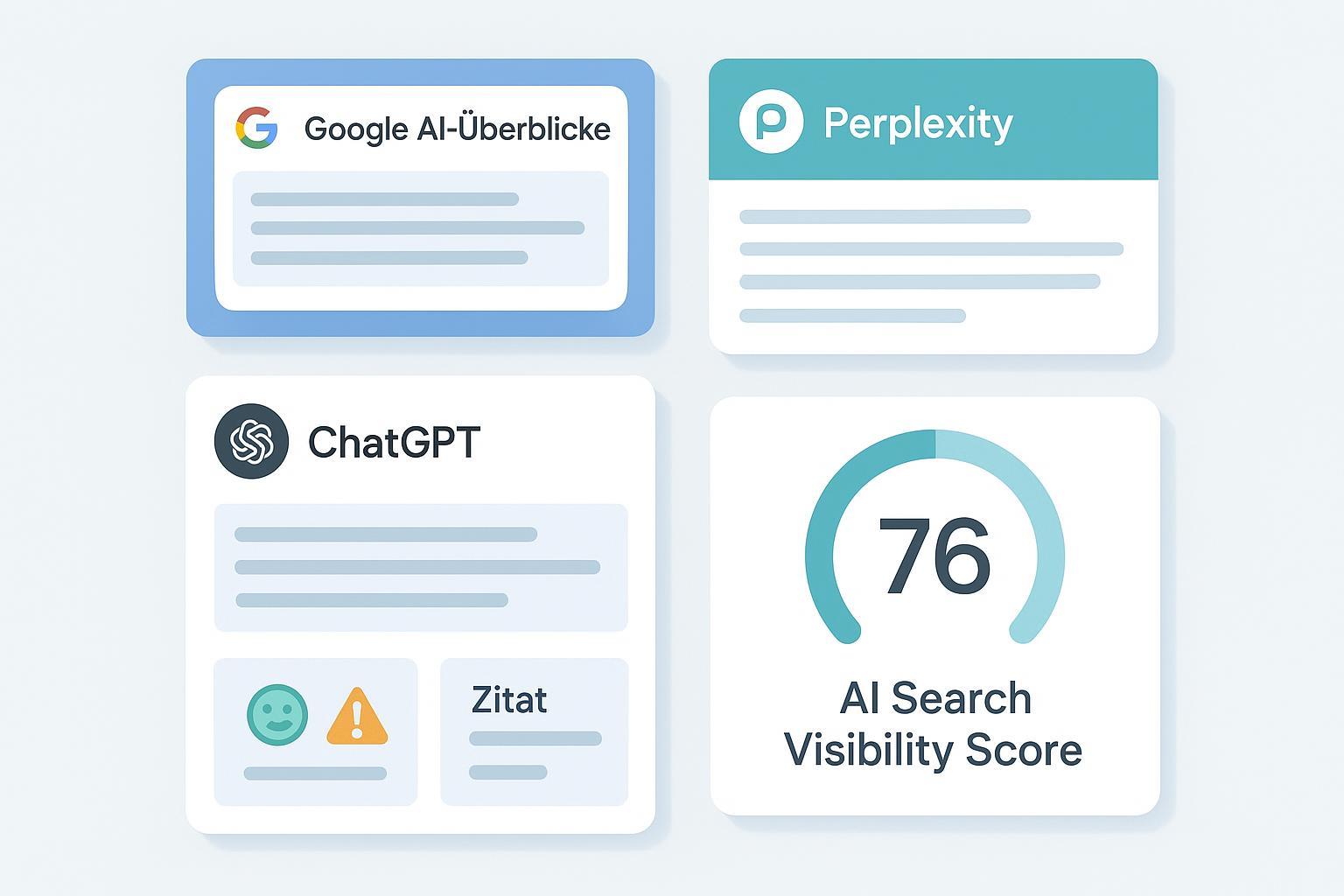

- Definieren Sie Themencluster und Kernfragen: 10–20 repräsentative Suchfragen pro Cluster (Informations‑ und Vergleichsfragen). Notieren Sie Query, Datum/Uhrzeit, Land/Sprache und Engine (Google AI Overviews, ChatGPT Search, Perplexity).

- Erheben Sie Sichtbarkeit und Zitierungen: Wird Ihre Domain verlinkt? Unter welchem Ankertext? Wie ist der Kontext (positiv/neutral/kritisch)? Protokollieren Sie Screenshots mit Zeitstempel.

- Mappen Sie Ihre Inhalte zu den Fragen: Welche Seite „verdient“ die Zitierung? Fehlen Belege, Aktualität oder klare, zitierfähige Absätze?

Tipp: Vereinbaren Sie fixe Stichprobenzyklen (z. B. monatlich) und nutzen Sie ein einheitliches Log‑Template. Klingt banal, spart aber enorm viel Zeit im Review.

Die vier Säulen praktisch prüfen

Statt in Theorien zu schwelgen, prüfen Sie jede Säule auf konkrete Evidenzen und Lücken.

- Experience/Expertise (On‑page Evidenzen)

Zeigen Sie belegte Erfahrung: Autor:innen mit Qualifikation, Fallbeispiele, Screenshots eigener Tests, Primärdaten. Platzieren Sie am Artikelanfang kurze „Warum Sie mir vertrauen können“-Signale (z. B. Berufstitel, Praxisjahre) und verlinken Sie ausführliche Autorenprofile. Weisen Sie Aktualisierungen sichtbar aus (dateModified). Zitatfähige Absätze mit präzisen Aussagen (inkl. Quelle/Jahr) erhöhen die Chance, in Antworten aufzutauchen.

- Autorität/Reputation (Off‑page)

Autorität entsteht durch qualitativ starke Erwähnungen und Verlinkungen. Sammeln Sie Belege aus vertrauenswürdigen Medien, Branchenverbänden oder Peer‑Reviews. Für GEO relevant: Werden diese Quellen in AI‑Antworten mitgeführt? Eine organische, themenrelevante Reputation verbessert Ihre Zitierwürdigkeit.

- Vertrauen/UX

Transparente Ownership (Impressum, Kontakt), Datenschutz, klare Richtlinien zu Korrekturen und ein störungsfreies Nutzungserlebnis signalisieren Verlässlichkeit. Technische Performance (z. B. INP ≤ 200 ms) und Barrierefreiheit reduzieren Reibung. Denken Sie an klare Hinweise zu Quellen und an nachvollziehbare Methodik.

- Technik/Schema

Strukturierte Daten machen Nachweise maschinenlesbar. Für Wissensinhalte sind vor allem Article/BlogPosting, Person (Autor) und Organization (Publisher) relevant. Testen Sie Ihre Markups konsequent mit dem Rich‑Results‑Test und dem Schema Markup Validator. Ein minimales JSON‑LD‑Beispiel:

{

"@context": "https://schema.org",

"@type": "Article",

"headline": "Wie GEO‑Tools E‑E‑A‑T‑Signale auditieren",

"datePublished": "2025-08-20",

"dateModified": "2025-12-01",

"author": {

"@type": "Person",

"name": "Vorname Nachname",

"jobTitle": "SEO Consultant",

"url": "https://example.com/autor",

"sameAs": [

"https://www.linkedin.com/in/beispiel",

"https://x.com/beispiel"

]

},

"publisher": {

"@type": "Organization",

"name": "Beispiel GmbH",

"url": "https://example.com",

"logo": {

"@type": "ImageObject",

"url": "https://example.com/logo.png"

}

}

}

Weiterführende Spezifikationen finden Sie bei Google: Article/BlogPosting Markup, Person und Organization. Achten Sie auf Übereinstimmung zwischen sichtbaren Inhalten und JSON‑LD (kein „Hidden Schema“).

Engine‑spezifische Prüfpfade

Google AI Overviews

Google beschreibt, dass AI Overviews Quellen einblenden und Nutzer zu weiterführenden Seiten führen. Ein guter deutschsprachiger Einstieg ist „Google Suche 101: Übersicht mit KI“ (Google, 2024). Was können Sie steuern? Im Entwicklerleitfaden „AI‑Funktionen in der Suche und Ihre Website“ (Search Central) finden Sie technische Optionen wie max‑snippet, nosnippet oder data‑nosnippet. Nutzen Sie diese bewusst, etwa wenn sensible Passagen nicht in KI‑Kurzfassungen erscheinen sollen.

ChatGPT Search

OpenAI bestätigt, dass Antworten, die die Suche nutzen, mit klickbaren Quellenangaben erscheinen. Prüfen Sie, ob Ihre Seite als Quelle auftaucht, und passen Sie Inhalte daraufhin an (präzise, belegte Aussagen, klare Autorenschaft). Quelle: „ChatGPT Search“ (OpenAI Help, de).

Perplexity (beobachtete Praxis)

Perplexity zeigt Quellen prominent als Karten/Footnotes; exakte deutsche Primärdokumentation zur Zitierlogik ist jedoch schwer auffindbar. Handhaben Sie das empirisch: Fokussierte, definitorisch starke Absätze mit originären Daten werden häufiger herangezogen. Dokumentieren Sie Beobachtungen mit Screenshots und passen Sie Ihre Inhalte iterativ an.

Messen & Reporten

Definieren Sie wenige, belastbare Kennzahlen, die sowohl klassische Qualität als auch GEO‑Sichtbarkeit abbilden. Die folgende Tabelle ist ein erprobter Startpunkt.

| KPI | Definition | Messmethode | Frequenz | Ziel/Orientierung |

|---|---|---|---|---|

| AI‑Zitierungsrate (pro Engine) | Anteil Queries pro Cluster, in denen Ihre Domain als Quelle verlinkt wird | Stichprobenprotokoll mit Screenshots (AI Overviews, ChatGPT, Perplexity) | monatlich | +10–20% in 2–3 Quartalen realistisch bei konsequentem Audit |

| Share of Voice in AI‑Antworten | Sichtbarkeitsanteil vs. Top‑Wettbewerber | Query‑Vergleich, Quellenzählung je Antwort | monatlich | Steigende Tendenz je Cluster |

| Schema‑Abdeckung (Article/Person/Org) | Anteil Seiten mit valider Markup‑Kombination | Rich‑Results‑Test/Schema Validator | quartalsweise | >90% valide Seiten |

| Aktualitätsquote | Anteil Top‑Seiten mit Update ≤ 6 Monate | CMS‑Änderungslog | monatlich | >70% in kritischen Clustern |

| Trust‑Elemente‑Abdeckung | Impressum, Kontakt, Datenschutz, Autorenseite vorhanden | manuelles Audit/Automationsregeln | quartalsweise | >95% |

Weiterführend: detaillierte KPI‑Definitionen und Best Practices finden Sie im Guide „AI‑Sichtbarkeit KPIs: Marken‑Erwähnungen und Citations messen“.

Zur strategischen Einordnung von GEO empfehlen sich zudem die praxisnahen Artikel von Search Engine Land, etwa „What is generative engine optimization (GEO)?“ (SEL, 2024).

Troubleshooting: typische Fehler und schnelle Lösungen

- Autoren ohne belastbare Profile: Legen Sie dedizierte Profilseiten an, verknüpfen Sie diese intern und via Person‑Markup (sameAs zu LinkedIn/X).

- Inkonsistentes Schema: Stimmen author/publisher im JSON‑LD nicht mit der sichtbaren Seite überein, verliert das Markup an Wert. Synchronisieren und testen Sie Änderungen vor dem Rollout.

- Dünne Quellenlage: Bauen Sie Primärbelege ein (Umfragen, Tests, eigene Daten) und nennen Sie das Jahr der Quelle im Text – das erhöht Zitierwürdigkeit.

- Veraltete Inhalte: Etablieren Sie quartalsweise Review‑Zyklen. Hinweise und Empfehlungen zum Update‑Management finden Sie im Beitrag „Google‑Algorithmus‑Update Oktober 2025: Empfehlungen“.

- Keine Monitoring‑Routine: Definieren Sie eine feste Stichprobengröße pro Cluster und protokollieren Sie Screenshots. Ohne Beleg kein Fortschritt.

Mikro‑Beispiel‑Workflow: AI‑Zitierungen tracken (Tool‑gestützt)

Hinweis: Geneo ist unser Produkt.

Beispielhaft zeigt „Geneo“, wie sich Zitierungen über mehrere Answer‑Engines protokollieren lassen – nutzerfreundlich und mit Verlauf. So könnte ein neutraler Workflow aussehen:

- Cluster und Kernfragen hinterlegen (z. B. 15 Fragen pro Cluster, deutsch/österreichisch/schweizer Markt getrennt).

- Monatliche Stichproben abrufen und automatisch als Screenshots/Protokoll speichern lassen.

- Zitierungsrate pro Engine auswerten, Sentiment der Erwähnungen prüfen und Abweichungen markieren.

- Content‑Backlog priorisieren: Seiten mit niedriger Zitierungsrate erhalten Maßnahmen (klarere zitatfähige Absätze, aktualisierte Quellen, ausgebautes Autor:innen‑Profil).

Das ersetzt kein On‑page‑/Schema‑Audit, hilft aber, Fortschritte in AI‑Antwortschichten sichtbar zu machen.

Nächste Schritte

- Governance etablieren: Für jedes Cluster klare Verantwortlichkeiten (Autor:in, Prüfer:in, Aktualisierungsrhythmus, Freigabecheck zu Quellen/Schema).

- Engine‑Spezifität operationalisieren: Feste Prüfpunkte für AI Overviews‑Links, ChatGPT‑Quellenkarten und Perplexity‑Footnotes.

- Messroutine standardisieren: KPI‑Dashboard monatlich aktualisieren, Abweichungen kommentieren, Maßnahmen nachhalten. Wenn Sie das Monitoring bündeln möchten, kann Geneo diese Aufgaben unterstützen – unverbindlich testen: Geneo.

Abschließend eine Frage: Welche zwei Seiten auf Ihrer Domain verdienen es wirklich, nächste Woche in AI‑Antworten zitiert zu werden – und welche Evidenz fehlt ihnen noch?

Quellen und weiterführende Hinweise

- Google: Search Quality Evaluator Guidelines (PDF, 2024/2025)

- Google: SEO‑Starter‑Guide/Search Essentials (de)

- Google: „Google Suche 101: Übersicht mit KI“ (2024)

- Google Search Central: „AI‑Funktionen in der Suche und Ihre Website“

- OpenAI Help: „ChatGPT Search“ (de)

- Search Engine Land: „What is generative engine optimization (GEO)?“ (2024)