Content Quality Scores und GEO: Best Practices 2025

Der Leitfaden für Profis zu Content Quality Scores, Audits und KPI-Monitoring für Generative Engine Optimization (GEO) 2025. KI-Sichtbarkeit messbar steigern.

Wer in generativen Suchumgebungen sichtbar bleiben will, braucht messbare Content‑Qualität – nicht nur „gutes Bauchgefühl“. Doch wie übersetzt man Qualität in belastbare Scores, die in Google AI Overviews, ChatGPT‑basierten Suchmodi und Perplexity tatsächlich Wirkung zeigen? Und wo unterscheiden sich diese Signale von klassischen SEO‑Kennzahlen?

Dieser Leitfaden zeigt, wie Sie Content Quality Scores im Jahr 2025 definieren, prüfen und für Generative Engine Optimization (GEO) operationalisieren.

Was sind Content Quality Scores im GEO‑Kontext?

Unter Content Quality Scores verstehen wir eine verdichtete Bewertungsgröße, die vier Ebenen bündelt:

- E‑E‑A‑T‑Signale (Experience, Expertise, Authoritativeness, Trustworthiness)

- ROT‑Bereinigung (Redundant, Obsolete, Trivial)

- Struktur/Technik (H‑Struktur, FAQ/HowTo‑Blöcke, Autorenprofil, Schema.org, Indexierbarkeit)

- GEO‑spezifische KPIs (z. B. AI Citation Share, Prompt Coverage Rate, Sentiment)

So wird Qualität nicht nur „gefühlt“, sondern als Score messbar, priorisierbar und in Redaktions‑ sowie Technik‑Workflows überführbar.

Die Messlatte: Offizielle Leitplanken und belastbare Evidenz

- Google beschreibt in „KI‑Funktionen und deine Website“, wie Inhalte für AI‑Features aufbereitet werden sollten (u. a. Indexierbarkeit, klare Snippets, strukturierte Daten). Entscheidend ist Nutzermehrwert, nicht Tricks. Siehe die Seite KI‑Funktionen in der Suche bei Google Search Central (2025).

- Änderungen an AI‑Features dokumentiert Google im Search‑Documentation Updateverlauf (2025). Die Auswahl von Quellen für AI Overviews bleibt proprietär; es existiert keine öffentliche „Formel“.

- Die Prinzipien „hilfreicher Inhalte“ sind in die Kernbewertung eingeflossen; die Hinweise zum August‑Update skizzieren Erwartungen an Originalität, Vertrauenssignale und Richtlinieneinhaltung. Vgl. Google Search Blog zum August‑Update (2024).

- E‑E‑A‑T dient als Qualitätsrahmen in den Search Quality Evaluator Guidelines – kein direkter Rankingfaktor, aber für die Beurteilung und Entwicklung der Suche relevant. Primärdoku: Google Search Quality Evaluator Guidelines (aktuelle PDF).

- Zu Perplexity: Das Produkt zeigt Quellen im Interface; offizielle, umfassende Zitier‑Policy als eigenständige Help‑Seite ist nicht kanonisch dokumentiert. Orientierung bietet der Perplexity Getting‑Started‑Hub. Aussagen hierzu sollten vorsichtig formuliert werden.

Kurz: Für GEO zählt belegt hilfreicher, zitierfähiger Content. Offizielle Quellen liefern Prinzipien und technische Leitplanken; harte „Rankingformeln“ bleiben bewusst intransparent.

Audit‑Framework Schritt für Schritt

Ein praxistauglicher Audit macht Qualität greifbar und wiederholbar. Vorgehen in sechs Etappen:

- Scope & Ziele: Themenkern, Ziel‑Prompts (30–50 je Cluster) und Ziel‑Entitäten definieren; IST‑Sichtbarkeit in AIO/LLMs messen.

- Inventur & ROT: Inhaltsinventar mit Traffic, Backlinks, Aktualität, E‑E‑A‑T‑Signalen, Markup‑Status; redundante, veraltete, triviale Inhalte markieren.

- Gaps & Priorisierung: Fragenabdeckung („Questions‑First“), Entitätenlücken, Autoren‑Credibility, fehlende Primärquellen identifizieren; Impact × Aufwand bewerten.

- Maßnahmenplanung: Aktualisieren, Zusammenführen, Entfernen oder Neu erstellen; Markup‑Backlog; interne Linkknoten; Autor:innen zuordnen.

- Implementierung: Redaktionskalender, technisches Ticketing (Schema, CWV, Sitemaps), QA‑Checkliste; Veröffentlichung in Wellen.

- Monitoring: AICS, PCR, Sentiment, Schema‑Effekt, Freshness Impact über definierte Prompts und Plattformen longitudinal tracken.

Checkliste für die Durchführung:

- Definieren Sie eine Prompts‑Liste je Cluster mit klarer Suchintention.

- Führen Sie eine ROT‑Bereinigung mit dokumentierten Entscheidungen durch.

- Ergänzen Sie Autorenboxen inkl. Qualifikation, Quellenapparat und Aktualisierungsdatum.

- Implementieren und validieren Sie FAQ/HowTo/Article‑Schema; prüfen Sie Indexierbarkeit.

- Setzen Sie interne Links von Grundlagen zu Deep‑Dives und Glossaren.

- Tracken Sie AICS, PCR und Sentiment pro Quartal – je Plattform getrennt.

GEO‑taugliche Content‑Elemente, die tatsächlich zitiert werden

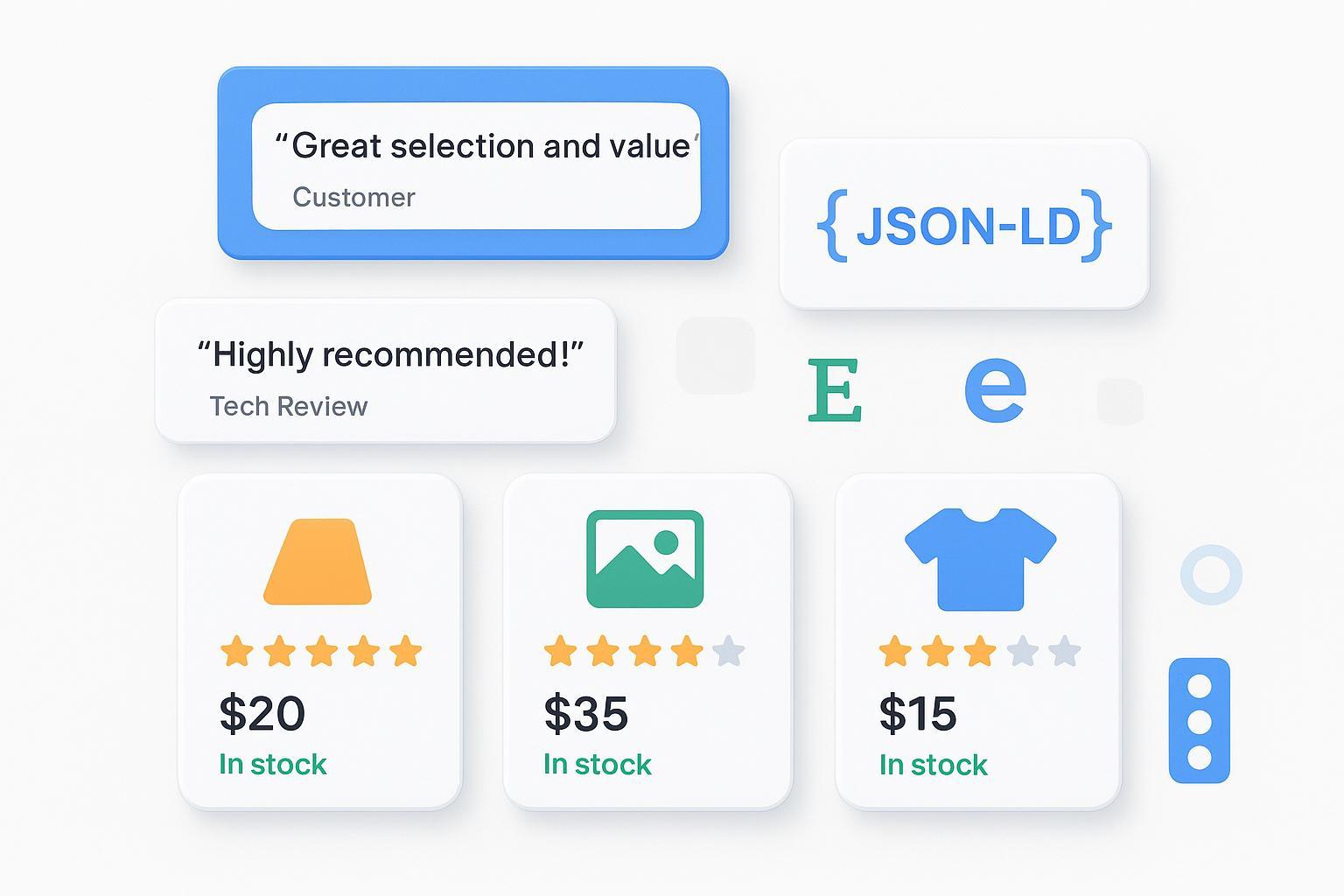

Antwortreife Passagen sind kurz, präzise und gut referenzierbar. Q&A‑Module, kompakte Definitionen, Tabellen und How‑Tos helfen generativen Systemen beim Extrahieren. Ebenso wichtig: eindeutige Entitäten (einheitliche Namen, IDs, Schema.org‑Konnektoren) und sichtbare Autor:innen‑Kompetenz.

| Element | Zweck | GEO‑Nutzen |

|---|---|---|

| Q&A‑Block (≤300 Zeichen Antwort) | Schnelle, klare Antworten auf Kernfragen | Erhöht die Wahrscheinlichkeit, als zitierfähiges Snippet in AIO/LLMs zu erscheinen |

| FAQ/HowTo‑Schema | Strukturierte, maschinenlesbare Anleitung | Begünstigt maschinelle Extraktion; bessere Kontextzuordnung |

| Autorenbox + Quellen | Sichtbarkeit von Erfahrung/Expertise | Stärkt E‑E‑A‑T; steigert Trust und Zitierfähigkeit |

| Glossar/Definitionstabellen | Kanonische Begriffsführung & Entitätenpflege | Reduziert Ambiguität; erleichtert Entitäten‑Mapping |

| Aktualitäts‑Hinweis + Änderungslog | Transparenz über Freshness | Korrelation mit Zitationsfrequenz prüf‑ und steuerbar |

Kleiner Praxis‑Tipp: Denken Sie in Fragen, nicht nur in Keywords. Kurze, zitierfähige Sätze – gern mit konkreten Zahlen – sind die „Anker“, die LLMs gerne aufgreifen.

Monitoring und KPIs: Von AICS bis Sentiment

Diese Metriken haben sich für GEO bewährt:

- AI Citation Share (AICS): Anteil der Antworten zu Ihren Kernfragen, in denen Ihre Domain/Marke verlinkt/zitiert wird.

- Prompt Coverage Rate (PCR): Abdeckung der definierten Prompts durch Erwähnungen/Zitate in den Zielsystemen.

- Positioning Depth: Prominenz Ihrer Quelle im Antwortkasten (Hauptquelle vs. „weiterführend“).

- Sentiment: Tonalität der Erwähnungen (positiv/neutral/negativ) – wichtig für Reputation und Conversion‑Reife.

- Freshness Impact: Zusammenhang zwischen Update‑Datum und Zitationshäufigkeit.

- Schema Markup Effectiveness: Zusammenhang zwischen Markup‑Implementierung und AICS/PCR.

Eine kompakte Einführung und KPI‑Beispiele finden Sie im internen Leitfaden von Geneo: AI Sichtbarkeit KPIs 2024 – Best Practices für Markenerwähnungen & Citations.

Praxisblock: Beispiel‑Workflow mit Geneo (Disclosure)

Disclosure: Geneo ist eine Plattform für AI‑Sichtbarkeit und Monitoring von Markenerwähnungen, Zitierungen und Sentiment über Google AI Overviews/AI‑Mode, ChatGPT‑basierte Suchmodi und Perplexity.

So könnte ein GEO‑Monitoring mit Geneo aussehen:

- Setup: Definieren Sie je Themencluster 30–50 Kern‑Prompts (informational, transactional, Vergleich). Hinterlegen Sie Ziel‑Entitäten (Marke, Produkt, Branchenterms) und Synonyme.

- Tracking: Geneo prüft täglich, ob und wo Ihre Marke zitiert oder erwähnt wird, ordnet das Sentiment zu und speichert die Historie. Alerts informieren bei Einbrüchen oder negativen Sentiment‑Spitzen.

- KPI‑Dashboard: Beobachten Sie AICS, PCR, Sentiment‑Trend, Plattform‑Mix (Google AIO/AI‑Mode, ChatGPT‑Suche, Perplexity) sowie Top zitierende Domains. Exportieren Sie die Daten für Quartals‑Reviews.

- Audit‑Loop: Bei niedriger PCR aktualisieren/vereinheitlichen Sie Q&A‑Blöcke, ergänzen Quellen, stärken Autorenprofile, ziehen Schema‑Daten nach und konsolidieren ROT‑Kandidaten. Die Effekte messen Sie erneut über Geneo.

Hinweis: Dieser Workflow ist exemplarisch, kein Hard‑Sell. Entscheidend ist die saubere Operationalisierung vom Audit bis zum Monitoring – Tool‑agnostisch umsetzbar.

Häufige Fehler und schnelle Korrekturen

- Zu lange, unstrukturierte Absätze ohne zitierfähige Kernaussagen → kurze Q&A‑Module und Definitionen einfügen; Zahlen sichtbar machen.

- Fehlende Autoren‑Credibility → Autorenboxen mit Qualifikation, Publikationen und Profil‑Links ergänzen; Peer‑Review bei sensiblen Themen.

- Kein oder fehlerhaftes Schema → FAQ/HowTo/Article/Organization/Person korrekt implementieren und validieren.

- ROT‑Ballast bleibt bestehen → Redundantes zusammenführen, Obsoletes aktualisieren oder deindexieren, Triviales entfernen.

- Keine Prompt‑Systematik → Fragenliste je Cluster pflegen, regelmäßig gegen echte Nutzerfragen spiegeln.

Handlungspfad für die nächsten 30 Tage

Tag 1–5: Prompts‑ und Entitäten‑Set definieren; Inhaltsinventur starten; ROT‑Kriterien festlegen.

Tag 6–15: E‑E‑A‑T‑Lücken schließen (Autorenboxen, Quellen, Aktualitäts‑Hinweise); Schema‑Implementierung priorisieren; 3–5 High‑Impact‑Seiten überarbeiten.

Tag 16–25: Q&A‑Blöcke, Glossar‑Einträge und interne Links ergänzen; technische Hygiene (Indexierbarkeit, Sitemaps, CWV) prüfen.

Tag 26–30: Monitoring aufsetzen (AICS, PCR, Sentiment, Freshness Impact, Schema‑Effekt); erste Review‑Schleife planen.

Kleiner Anstoß zum Schluss: Wollen Sie GEO‑KPIs sauber messen und als Score in Ihre Redaktions‑Roadmap bringen? Testen Sie Geneo unverbindlich – die Einrichtung dauert meist weniger als eine Stunde.

Quellen und weiterführende Leitfäden:

- Offizielle Orientierung zu AI‑Features: Google Search Central – KI‑Funktionen und deine Website (2025)

- Dokumentations‑Updates und AI‑Mode‑Hinweise: Google Search – Updates (2025)

- „Helpful Content“ in Core‑Bewertungen: Google Search Blog – August‑Update (2024)

- Qualitätsrahmen: Google Search Quality Evaluator Guidelines – E‑E‑A‑T (aktuelle PDF)

- Produkt‑Hinweise/Orientierung zu Zitaten im UI: Perplexity – Getting Started