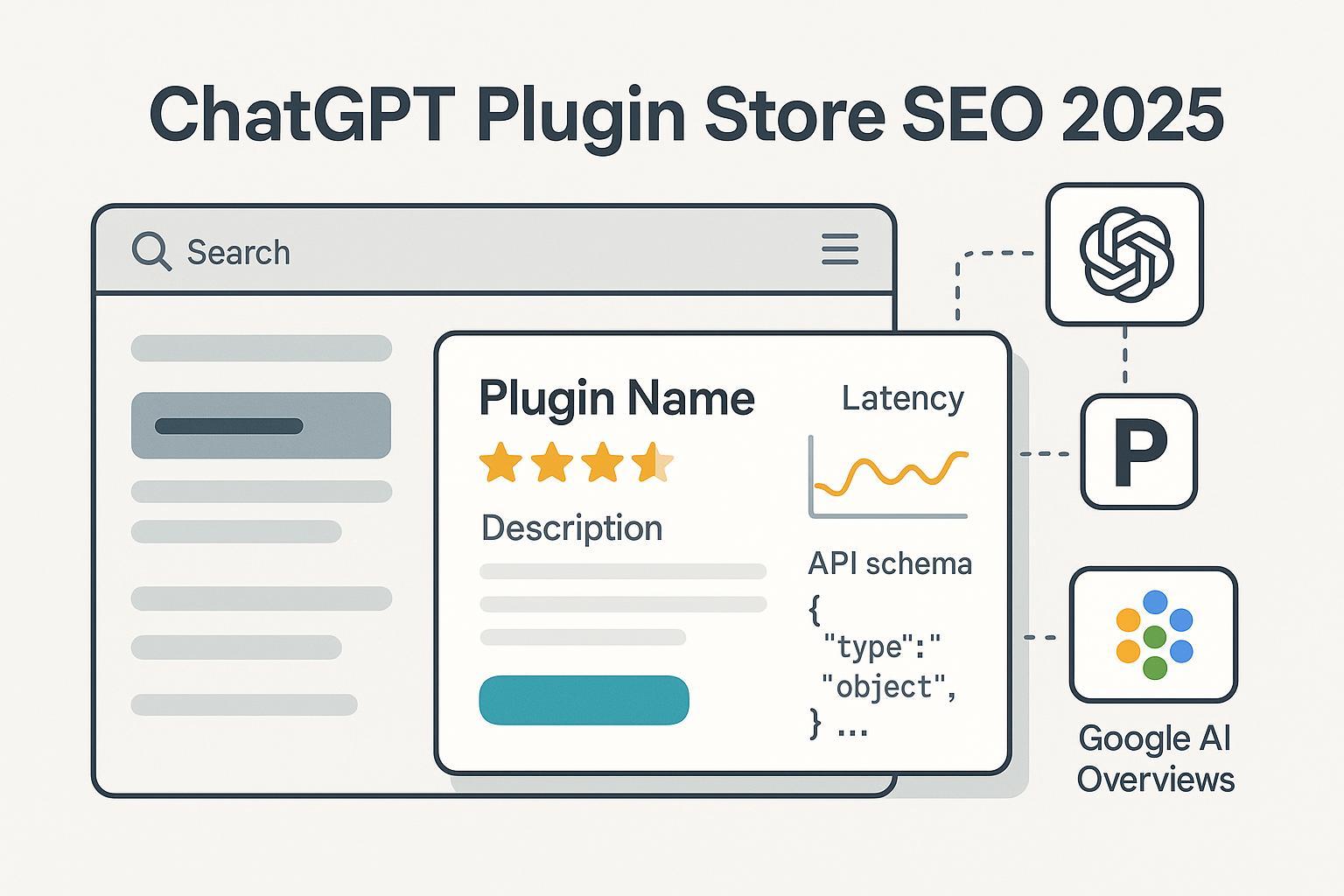

Best Practices 2025: ChatGPT Plugin Store SEO für Profis

Aktuelle SEO-Strategien 2025 für den ChatGPT Plugin Store: Listing-Optimierung, Ranking-Faktoren, Geneo-Monitoring und umsetzbare Methoden für Entwickler und Marken.

Wenn Sie 2025 ein ChatGPT‑Plugin (Custom GPT mit Actions) veröffentlichen, konkurrieren Sie nicht nur mit anderen guten Ideen, sondern mit hunderten ähnlicher Listings. In diesem Leitfaden teile ich praxisbewährte Schritte aus aktuellen Projekten: klare Maßnahmen, technische Stellschrauben und eine Betriebsroutine, die Sichtbarkeit und Nutzung systematisch steigert – ohne Mythen über „geheime Algorithmen“.

Wichtiger Hinweis vorab: OpenAI veröffentlicht keine detaillierten Ranking‑Algorithmen des GPT Stores. Verlässliche Optimierung stützt sich deshalb auf offizielle Richtlinien, UX‑Signale und belastbare Analogie‑Erfahrungen aus App‑Stores. Wo ich aus Analogie ableite, kennzeichne ich das explizit.

1) Was sich 2024–2025 verändert hat – und warum es für SEO zählt

- Der GPT Store bündelt öffentlich geteilte GPTs; Sichtbarkeit entsteht über Suche, Kategorien und gelegentlich redaktionelles Featuring. OpenAI beschreibt Setup, Veröffentlichung und Prüfprozess in den offiziellen Anleitungen in „Introducing the GPT Store (2024/2025)“.

- Modelle und Fähigkeiten (z. B. GPT‑4o/o3) wurden erweitert, was die Nutzbarkeit und damit die Chance auf positive Signale beeinflusst; Details finden sich in den fortlaufenden „ChatGPT Release Notes (OpenAI Help Center, 2024–2025)“.

- Custom GPTs können „Actions“ (externe APIs) nutzen. Für die Veröffentlichung sind klare technische und Compliance‑Anforderungen zu erfüllen, wie in „Building and publishing a GPT (OpenAI Help Center, 2024/2025)“ beschrieben.

Konsequenz: Discoverability hängt heute stark von drei Bereichen ab: (a) Listing‑Relevanz und Klarheit, (b) Nutzererlebnis/Performance und (c) Policy‑Compliance. Alles drei können Sie konkret beeinflussen.

2) Ranking- und Discoverability‑Signale: Was wir wissen – und was wir ableiten

Dokumentiert

- Relevanz im Listing: Felder wie Name, Beschreibung, Starterfragen und Kategorie fließen in die Store‑Darstellung ein. OpenAI betont klare Instruktionen und Prompts, um die Nutzung zu erleichtern, siehe „Key guidelines for writing instructions for Custom GPTs (2024/2025)“ und „Building and publishing a GPT“.

- Qualität/Vertrauen: Verstöße gegen die „Usage Policies (OpenAI, 2025)“ oder die „Service Terms (OpenAI, 2025)“ gefährden Sichtbarkeit (De‑Listing, Sperren). Saubere Privacy‑Angaben sind Pflicht, siehe „OpenAI Privacy Policy (2025)“.

- Redaktionelle Platzierung: OpenAI benennt Kriterien wie Innovation, UX, Performance und ethische Nutzung in „Getting your GPT featured (Help Center, 2024/2025)“.

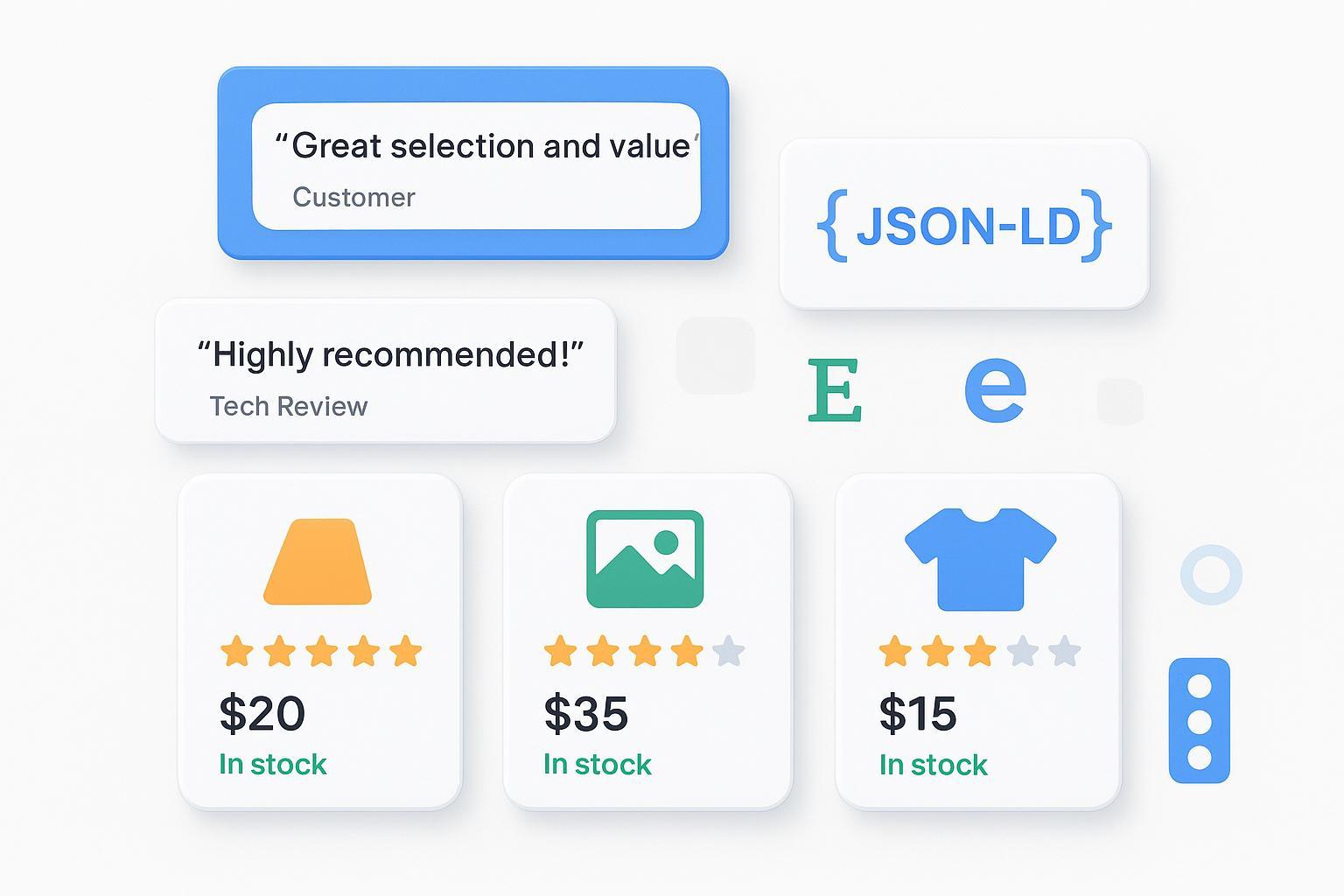

Abgeleitet (App‑Store‑Analogie, 2019–2024 Belege)

- Titel/Keywords steigern Auffindbarkeit; hochwertige Visuals verbessern Conversion; Bewertungen/Reviews korrelieren mit Installationsraten. Diese Effekte sind in App‑Store‑Studien dokumentiert, z. B. „App Store Screenshots beeinflussen Conversion (AppsFlyer, 2023)“ und „CTR als Hebel für Impression‑zu‑Klick (AppsFlyer, 2022)“.

Praxisableitung (mit Caveat): Optimieren Sie Listing‑Relevanz und ‑Konversion, reduzieren Sie Reibung in der Erstnutzung und halten Sie Policies strikt ein. Das sind die verlässlichsten Stellhebel, solange es keine offiziellen Ranking‑Signale gibt.

3) Technische Fundamente für Actions: Was direkt auf Sichtbarkeit einzahlt

Warum Technik für „SEO“? Weil technische Qualität das Nutzungserlebnis bestimmt – und Nutzung/Reaktionen (z. B. Reviews) sind die stärksten indirekten Signale.

Konkrete Best Practices

- OpenAPI minimal und eindeutig: Definieren Sie nur notwendige Endpunkte, vergeben Sie klare operationId‑Namen und eindeutige Parameter. Hinweise und Beispiele liefert die „GPT Actions Library (OpenAI Cookbook, 2024/2025)“.

- Eine konsistente Authentifizierung: Nutzen Sie ein Security‑Schema (OAuth2 oder API‑Key) und vermeiden Sie parallele Schemes – eine bekannte Limitation ist in der Community dokumentiert: „Double‑Auth‑Issue für OpenAPI 3.1 in GPT Actions (Community, 2024)“.

- Fehler- und Timeout‑Handling: Verwenden Sie korrekte HTTP‑Statuscodes, strukturierte Fehlermeldungen, Timeouts und Retries. In den Actions‑Instruktionen des GPTs beschreiben Sie, was bei Fehlern passieren soll (z. B. Retry, Nutzerhinweis), vgl. „GPT Actions Library (Cookbook)“.

- Latenzziele: Für interaktive Chats ist p95 unter 1–2 s ein guter Zielkorridor. Lange Prozesse als Jobs auslagern und Polling‑Endpoints bereitstellen. Offen diskutiert in OpenAI‑Beispielen und gängigen Web‑Perf‑Standards; direkte Store‑Vorgaben existieren nicht, dennoch gilt: schnell schlägt langsam.

- Sicherheit & Privatsphäre: Vermeiden Sie sensible Datenverarbeitung in Actions; verlinken Sie eine Privacy‑Policy‑URL und verifizieren Sie Ihre Domain, wie im „Building and publishing a GPT‑Leitfaden (2024/2025)“ beschrieben.

Messgröße, die zählt: Senken Sie p95‑Latenz und Fehlerraten (4xx/5xx). Teams, die von p95≈3,5 s auf ≈1,8 s gekommen sind, sehen erfahrungsgemäß deutlich höhere Task‑Abschlussraten und bessere Bewertungen.

4) Listing-Optimierung, die wirkt: Titel, Beschreibung, Starterfragen, Kategorie, Visuals

So setzen Sie in 60–90 Minuten ein belastbares Listing 1.0 auf:

- Titel in 3–5 Wörtern: Nutzen/Aufgabe klar benennen, optional 1 Haupt‑Keyword. Beispiel: „YouTube Transcript Summarizer“ statt „AI Video Helper“. Diese Klarheit fördert Trefferrelevanz und Aktivierung; OpenAI empfiehlt explizite Instruktionen und Anwendungsfälle in den „Guidelines für Custom‑GPT‑Instruktionen (2024/2025)“.

- Beschreibung (erste 160–200 Zeichen): In einem Satz Problem, Zielnutzen und Differenzierung. Danach 3–5 Feature‑Bullets mit konkreten Ergebnissen (Zeitersparnis, Formate, Integrationen). Die klare Nutzenführung erhöht Conversion – ein Prinzip, das in ASO‑Analysen immer wieder sichtbar wird, vgl. „AppsFlyer zu Conversion‑Hebeln (2023)“.

- Starterfragen (3–5 Stück): Realitätstreue, präzise Prompts, die typische Aufgaben exakt spiegeln. OpenAI betont Starterprompts und klare Onboarding‑Instruktionen in „Building and publishing a GPT (2024/2025)“.

- Kategorie: Am Use Case orientiert, nicht am Tech‑Stack. Inkonsistente Kategorisierung schwächt Relevanzsignale.

- Visual/Icon: Marken‑konsistent, kontrastreich und gut lesbar. Direkte Store‑Daten fehlen, aber aus App‑Stores ist der starke Einfluss auf Conversion gut belegt, siehe „AppsFlyer Screenshot‑Einfluss (2023)“.

Template‑Beispiel (de/englisch, adaptierbar)

- Titel: „Privacy‑sicherer Meeting‑Notiz‑Assistent“

- Intro (≤200 Zeichen): „Erstellt präzise Meeting‑Notizen mit verifizierten Quellen, datenschutzfreundlich, in Sekunden. Export in Markdown/CRM, inkl. Action‑Anbindung an Ihre Kalender‑API.“

- Starterfragen:

- „Fasse dieses 45‑min‑Meeting in 6 Entscheidungs‑Punkten zusammen.“

- „Erstelle Aufgaben mit Verantwortlichen und Fristen aus diesem Protokoll.“

- „Synce die Ergebnisse in HubSpot und markiere ‚Follow‑up nötig‘.“

5) Messen trotz begrenzter Store‑Analytics: So bauen Sie Ihr KPI‑System

Offizielle, detaillierte Analytics (Impressions, CTR) für den GPT Store sind öffentlich nicht dokumentiert (Stand 2025). Arbeiten Sie mit externen Proxies und Ihren eigenen Logs:

- Aktivierungen/Erstnutzung: Leiten Sie Nutzer – wenn sinnvoll – auf eine kurze, optionale Onboarding‑URL (z. B. Hilfeartikel oder Demo‑Video) und messen Sie Klicks/Verweildauer. Achtung: Keine manipulativen Funnels; Policies beachten, vgl. „Service Terms (OpenAI, 2025)“.

- Engagement: Messen Sie DAU/MAU, Session‑Länge, Task‑Success‑Rate über Ihre API‑Logs (Actions). Strukturierte Fehlerpayloads helfen bei Ursachenanalyse, siehe „GPT Actions Library (OpenAI Cookbook, 2024/2025)“.

- Technische Qualität: p50/p95‑Latenz, 4xx/5xx‑Fehlerraten, Timeout‑Rate pro Endpoint.

- Zufriedenheit: Beobachten Sie Ratings/Reviews, sofern sichtbar; sammeln Sie qualitatives Feedback über Support/Foren.

- Conversion‑Proxies: Nutzen Sie A/B‑Varianten Ihrer externen Doku/Video‑Previews, um die Wirkung von Titel/Visuals zu testen. Der Zusammenhang von Visuals/Copy und CTR ist in App‑Store‑Kontexten beschrieben, z. B. „CTR‑Definition und Einflussfaktoren (AppsFlyer, 2022)“.

6) 30–60–90‑Tage‑Playbook (operativ)

0–30 Tage: Fundament legen

- Policy‑Check & Risikoanalyse: Prüfen Sie „Usage Policies (OpenAI, 2025)“ und „Service Terms (2025)“, entfernen Sie heikle Funktionen.

- Technische Härte: OpenAPI schlank, Auth klar, Fehler/Timeouts definiert; Ziel p95<1–2 s, vgl. Best‑Practice‑Hinweise in der „GPT Actions Library (Cookbook)“.

- Listing 1.0: Titel/Description/Starterfragen erstellen; Kategorie und Icon setzen; klare Onboarding‑Instruktion.

- Telemetrie: API‑Dashboards für Latenz/Fehler; Support‑Workflow einrichten.

31–60 Tage: Iterieren

- Copy‑A/B: Variieren Sie Titel‑Phrase oder Intro‑Block (eine Änderung pro Iteration, 7–10 Tage laufen lassen).

- Starterfragen erweitern: Fügen Sie 2–3 Prompts für Top‑Aufgaben hinzu; beobachten Sie Task‑Success‑Rate.

- Performance‑Spitzen glätten: Caching, Pagination, Batch‑Requests; Fehlercodes standardisieren.

- Feedback‑Schleife: Top‑10 Supporttickets in die Roadmap.

61–90 Tage: Skalieren

- Features erweitern: Actions für häufige Nutzerwünsche; Changelog im Listing nennen.

- „Getting featured“: Kriterien prüfen und bewerben gemäß „OpenAI‑Guidelines (2024/2025)“.

- Reichweite erhöhen: Demos, kurze Videos, Community‑Posts – qualifizierte externe Signale steigern Markenvertrauen.

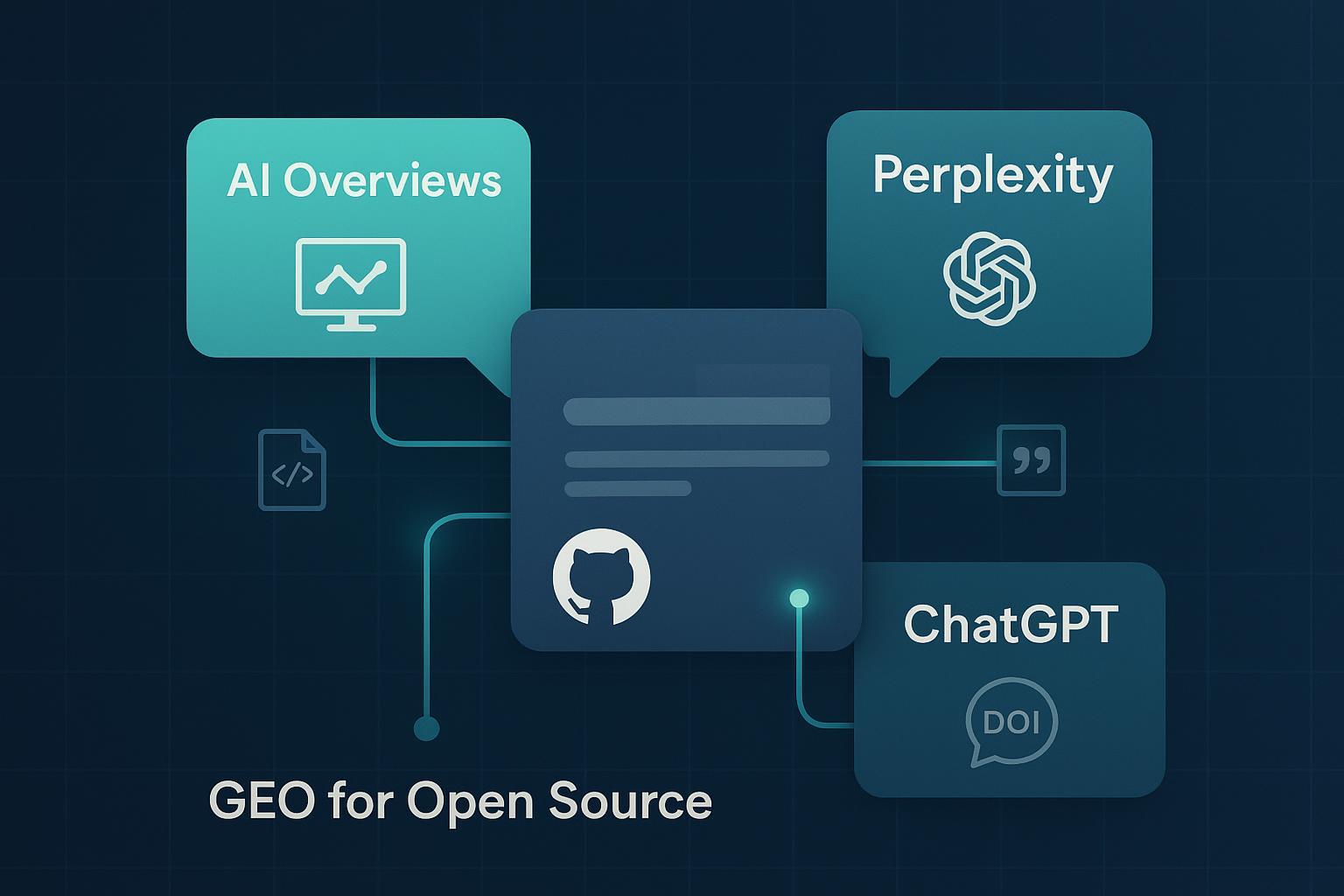

7) Geneo in der Praxis: AI‑Sichtbarkeit und Marken‑Signale als Kompass

Warum Geneo? Der GPT Store bietet (noch) nur begrenzte Einblicke. Geneo hilft, Ihre Sichtbarkeit und Wahrnehmung in generativen Plattformen ganzheitlich zu erfassen – inklusive ChatGPT‑Antworten, Perplexity und Google AI Overviews.

So setzen Teams Geneo entlang des SEO‑Zyklus ein

- Baseline anlegen: Hinterlegen Sie marken‑/funktionsrelevante Suchphrasen (z. B. „Best meeting notes GPT“, „YouTube summarizer GPT“) und erfassen Sie, ob und wie Ihr GPT in Antworten erwähnt wird. Geneo trackt Erwähnungen, relative Rankings und Sentiment quer über Plattformen, inkl. Zeitreihen. Produktinfos: https://geneo.app

- Listing‑Iteration: Nutzen Sie die Content‑Optimierungsvorschläge in Geneo, um Titel/Intro/Starterfragen datenbasiert zu schärfen. Änderungen dokumentieren, 14 Tage laufen lassen, Trends vergleichen.

- Technik als Hebel: Korrelieren Sie Geneo‑Trends (Erwähnungen/Sentiment) mit API‑Metriken (p95/Fehler). Beispiel: Nach Caching‑Einführung sinkt p95 um 30 % – prüfen Sie, ob Geneo mehr positive Erwähnungen und Aufgaben‑Abschlüsse anzeigt.

- Wettbewerbs‑Benchmark: Mit Multi‑Brand‑Management Wettbewerber‑Phrasen und typische Nutzerfragen erkennen; diese in Starterfragen/FAQ aufnehmen.

- Review‑Cadence: Alle 14 Tage Review mit Geneo‑Reports + API‑Dashboards; daraus konkrete Hypothesen für die nächste Iteration ableiten.

Wichtig: Geneo ersetzt keine Store‑Internals – es schafft belastbare Proxies für Sichtbarkeit und Markenwahrnehmung in generativen Antworten. Für Teams mit mehreren GPTs/Marken vereinfacht die Multi‑Brand‑Ansicht die Priorisierung.

8) Häufige Fehler und Trade‑offs (aus Projekterfahrung)

- Überladene OpenAPI‑Schemas: Viele Endpunkte, unklare Parameter – das Modell agiert unsicherer, Fehlerraten steigen. Besser: wenige, eindeutige Actions. Siehe Struktur‑Hinweise in der „GPT Actions Library (Cookbook, 2024/2025)“.

- Unklare Beschreibung/fehlende Starterfragen: Hohe Impressions, niedrige Aktivierungen. OpenAI empfiehlt klare Onboarding‑Instruktionen, vgl. „Custom‑GPT‑Guidelines (2024/2025)“.

- Latenz >2–3 s p95: Abbrüche und negative Rückmeldungen nehmen zu – priorisieren Sie p95‑Optimierungen.

- Policy‑Verstöße: Sensible Daten, medizinische/finanzielle Beratung ohne Absicherung, politisches Campaigning – führen zu De‑Listing. Details in den „Usage Policies (2025)“.

- Over‑Engineering: Features ohne Nachfrage binden Ressourcen; werten Sie zuerst Supporttickets, API‑Nutzung und Geneo‑Sentiment aus.

9) Compliance‑Check vor dem Launch

- Zweck & Zielgruppe: Überprüfen Sie, ob Ihr Use Case innerhalb der „Usage Policies (OpenAI, 2025)“ liegt.

- Datenschutz: Verlinken Sie eine verständliche, aktuelle Privacy Policy; verarbeiten Sie keine sensiblen Daten über Actions, vgl. „Privacy Policy (OpenAI, 2025)“.

- Domain & Auth: Verifizieren Sie die Domain, nutzen Sie ein klares Auth‑Schema; siehe „Building and publishing a GPT (Help Center, 2024/2025)“.

- Fehlerkultur: Definieren Sie Fehlermeldungen, Timeouts und Nutzerhinweise; vermeiden Sie „stille“ Fehler.

- Redaktionschance: Prüfen Sie die Kriterien in „Getting your GPT featured (2024/2025)“ und gleichen Sie UX/Performance ab.

10) Betriebsroutine: Der Cadence‑Plan, der in der Praxis funktioniert

Wöchentlich

- API‑Gesundheit prüfen (p95, 4xx/5xx, Timeouts) und Top‑3 Ursachen beheben.

- Geneo‑Kurzcheck: Erwähnungen/Sentiment‑Trend je Query‑Cluster.

14‑tägig

- Eine Listing‑Änderung (Titel‑Phrase, Intro‑Satz oder 1–2 Starterfragen) gezielt testen; Effekte nach 14 Tagen bewerten.

- Support‑Feedback sichten; häufige Fragen in Starterfragen/FAQ überführen.

Monatlich

- Feature‑Roadmap vs. Nutzungsdaten abgleichen; ggf. 1 neue Action für den Top‑Use‑Case.

- Bewerbung für Featurings prüfen und ggf. aktualisiert einreichen, entlang „Getting your GPT featured (Help Center)“.

11) Kompakte To‑Do‑Checkliste

- [ ] Usage Policies & Service Terms geprüft; Risiko‑Map erstellt

- [ ] OpenAPI minimiert; ein Auth‑Schema; Fehler/Timeouts sauber definiert

- [ ] Titel‑Keyword festgelegt; Intro‑Description (160–200 Zeichen) optimiert

- [ ] 5 Starterfragen formuliert; Onboarding getestet

- [ ] Kategorie passgenau gewählt; konsistentes Icon

- [ ] p50/p95‑Latenz und Error‑Rate Dashboard aktiv

- [ ] Feedback‑Kanal (Support/Forum/Survey) eingerichtet

- [ ] „Getting featured“ Kriterien erfüllt und eingereicht

- [ ] Geneo‑Tracking für Queries/Sentiment aktiv; 14‑tägige Review‑Cadence

Fazit

ChatGPT‑Plugin‑SEO 2025 ist weniger „Keyword‑Magie“ als solides Produkt‑ und Betriebshandwerk: sauberes Listing, schnelle und robuste Actions, klare Starterprompts, disziplinierte Iteration – und ein Messsystem, das Wirkungen erkennt, obwohl der Store selbst wenig Analytics zeigt. Wer diese Basics verlässlich betreibt, wird sichtbar.

Wenn Sie mehrere Marken/GPTs steuern oder Ihre AI‑Sichtbarkeit systematisch messen wollen, testen Sie Geneo für Monitoring, Sentiment‑Analyse und Content‑Optimierungsvorschläge: https://geneo.app

Quellen (Auswahl, primäre/canonische Dokumente)

- OpenAI – „Introducing the GPT Store (2024/2025)“

- OpenAI Help Center – „ChatGPT Release Notes (laufend seit 2023, Stand 2025)“

- OpenAI Help Center – „Building and publishing a GPT (2024/2025)“

- OpenAI Help Center – „Getting your GPT featured (2024/2025)“

- OpenAI – „Usage Policies (2025)“ und „Service Terms (2025)“

- OpenAI – „Privacy Policy (2025)“

- OpenAI Cookbook – „GPT Actions Library (2024/2025)“

- Community – „Double‑Auth‑Issue bei OpenAPI 3.1 (2024)“

- AppsFlyer – „App Store Screenshots: Conversion‑Einfluss (2023)“, „CTR – Definition & Einfluss (2022)“