Best Practices 2025: Landingpages für KI-Übersichtssnippets optimieren

Aktuelle Best Practices 2025 für die Optimierung von Produkt- & Service-Landingpages für KI-Übersichtssnippets (Google AI Overviews, Perplexity). So steigern Profis Sichtbarkeit & Zitation.

Wenn Ihre Landingpages nicht in KI‑Antworten auftauchen, verlieren Sie Sichtbarkeit – und oft auch Klicks. 2025 werden strukturierte, zitierfähige Abschnitte (Listen, Tabellen, prägnante Q&As) überproportional häufig in Google AI Overviews extrahiert und verlinkt, wie Analysen zeigen (siehe etwa die Hinweise zu „Listen/Tabellen/FAQs“ in der Studie von SEMrush, März 2025, sowie praxisnahe Auswertungen bei Backlinko und SISTRIX). Google selbst verweist auf hilfreiche Inhalte und strukturierte Darstellung als Qualitätskriterium in seinen Entwicklerressourcen.

Ziel dieses Leitfadens: ein praxiserprobtes Vorgehen, mit dem Produkt‑ und Service‑Landingpages konsequent für KI‑Übersichtssnippets (Google AI Overviews, Perplexity, ChatGPT‑Browsing) aufgebaut, gemessen und iteriert werden.

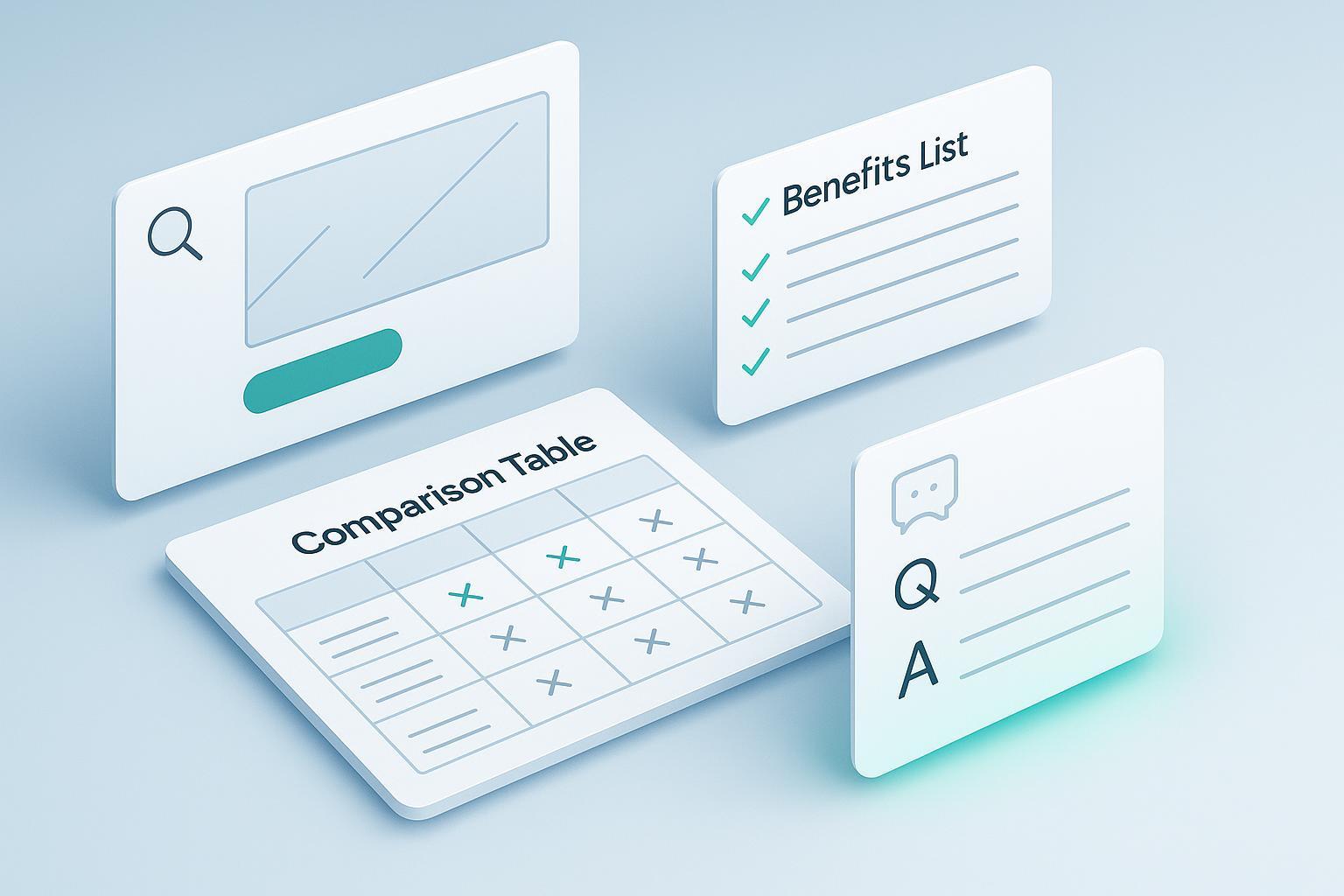

Die 5 Bausteine einer snippet‑fähigen Landingpage

- Modularität & Chunking

- Arbeiten Sie mit klar abgegrenzten Sektionen (H2/H3): Hero‑Kurzantwort, Nutzenliste, Vergleichstabelle, FAQ, Vertrauenssignale.

- Halten Sie Antwortblöcke kompakt: 40–80 Wörter für eine FAQ‑Antwort; 3–7 Punkte pro Liste.

- Nutzen Sie semantische Zwischentitel, die reale Nutzerfragen spiegeln (z. B. „Wie funktioniert …?“, „Was kostet …?“). Hinweise aus Praxisanalysen belegen, dass sauber „chunkt“ strukturierte Seiten häufiger zitiert werden, u. a. in den Beiträgen zu Ranking‑Mustern in Google‑KI‑Übersichten von Ninepeaks (2025) und Seoprofy (2024).

- Intent‑Klarheit vor Tiefe

- Ordnen Sie jeden Abschnitt einem Intent zu: Informieren, Vergleichen, Preis/Leistung, Implementierung, Risiken.

- Beginnen Sie mit der Kurzantwort (1–2 Sätze), dann folgen Details und Belege. Dieses „Answer‑first“-Muster erhöht die direkte Zitierfähigkeit, wie zahlreiche Praxisbeobachtungen zu AI Overviews zeigen.

- Strukturierte Antworten, die Bots lieben

- Formate, die bevorzugt extrahiert werden: Listen/Checklisten, Tabellen, FAQs und Schritt‑für‑Schritt‑Anleitungen. Diese Muster werden für AI Overviews wiederholt als wirksam beschrieben, u. a. in der SEMrush‑Studie von 03/2025 und den Leitfäden von Backlinko und SISTRIX.

- Hinterlegen Sie – wo sinnvoll – strukturierte Daten (FAQPage, Product/Service, HowTo). Google beschreibt Snippet‑Steuerungen und Darstellungsprinzipien in seinen Entwicklerdokumenten.

- Vertrauenssignale & Belege

- Integrieren Sie verifizierte Bewertungen, Zertifikate, Case‑Links und klare Verantwortlichkeiten. E‑E‑A‑T‑Signale (Erfahrung, Expertise, Autorität, Vertrauenswürdigkeit) zahlen nachweislich auf die Auswahl als Quelle ein – Google verweist seit 2024/2025 konsequent auf „helpful content“ und Qualitätsmerkmale in der Suche.

- Technische Hygiene & Snippet‑Kontrollen

- Indexierbarkeit, Ladezeit, Mobile UX, saubere Canonicals sind Pflicht.

- Prüfen Sie Robots‑ und Snippet‑Steuerungen:

nosnippet,max-snippet,data-nosnippet,noindex. Google erläutert diese Mechanismen inkl. Gültigkeit für KI‑Features in seinen Entwicklerressourcen.

Schritt‑für‑Schritt‑Workflow (vom Intent zur Iteration)

- Intent‑Cluster definieren

- Sammeln Sie die häufigsten Fragen entlang des Funnels (Information, Vergleich, Preis, Implementierung, Risiken).

- Erstellen Sie 5–8 Kernintents pro Landingpage.

- Modul‑Design pro Intent

- Hero: Kurzantwort (1–2 Sätze) + primärer CTA.

- Nutzenliste: 3–5 Bulletpoints mit konkreten Zahlen/Einheiten.

- Vergleichstabelle: Sie vs. Alternativen (transparent, fair).

- FAQ: 5–10 präzise Q&As mit 40–80‑Wort‑Antworten.

- Proof‑Blöcke: Zertifikate, Bewertungen, Case‑Studies.

- Tech/Compliance: SLA, Datenschutz, Kompatibilität.

- Strukturierte Daten & Markup

- Product/Service, FAQPage, HowTo (falls sinnvoll) ergänzen.

- Saubere URL‑Struktur; sichtbare „Aktualisiert am“-Angabe. Google führt in „AI Features“ und „Helpful Content“ die relevanten Grundlagen auf.

- Technischer Check

- Core Web Vitals, JS‑Rendering (Content nicht verstecken), keine störenden Interstitials/Paywalls auf Kernabschnitten.

- GPTBot/PerplexityBot/Googlebot zulassen, sofern Inhalte für KI‑Antworten genutzt werden dürfen. OpenAI dokumentiert die Steuerung für GPTBot; Perplexity beschreibt PerplexityBot und den Deep‑Research‑Modus in seinen Ressourcen.

- Veröffentlichung & KI‑Tests

- Prompts in Perplexity und ChatGPT ausführen und prüfen, ob Ihre Seite als Quelle auftaucht.

- In Google die Präsenz in AI Overviews tracken; SISTRIX bietet entsprechende Filter/Changelogs.

- Monitoring & Iteration (alle 4–12 Wochen)

- KPI‑Satz pflegen: AI Visibility Score, Zitierungen, Qualität der Quellen, modellierter Klick‑Impact.

- A/B‑Tests an Listen/FAQs/Tabellen; Heatmaps/Scrollmaps prüfen.

AI‑Readiness‑Checkliste (Kurzfassung)

- [ ] Sektionen klar, Q&A/Liste/Tabelle vorhanden

- [ ] Kurzantwortblöcke (40–80 Wörter) pro Frage

- [ ] FAQPage/Product/Service‑Schema korrekt

- [ ] „Aktualisiert am“ sichtbar; Canonicals korrekt

- [ ] Bots zugelassen; Snippet‑Kontrollen bewusst gesetzt

- [ ] Vertrauenssignale sichtbar (Bewertungen/Case‑Links)

Plattform‑Spezifika, die Sie kennen müssen

Google AI Overviews

- Erscheinung: Selektiv bei komplexen/informativen Anfragen; mit anklickbaren Quellen. Google erläutert Funktionsweise und Qualitätsprinzipien in den Beiträgen zur generativen Suche (2024/2025) sowie in der Entwicklerdoku zu AI‑Features und „Helpful Content“.

- Was wirkt: Listen, Tabellen, strukturierte Q&As, Schritt‑für‑Schritt‑Anleitungen; E‑E‑A‑T‑Signale. Die SEMrush‑Studie (03/2025) beziffert die AIO‑Rate im US‑Sample auf rund 13 % – v. a. bei informationalen Queries.

- Steuerung: Snippet‑Kontrollen (

nosnippet,max-snippet,data-nosnippet) undnoindexgreifen auch für KI‑Features laut Google‑Doku. Das Separate‑Opt‑out nur für AIO existiert nicht; „Google‑Extended“ steuert Trainingsnutzung, nicht Ranking/Index.

Perplexity (inkl. Deep Research)

- Bots & Zugriff: PerplexityBot respektiert robots.txt; Perplexity‑User kann als user‑initiierter Abruf agieren. Die offiziellen Guides nennen User‑Agent und Whitelist‑Optionen.

- Zitierlogik: Antworten zeigen prominent Quellen; Deep Research liest viele Quellen, bewertet Relevanz/Vertrauen. Transparente Kurzantworten + Belege erhöhen die Chance, verlinkt zu werden, wie der Produktblog beschreibt.

- Praxis‑Tipps: Q&A‑Blöcke mit Kurzantwort (1–2 Sätze) + Details; sichtbare Aktualisierungstermine; öffentliche Zugänglichkeit ohne Blocker; saubere Canonicals.

ChatGPT (Browsing/GPTBot)

- Steuerung: OpenAI beschreibt die Kontrolle von GPTBot über robots.txt und arbeitet an granularen Optionen (Media Manager).

- Darstellung: Quellenlinks erscheinen am Ende von Antworten; das Format variiert produktabhängig, es gibt keine formal standardisierte Zitierdarstellung. Planen Sie dennoch klar zitierfähige Abschnitte.

Praxisbeispiel: Ein Feature‑Abschnitt – vorher/nachher (kompakt)

Vorher (zu generisch)

Unsere Lösung ist führend in der Branche und bietet zahlreiche Vorteile für Unternehmen jeder Größe.

Nachher (snippet‑fähig)

- Kurzantwort: Die Lösung reduziert Onboarding‑Zeit um 32–45 % (gemessen an 1.000+ Accounts in 12 Monaten), dank geführter Checklisten und API‑Vorlagen.

- Liste (3 Punkte):

- Geführte Checklisten (9 Schritte) pro Use‑Case

- API‑Starterpakete (3 Sprachen), in 48 h einsatzbereit

- SLA 99,9 %, ISO‑27001‑Hosting in der EU

- FAQ (H3): Wie schnell bin ich live? – In der Regel in 7–10 Tagen, abhängig von Datenmigration und Rechtekonzept. Pilot startet nach 48 h mit Standardpaket.

So unterstützt ein KI‑Brand‑Monitoring‑Tool die Snippet‑Optimierung (Beispiel)

- Nutzen: Wöchentlich prüfen, ob Ihre Landingpages in KI‑Antworten (AIO, Perplexity, ChatGPT) zitiert werden; Sentiment und Historie beobachten; Content‑Gaps identifizieren.

- Umsetzung: Alert auf Keyword‑Cluster setzen, Zitierungen und Tonalität tracken, quartalsweise Content‑Refresh anhand der LLM‑Erwähnungen priorisieren.

- Tool‑Beispiel: Geneo überwacht Marken‑Erwähnungen in ChatGPT, Perplexity und Google AI Overviews, analysiert Sentiment und liefert Optimierungshinweise.

Transparenzhinweis: Geneo wird vom Herausgeber dieses Beitrags angeboten; das Beispiel dient der Veranschaulichung.

Toolbox: Monitoring & Research (kompakt)

- Geneo – AI‑Erwähnungen (ChatGPT/Perplexity/AIO), Sentiment, Historie, Content‑Empfehlungen; sinnvoll bei Multi‑Brand‑Setups.

- Brand24 – Stärken im Social Listening/Reporting; gut für breite Erwähnungserfassung außerhalb klassischer SERPs.

- Mention – Multi‑Plattform‑Monitoring plus Wettbewerbsanalyse; flexibel für Agenturen. Wahl nach Use‑Case: primäres Ziel (LLM‑Zitierungen vs. Social Listening), Integrationen und Teamgröße.

Messen, was zählt: KPIs & Workflow

Kern‑KPIs

- AI Visibility Score: Anteil der Zitierungen pro Keyword‑Set und Plattform.

- Citation Count & Quality: Anzahl und Autorität der verlinkten Quellen.

- Klick‑Impact (modelliert): Veränderung der organischen Sessions, wenn AIO/LLM‑Zitierungen zunehmen.

- Volatilität/Overlap: Quellenüberschneidungen über Zeit (z. B. Jaccard‑Index) zur Stabilitätseinschätzung.

Monitoring‑Rhythmus

- Wöchentlich: Stichproben in Perplexity/ChatGPT, AIO‑Tracker prüfen.

- Monatlich: Content‑Gaps schließen; FAQ/Liste/Tabelle aktualisieren.

- Quartalsweise: A/B‑Tests (Listenlänge, FAQ‑Antwortlänge), CRO‑Review (Heatmaps, Scrolltiefe), Governance‑Update.

Quellen/Referenzen zu Messbarkeit & Tracking

- Google erläutert AI‑Features, „Helpful Content“ und Snippet‑Kontrollen detailliert in der Entwicklerdoku.

- SEMrush (03/2025) beschreibt Prävalenz und Muster von AI Overviews.

- SISTRIX führt AIO‑Tracking/Filter im Produkt‑Changelog und Wissensbereich.

- Evergreen Media und SEO Südwest zeigen praxisnah, wie „Answer Engine Optimization“ und JS‑Rendering‑Themen die KI‑Sichtbarkeit beeinflussen.

Häufige Fehler – und schnelle Fixes

- Falsch gesetzte Snippet‑Kontrollen:

nosnippet,max-snippet,data-nosnippetblockieren versehentlich die wichtigsten Antwortblöcke. Fix: Nur gezielt einsetzen; Google dokumentiert die genaue Wirkweise und Beispiele. - Bots blockiert: GPTBot oder PerplexityBot ungewollt gesperrt; dadurch fehlen LLM‑Zitierungen. Fix: robots.txt prüfen; OpenAI beschreibt GPTBot‑Steuerung, Perplexity liefert Bot‑Guides.

- Fehlendes Markup: FAQPage/Product/Service/HowTo‑Schema nicht implementiert oder fehlerhaft. Fix: Validieren, nur reale Bewertungen/Reviews auszeichnen.

- Verdeckter Content durch JS/Paywalls/Interstitials: Crawler sehen die wichtigen Antworten nicht. Fix: Server‑Rendering/Hydration prüfen; kritische Infos offen zugänglich machen. SEO‑Fachbeiträge in DE zeigen die Probleme durch JS‑Rendering für KI‑Suche.

Vorlagen & Beispiele, die Sie sofort übernehmen können

Beispiel‑FAQ (H3 + 40–80 Wörter)

Wie unterscheidet sich das Produkt von Alternative X?

Kurzantwort (1–2 Sätze, 40–80 Wörter): Nennen Sie 2–3 klare Differenzierungsmerkmale mit Zahlen (z. B. Einrichtungszeit, Integrationen, SLA). Fügen Sie – falls vorhanden – einen neutralen Vergleichslink hinzu. Danach optional 1–2 Belege (Zertifikate, Case‑Links).

Mini‑Vergleichstabelle (transparent und zitierfähig)

| Kriterium | Ihre Lösung | Alternative A | Geeignet für |

|---|---|---|---|

| Einrichtungszeit | 7–10 Tage | 14–21 Tage | Teams mit engem Zeitplan |

| Integrationen | 12 native | 6 native | Stark API‑getriebene Workflows |

| SLA | 99,9 % | 99,5 % | Business‑kritische Umgebungen |

| Datenschutz | EU‑Hosting, ISO‑27001 | EU/US‑Mix | EU‑Compliance‑Fokus |

Snippet‑Kontrollen (Beispiel‑Snippet)

<!-- Sichtbare, zitierfähige FAQ-Antwort zulassen -->

<meta name="robots" content="max-snippet: 220">

<!-- Sensiblen Abschnitt optional ausschließen -->

<span data-nosnippet>Interne Preisdokumente (Login erforderlich)</span>

robots.txt (Bots bewusst steuern)

# GPTBot erlauben (OpenAI)

User-agent: GPTBot

Allow: /

# PerplexityBot erlauben

User-agent: PerplexityBot

Allow: /

# Google-Extended (Training) je nach Policy

User-agent: Google-Extended

Disallow:

Hinweis: Prüfen Sie vor Änderungen stets die aktuelle Dokumentation, da sich Bot‑Richtlinien ändern können.

Governance & Aktualisierung

- Verantwortlichkeiten: SEO/Content führt Struktur‑ und Datenpflege; Web‑Engineering verantwortet technische Hygiene (Rendering, Speed, Markup); Legal/Compliance bewertet Trainings‑Opt‑outs (z. B. Google‑Extended) und Datenverwendung.

- Aktualisierungszyklus: Alle 8–12 Wochen Inhalte und Markup aktualisieren; bei Produkt‑Releases sofort „Aktualisiert am“ hochziehen. Plattform‑Guides (Google, OpenAI, Perplexity) quartalsweise prüfen.

- Dokumentation: Changelog pflegen (was geändert, warum, welche Wirkung). Das erleichtert die A/B‑Auswertung und Beweisführung gegenüber Stakeholdern.

Quellen (ausgewählte, primäre Anlaufstellen)

- Google Developers – AI‑Features & Helpful Content: AI‑Features und Helpful Content (2024/2025)

- Google Developers – Robots‑Meta & Snippet Controls: Robots‑Meta/Indexierung und Snippet‑Steuerung (2024/2025)

- Google – Crawler & Google‑Extended: Übersicht der Crawler (2025)

- SEMrush – AI Overviews Study (03/2025): Prävalenz & Muster

- Backlinko – Leitfaden zu AI Overviews: Struktur & Beispiele (2024/2025)

- SISTRIX – AI Overviews: Grundlagen/Tracking und Changelog (2024/2025)

- Perplexity – Bots Guide: User‑Agent/robots und Deep Research: Funktionsweise (2024/2025)

- OpenAI – Approach to Data & AI: GPTBot & Media Manager (2024/2025)

- SEO Südwest – JS‑Rendering & KI‑Suche: Rendering‑Probleme (2025)

- Wolpersweb – Optimierung für AIO: Praxisleitfaden (2024)

Wichtig: Es gibt keine Garantie auf Zitierung – aber die oben beschriebenen Muster erhöhen die Chancen signifikant. Kombinieren Sie eine klare, modulare Struktur mit sauberen Snippet‑Kontrollen, verlässlichen Belegen und konsequentem Monitoring. So bleiben Ihre Produkt‑ und Service‑Seiten auch in der KI‑Suche sichtbar – und konvertieren besser.