AI Search Visibility Score: Definition & Berechnung erklärt

Was ist der AI Search Visibility Score? Schrittweise Berechnung & Vergleich mit SEO-Indizes. Alles zu Metrik, Formel, Signalen und Praxisbeispiel.

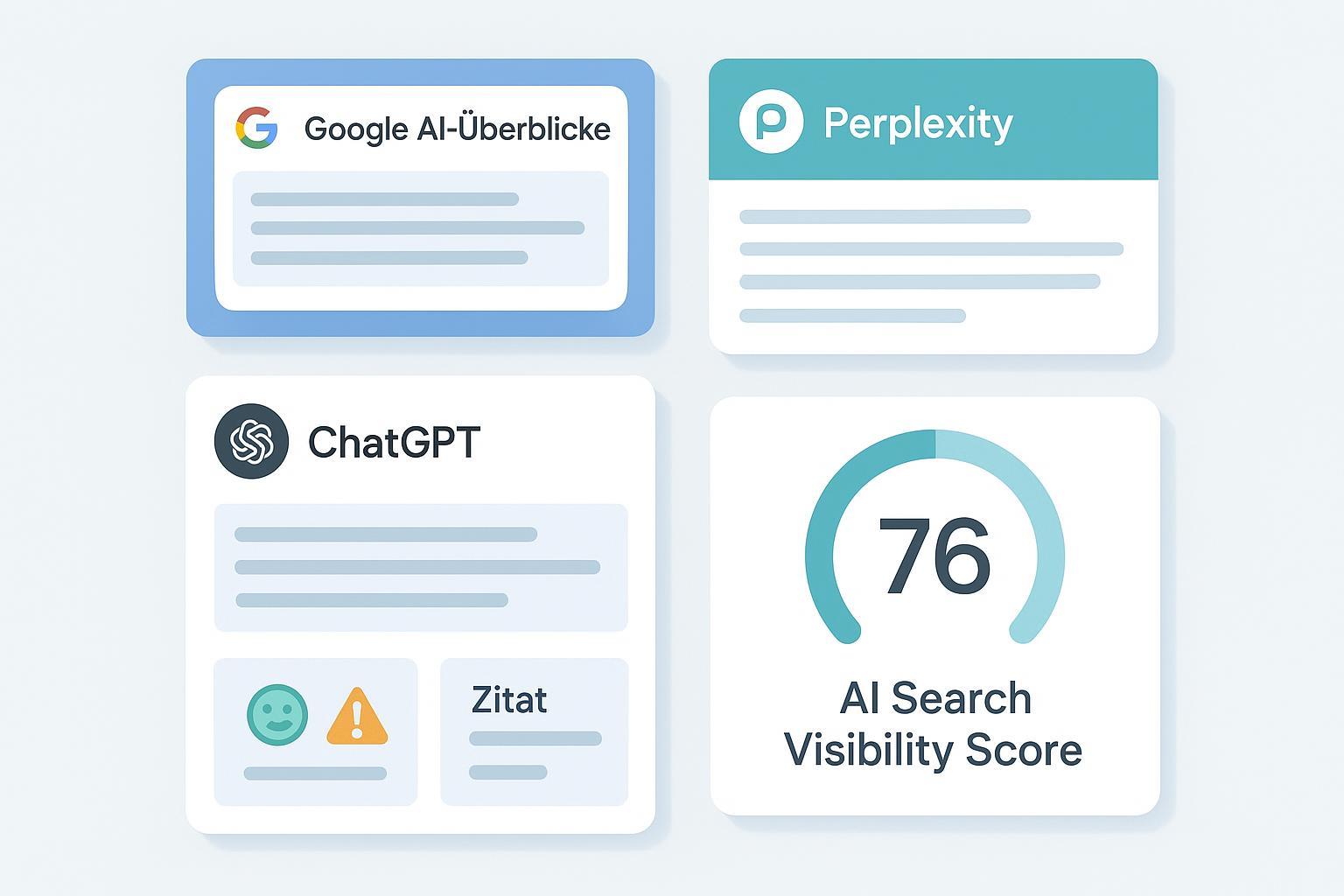

Wer in Google AI Overviews, Perplexity oder ChatGPT genannt oder zitiert wird, gewinnt Aufmerksamkeit – auch ohne klassische Rankings. Doch wie macht man diese Präsenz belastbar messbar, statt sie nur „gefühlt“ zu bewerten? Der AI Search Visibility Score gibt eine klare, reproduzierbare Antwort und ersetzt Blackbox‑Indizes durch eine offene Berechnungslogik.

Was der AI Search Visibility Score ist (und was nicht)

Kurz gesagt: Der AI Search Visibility Score misst, wie oft und wie prominent eine Marke/Domain in KI‑gestützten Antwortoberflächen erscheint – inklusive Link‑Zitierungen, namentlicher Erwähnungen, Tonalität und potenziellem Interaktionssignal. Er ist kein klassischer Positions‑Index aus der organischen Suche, sondern ein Präsenz‑ und Prominenzindex für generierte Antworten.

Als Referenz: Klassische Sichtbarkeitsindizes gewichten Rankings über Suchvolumen und positionsspezifische CTR. Das Prinzip beschreibt zvoove in der Erklärung „Was ist Sichtbarkeitsindex?“ (2024). Der AI‑Score überträgt diese Logik auf Antwort‑Modelle, ersetzt „Position“ durch „Präsenz/Prominenz“ und ergänzt Interaktions‑, Sentiment‑ und Aktualitätssignale.

Für Einsteiger:innen, die die Grundlagen der KI‑Sichtbarkeit nachlesen möchten: siehe „Was ist AI Visibility? Grundlagen und Brand Exposure in AI‑Suche erklärt“ (intern, engl.).

Messrahmen: Query‑Korb, Surfaces, Zeitfenster

Damit der Score aussagekräftig ist, braucht es einen klaren Messrahmen. Ausgangspunkt ist ein definierter Query‑Korb pro Markt und Intent (Brand/Non‑Brand; transaktional/informational). Pro Query wird auf mehreren „Surfaces“ gemessen, z. B. Google AI Overviews/AI‑Modus, Perplexity und ChatGPT bzw. ChatGPT‑Search. Der Score betrachtet einen festen Zeitraum (z. B. rollierende Wochen), denn LLM‑Antworten sind nicht deterministisch und können sich je Zeitpunkt unterscheiden.

Je Surface unterscheiden sich Präsentationsformen (Zitatenliste, Kacheln/Karussell, Inline‑Erwähnungen) und Interaktionsmöglichkeiten (anklickbare Links vs. reine Erwähnungen). Genau dort setzt das Signal‑Set an.

Signale und Formel: von der Einzelantwort zum Teilscore

Folgende Signale fließen pro Query × Surface ein:

- Präsenzstatus: 1, wenn Marke/Domain in der Antwort vorkommt; sonst 0.

- Zitierungsgrad: Anteil der Marken‑Zitierungen an allen zitierten Quellen (Share of Citations).

- Prominenzgewicht: Sichtbarkeit im sichtbaren Bereich (Top‑Zitation, Karussell‑Position, Inline‑Erwähnung) als Gewicht 0–1.

- Interaktionsfaktor: Klickpotenzial je Surface (anklickbare Quelle vorhanden? erwartbare Interaktion relativ höher/niedriger?).

- Sentimentfaktor: Tonalität der Antwortpassage (verstärkend bei positiv/vertrauensbildend, dämpfend bei negativ/kritisch).

- Recencyfaktor: Aktualitätsbonus, wenn die zitierte Quelle nachweislich frisch/zeitnah ist.

# Teilscore je Query q und Surface s

presence(q,s) ∈ {0,1}

citation_share(q,s) ∈ [0,1] # Anteil Marken‑Zitierungen

prominence_w(q,s) ∈ [0,1] # Sichtbarkeitsgewicht der Platzierung/Form

interaction_f(q,s) ∈ [0,1] # erwartbares Interaktionspotenzial dieser Surface

sentiment_f(q,s) ≥ 0 # z. B. leicht <1 bei negativ, >1 bei positiv (Methodenabhängig)

recency_f(q,s) ≥ 0 # Aktualitätsgewicht (Methodenabhängig)

partial_score(q,s) = presence(q,s)

× (citation_share(q,s) × prominence_w(q,s))

× interaction_f(q,s)

× sentiment_f(q,s)

× recency_f(q,s)

Wichtig: Die Skalierung der Faktoren (z. B. Bandbreiten für Sentiment/Recency) muss im Messprotokoll dokumentiert werden, damit Ergebnisse reproduzierbar bleiben.

Aggregation und Normalisierung (0–100)

Aus den Teilscores entsteht der Gesamtscore in drei Schritten:

- Surface‑Aggregation: Pro Query werden die Teilscores über Surfaces gewichtet gemittelt. Die Surface‑Gewichte w_s spiegeln Relevanz/Trafficanteile Ihrer Zielgruppe wider und summieren sich zu 1.

- Query‑Aggregation: Der Query‑Score ist das arithmetische Mittel über den Query‑Korb (optional: Intent‑Cluster separat ausweisen).

- Normalisierung: Um Vergleiche über Zeit/Marken zu erleichtern, wird der Rohwert auf eine 0–100‑Skala gebracht, z. B. Min‑Max‑Norm über den Query‑Korb eines Marktes oder anhand historischer Benchmarks.

Optional lässt sich ein „Share of Voice“ ableiten: Anteil aller Marken‑Zitierungen an den gesamten Zitierungen je Query/Surface. Dieser Wert eignet sich besonders für Wettbewerbsvergleiche.

Für die Auswahl passender Metriken und Benchmarks empfehlen wir die interne Vertiefung „AI‑Sichtbarkeit KPIs: Best Practices für Marken‑Erwähnungen und Zitierungen“.

Datenerhebung in der Praxis: Schritt‑für‑Schritt

Eine saubere Messung steht und fällt mit der Instrumentierung. So gehen viele Teams vor:

- Query‑Korb definieren und versionieren: Märkte, Sprachen, Intents, Brand/Non‑Brand. Messzeitraum und Sampling‑Frequenz festlegen (z. B. wöchentlich).

- Wiederholte Abfragen pro Surface fahren, Ergebnisse protokollieren: Zitationslisten/Kacheln, Inline‑Erwähnungen, Zeitstempel, Screenshots. Eine gute, methodische Übersicht gibt die kloos agency in „Visibility across ChatGPT, Perplexity and Google AI Overviews“ (2025).

- Tool‑Unterstützung evaluieren: Einige Anbieter tracken AI Overviews/Perplexity/ChatGPT inzwischen explizit, etwa laut Surfer: „New models in AI Tracker“ (2025). Prüfen Sie, welche Signale (Präsenz, Zitierung, Prominenz) tatsächlich erfasst werden.

- GSC‑Verknüpfung nutzen: Queries identifizieren, bei denen AI Overviews erscheinen, und Impressionen/Klicks mit AI‑Präsenzdaten kreuzen. Ein aktueller Überblick, wie häufig AIOs auftreten und wie sie sich verändern, findet sich in SE Ranking „AI Overviews 2024 Recap & 2025 Outlook“ (2025).

- Re‑Runs und Panel‑Stichproben planen: LLM‑Antworten variieren; erfassen Sie Konfidenzintervalle/Fehlerbalken und dokumentieren Sie alle Messannahmen.

Kalibrierung und Plausibilisierung

Die Rohwerte gewinnen, wenn sie mit vorhandenen Daten verknüpft werden. Typische Anker sind Google Search Console (Impressionen/Klicks) für Queries mit AIOs und klassische Domain‑Sichtbarkeit (SISTRIX/SEMrush), um Trends gegenzuprüfen. Unterschiede zwischen Surfaces spielen hinein: Studien zeigen, dass Perplexity meist linkstärker agiert, während ChatGPT/Google die Interaktion teils stärker im Text binden. Einen Vergleich der Plattformen bietet SE Ranking: „ChatGPT vs Perplexity vs Google vs Bing – Comparison Research“ (2025).

Auch die Quellenpräferenzen sind nicht identisch: Profound analysiert in „AI Platform Citation Patterns“ (2025), welche Publisher in welchen Systemen überdurchschnittlich häufig zitiert werden. Solche Muster sollten in die Gewichtung/Interpretation einfließen – zum Beispiel, indem Sie Surface‑Gewichte oder Prominenzschwellen anpassen.

Varianz macht Kalibrierung nötig: Prüfen Sie Korrelationen zwischen AI‑Score und GSC‑Signalen, definieren Sie sinnvolle Alert‑Schwellen und vermeiden Sie Überreaktionen auf Einzelwerte. Denken Sie an die Frage: Verändert sich die Sichtbarkeit konsistent über mehrere Surfaces gleichzeitig – oder sehen wir nur Zufallsrauschen?

Vergleich: klassischer SEO‑Sichtbarkeitsindex vs. AI‑Score

| Merkmal | Klassischer Sichtbarkeitsindex | AI Search Visibility Score |

|---|---|---|

| Messobjekt | Ranking‑Positionen in SERPs | Präsenz/Prominenz in generierten Antworten |

| Grundgewicht | Suchvolumen × Positions‑CTR | Zitierungsanteil × Prominenz × Interaktion |

| Einheit | Index (z. B. 0–100) | Index (0–100) |

| Datenquelle | SERP‑Scraping/Rank‑Tracker | Antwort‑Snapshots auf AI‑Surfaces |

| Klicksignal | Implizit über CTR‑Kurven | Surface‑spezifischer Interaktionsfaktor |

| Aktualität | Indirekt (Re‑Crawls, Ranking‑Volatilität) | Expliziter Recencyfaktor je Zitation |

| Tonalität | Nicht berücksichtigt | Sentimentfaktor als Verstärker/Dämpfer |

Grenzen, Fairness und Compliance

Es gibt keine absolute „Wahrheit“ in LLM‑Antworten. Personalisierung, Zeitpunkt, Prompt‑Varianz und Modell‑Updates beeinflussen Ergebnisse. Deshalb sind wiederholte Messungen, Konfidenzintervalle und lückenlose Dokumentation Pflicht. Nicht jede Surface liefert CTR–Daten; trennen Sie sauber zwischen „AI‑Impression“ (Erwähnung/Zitation) und tatsächlichem Traffic. In sensiblen YMYL‑Verticals (Medizin/Finanzen) gilt: Quellenautorität besonders streng prüfen, keine überzogenen Wirkversprechen, konservative Gewichtungen.

Kurzes Praxisbeispiel (neutral)

Offenlegung: Geneo ist unser Produkt. In vielen Teams wird ein wöchentlicher Query‑Korb über Google AI Overviews, Perplexity und ChatGPT beobachtet. Erfasst werden Präsenzstatus, Zitierungsanteile, Platzierungsmerkmale (z. B. Top‑Zitation vs. Kachel 3), etwaige Link‑Klickoptionen sowie Tonalität der Antwortpassagen. Aus diesen Snapshots entsteht pro Query × Surface ein Teilscore gemäß Formel; anschließend werden Surface‑Gewichte nach Zielgruppenrelevanz gesetzt und der Wert über den Korb gemittelt und auf 0–100 normalisiert. So lassen sich Zeitreihen vergleichen und Wettbewerbs‑Sichtbarkeit als Share‑of‑Voice ergänzen – ohne auf nicht dokumentierte Blackbox‑Metriken angewiesen zu sein.

Nächste Schritte

Wenn Sie starten, definieren Sie zunächst den Query‑Korb und ein wöchentliches Messprotokoll, legen Sie Surface‑Gewichte fest, dokumentieren Sie alle Faktoren (inkl. Sentiment/Recency) und planen Sie Re‑Runs für Varianzschätzung. Vertiefende KPI‑Hinweise finden Sie im internen Beitrag oben; für die strategische Roadmap empfehlen wir zudem „How to Prepare for a 50% Organic Search Traffic Drop by 2028“ (intern, engl.). Und nun die Praxisfrage: Welche drei Queries würden in Ihrem Markt die größte Aussagekraft für einen ersten, kleinen Pilot‑Score liefern?